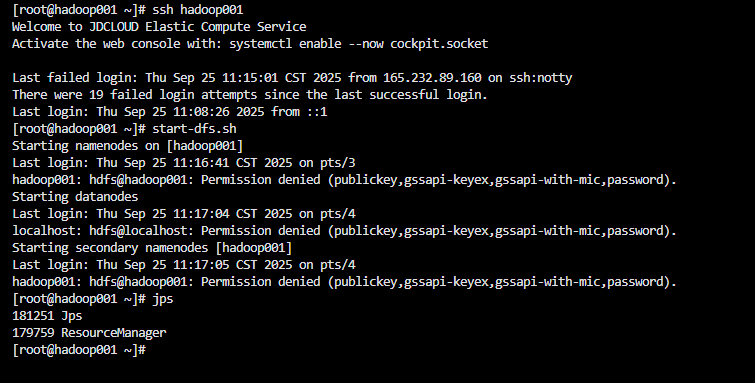

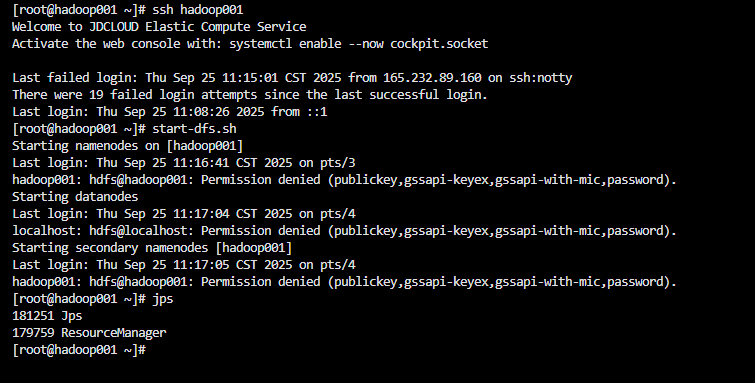

想问下,centos8.2下,配置启动 Hadoop,SSH免密登录成功,但是start-dfs.sh 启动一直提示无权限是什么问题?

想问下,centos8.2下,配置启动 Hadoop,SSH免密登录成功,但是start-dfs.sh 启动一直提示无权限是什么问题?

上午好☀️☀️☀️️

本答案参考通义千问

在 CentOS 8.2 环境下配置 Hadoop 时,即使 SSH 免密登录成功,执行 start-dfs.sh 时仍提示“无权限”,这通常与以下几个方面有关:

Hadoop 用户权限不足

hadoop 或 root)。user1),可能会因权限不足而无法启动 Hadoop。Hadoop 安装路径或文件权限问题

/usr/local/hadoop)或相关配置文件(如 hdfs-site.xml、core-site.xml)可能没有正确的读写权限。Hadoop 日志中存在具体错误信息

/usr/local/hadoop/logs/)中的错误信息,例如:

java.io.IOException: Permission denied

Hadoop 启动脚本的执行权限

start-dfs.sh 是否有可执行权限:

ls -l /usr/local/hadoop/sbin/start-dfs.sh

Hadoop 配置文件设置不正确

hdfs-site.xml 中的 dfs.namenode.name.dir 和 dfs.datanode.data.dir 路径是否具有写入权限。建议使用 hadoop 用户(推荐方式):

sudo useradd hadoop

sudo passwd hadoop

sudo su - hadoop

或者使用 root 用户(仅限测试环境):

sudo su -

注意: 在生产环境中,不要以

root用户运行 Hadoop。

确保 Hadoop 安装目录及其子目录对当前用户具有读写权限:

sudo chown -R hadoop:hadoop /usr/local/hadoop

sudo chmod -R 755 /usr/local/hadoop

hdfs-site.xml 和 core-site.xml 文件的权限:sudo chown hadoop:hadoop /usr/local/hadoop/etc/hadoop/hdfs-site.xml

sudo chown hadoop:hadoop /usr/local/hadoop/etc/hadoop/core-site.xml

sudo chmod 644 /usr/local/hadoop/etc/hadoop/*.xml

start-dfs.sh 执行权限sudo chmod +x /usr/local/hadoop/sbin/start-dfs.sh

Hadoop 日志默认位于:

/usr/local/hadoop/logs/

查看最近的日志文件(如 hadoop-hadoop-namenode-centos8.log):

tail -n 50 /usr/local/hadoop/logs/hadoop-hadoop-namenode-centos8.log

core-site.xml:<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

hdfs-site.xml:<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>/usr/local/hadoop/data/namenode</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/usr/local/hadoop/data/datanode</value>

</property>

</configuration>

注意: 确保这些目录已创建,并且具有写入权限。

mkdir -p /usr/local/hadoop/data/namenode

mkdir -p /usr/local/hadoop/data/datanode

sudo chown -R hadoop:hadoop /usr/local/hadoop/data

sudo chmod -R 755 /usr/local/hadoop/data

hdfs-site.xml<configuration>

<property>

<name>dfs.namenode.name.dir</name>

**<value>/usr/local/hadoop/data/namenode</value>**

</property>

<property>

<name>dfs.datanode.data.dir</name>

**<value>/usr/local/hadoop/data/datanode</value>**

</property>

</configuration>

core-site.xml<configuration>

<property>

<name>fs.defaultFS</name>

**<value>hdfs://localhost:9000</value>**

</property>

</configuration>

| 问题点 | 解决方法 |

|--------|----------|

| 用户权限不足 | 使用 hadoop 用户或 root 启动 |

| Hadoop 目录权限 | 修改 /usr/local/hadoop 权限为 hadoop:hadoop |

| 配置文件权限 | 设置 *.xml 文件为 644 权限 |

| 启动脚本权限 | 添加 +x 执行权限 |

| 日志分析 | 查看 /usr/local/hadoop/logs/ 中的错误信息 |

如果你能提供具体的错误日志内容,我可以进一步帮助你定位问题。