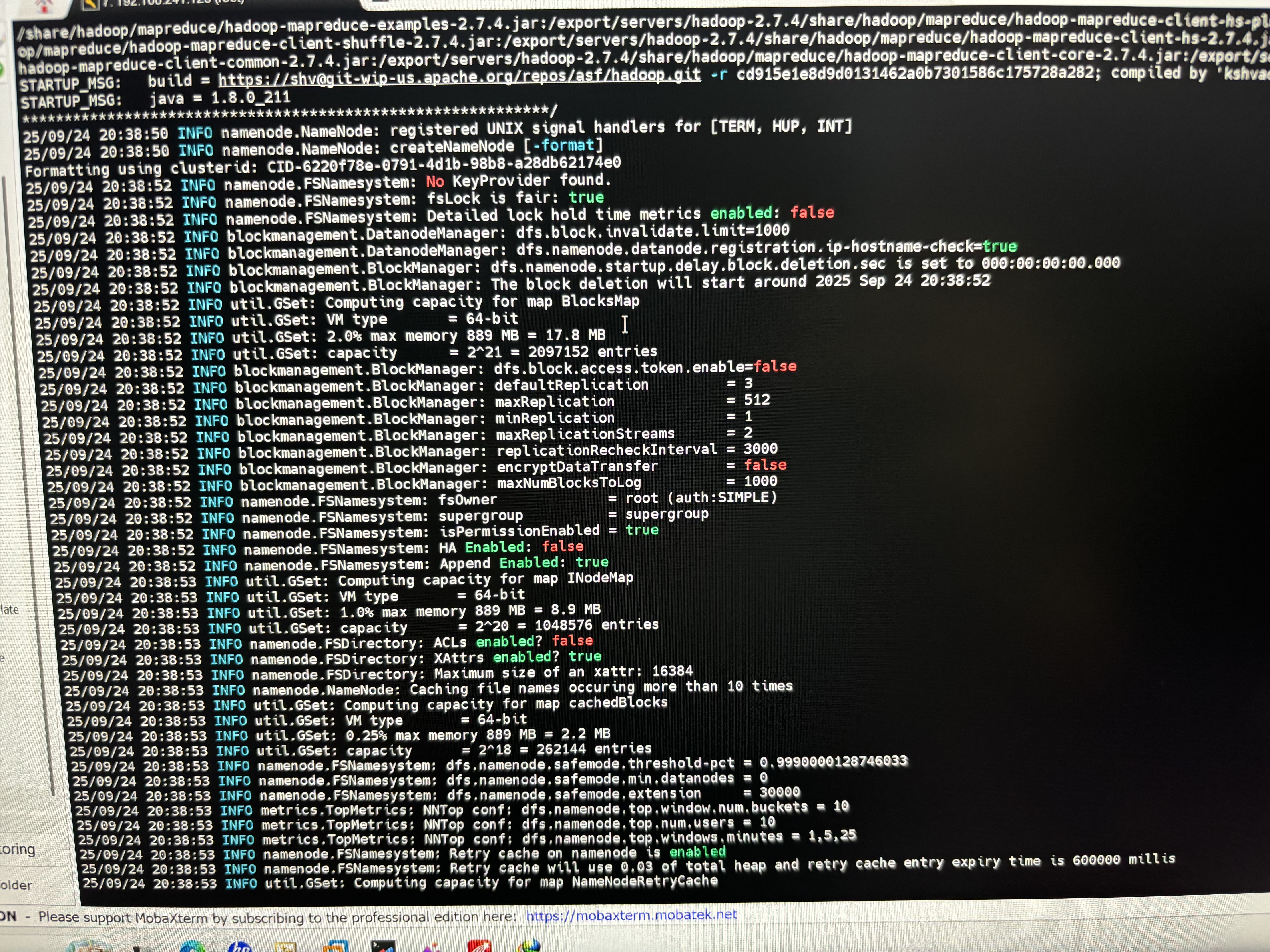

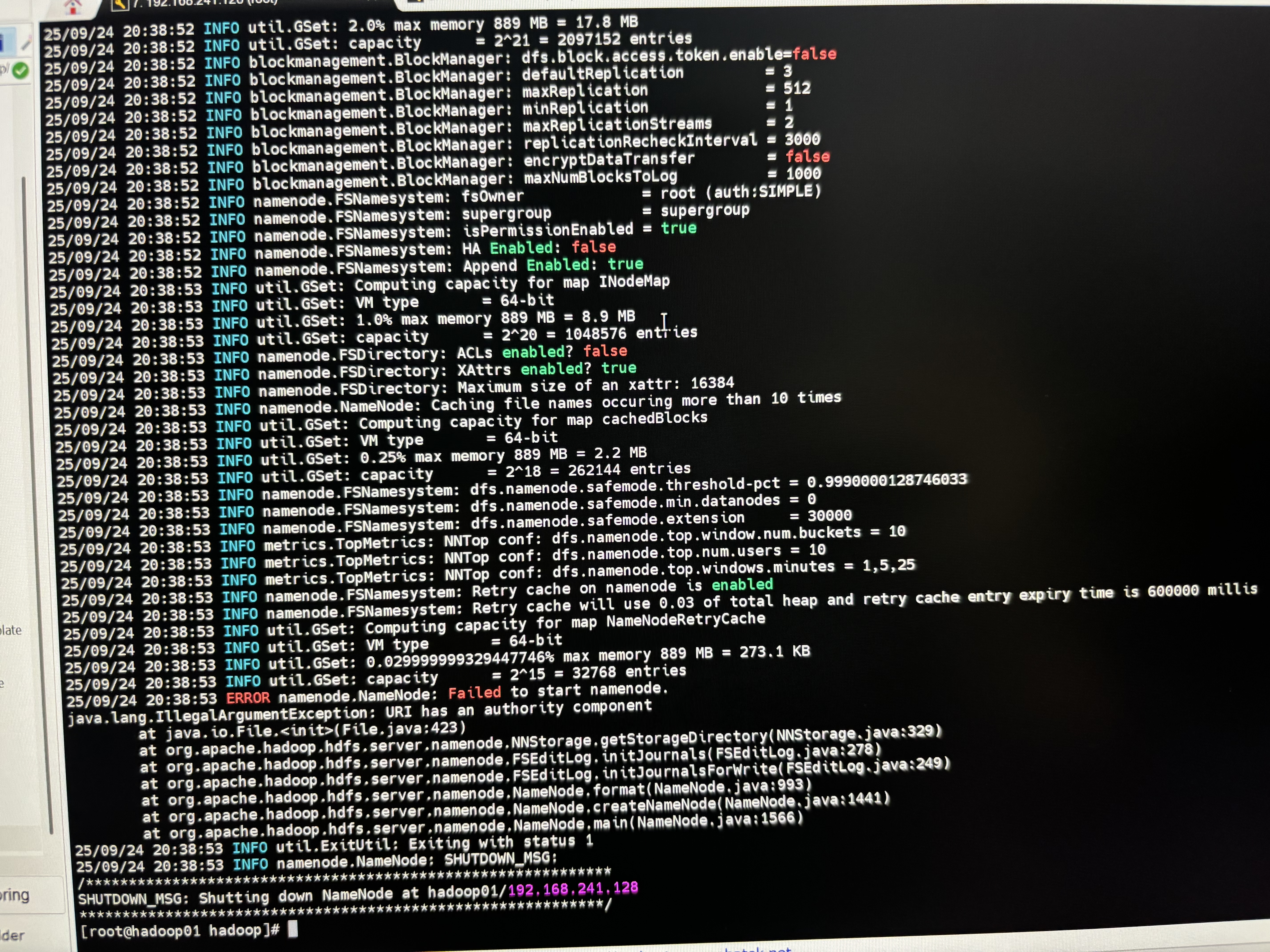

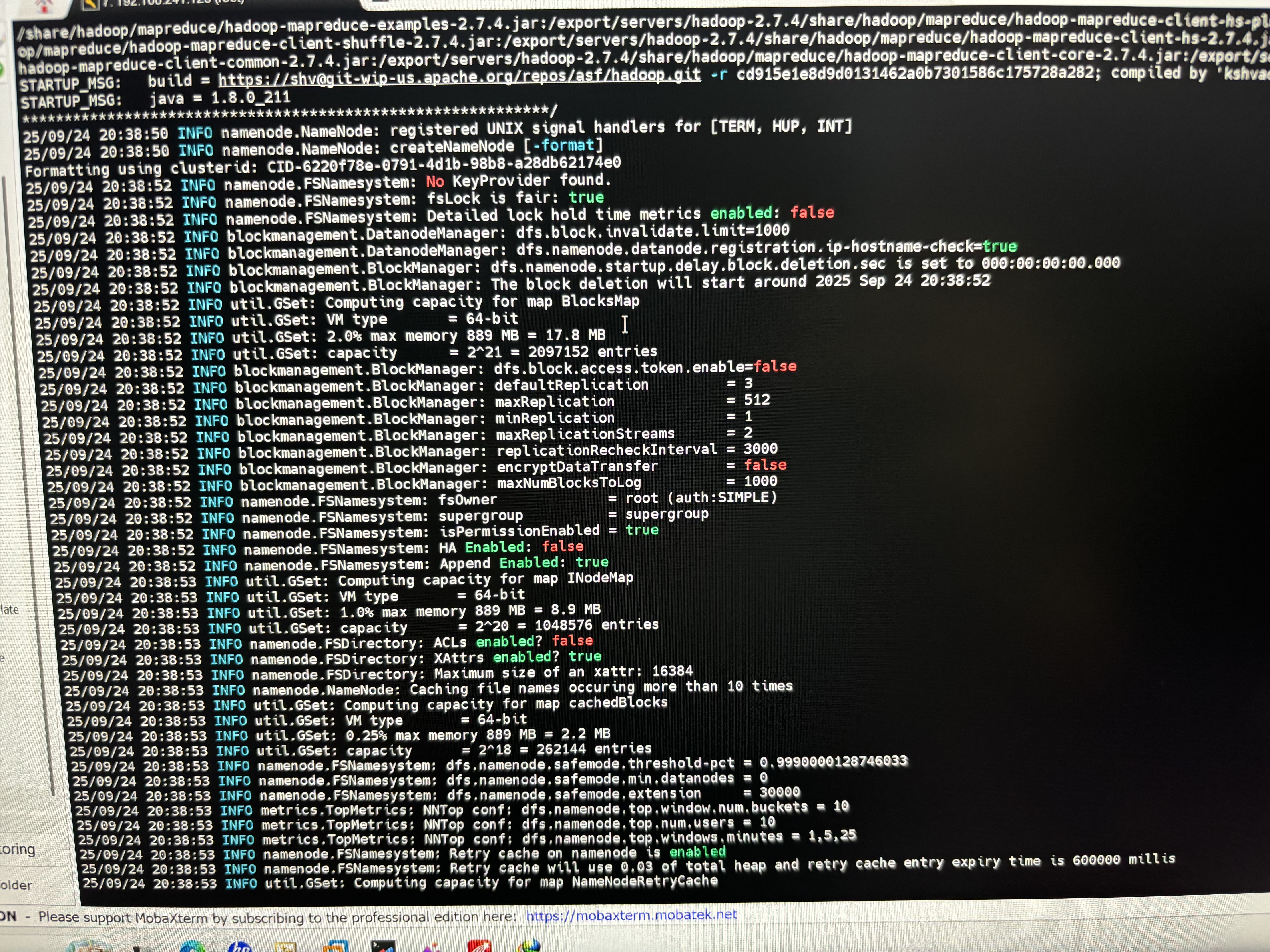

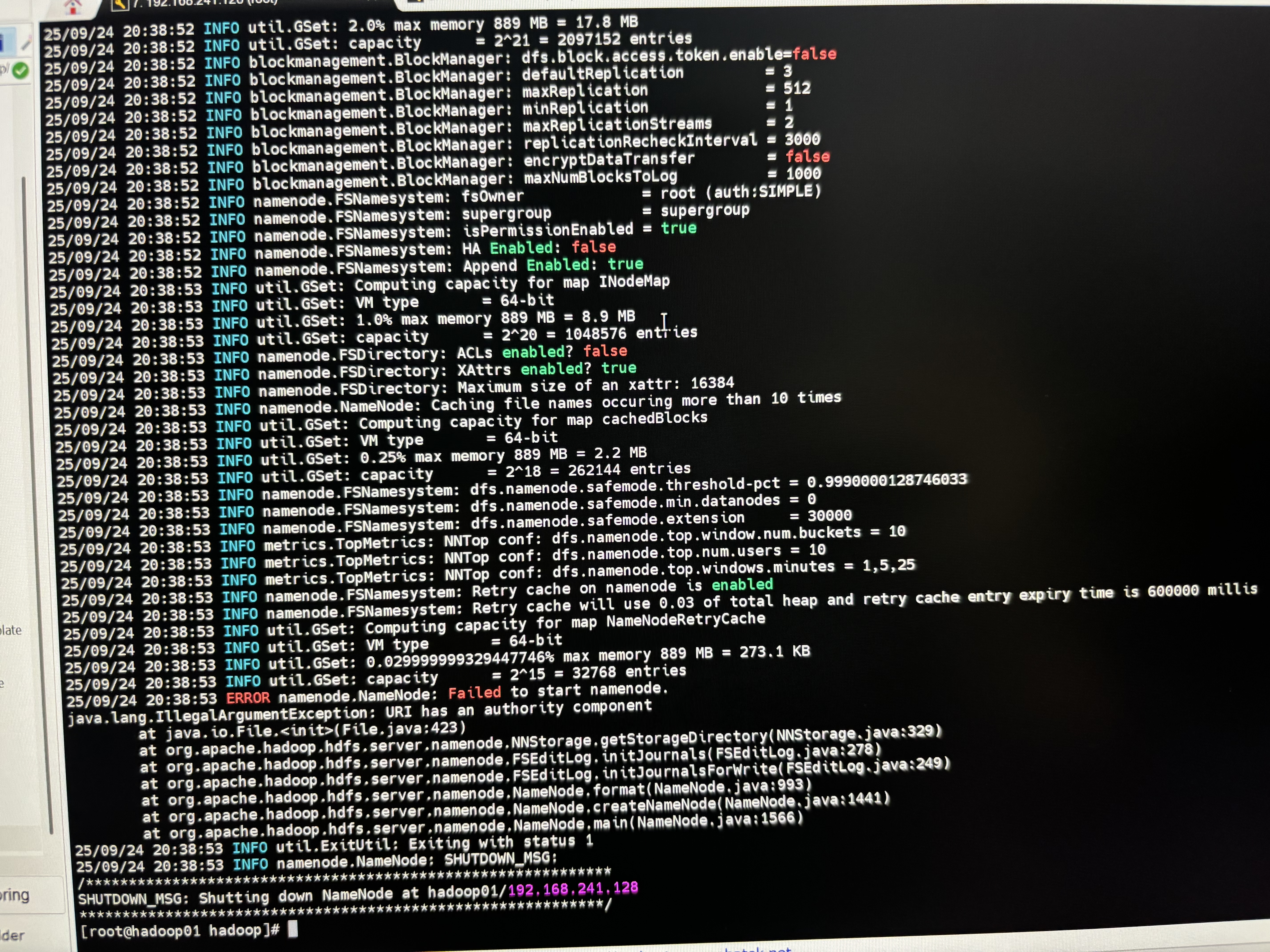

Hadoop集群的搭建按照步骤一步一步来的,但是格式化的时候就是显示错误,实在找不出是哪里错了,有没有明白人帮我看看

Hadoop集群的搭建按照步骤一步一步来的,但是格式化的时候就是显示错误,实在找不出是哪里错了,有没有明白人帮我看看

中午好🌞🌞🌞

本答案参考通义千问

在搭建 Hadoop 集群的过程中,格式化是一个非常关键的步骤。如果在 hdfs dfsadmin -format 或者 hadoop namenode -format 时出现错误,可能是由以下几个原因引起的。下面我将详细分析可能的问题,并提供解决方案。

现象:

ERROR: User "your_user" is not allowed to impersonate anonymous

原因:

core-site.xml 中配置了 hadoop.proxyuser.*.hosts 和 hadoop.proxyuser.*.groups 没有正确设置。解决方案:

core-site.xml 中添加以下内容:<property>

<name>hadoop.proxyuser.hadoop.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.hadoop.groups</name>

<value>*</value>

</property>

注意: 这只是一个临时解决方案,用于测试环境。生产环境中应根据实际用户和组进行限制。

现象:

Error: java.io.IOException: Cannot create directory ...

原因:

/data/hdfs/namenode)不存在。解决方案:

mkdir -p /data/hdfs/namenode

chown -R your_user:your_group /data/hdfs/namenode

chmod -R 755 /data/hdfs/namenode

hdfs-site.xml 中的 dfs.namenode.name.dir 指向正确的路径。现象:

Error: Could not find or load main class org.apache.hadoop.util.RunJar

原因:

解决方案:

java -version

JAVA_HOME 环境变量(以 Ubuntu 为例):export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64

JAVA_HOME 添加到 hadoop-env.sh 文件中:export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64

现象:

原因:

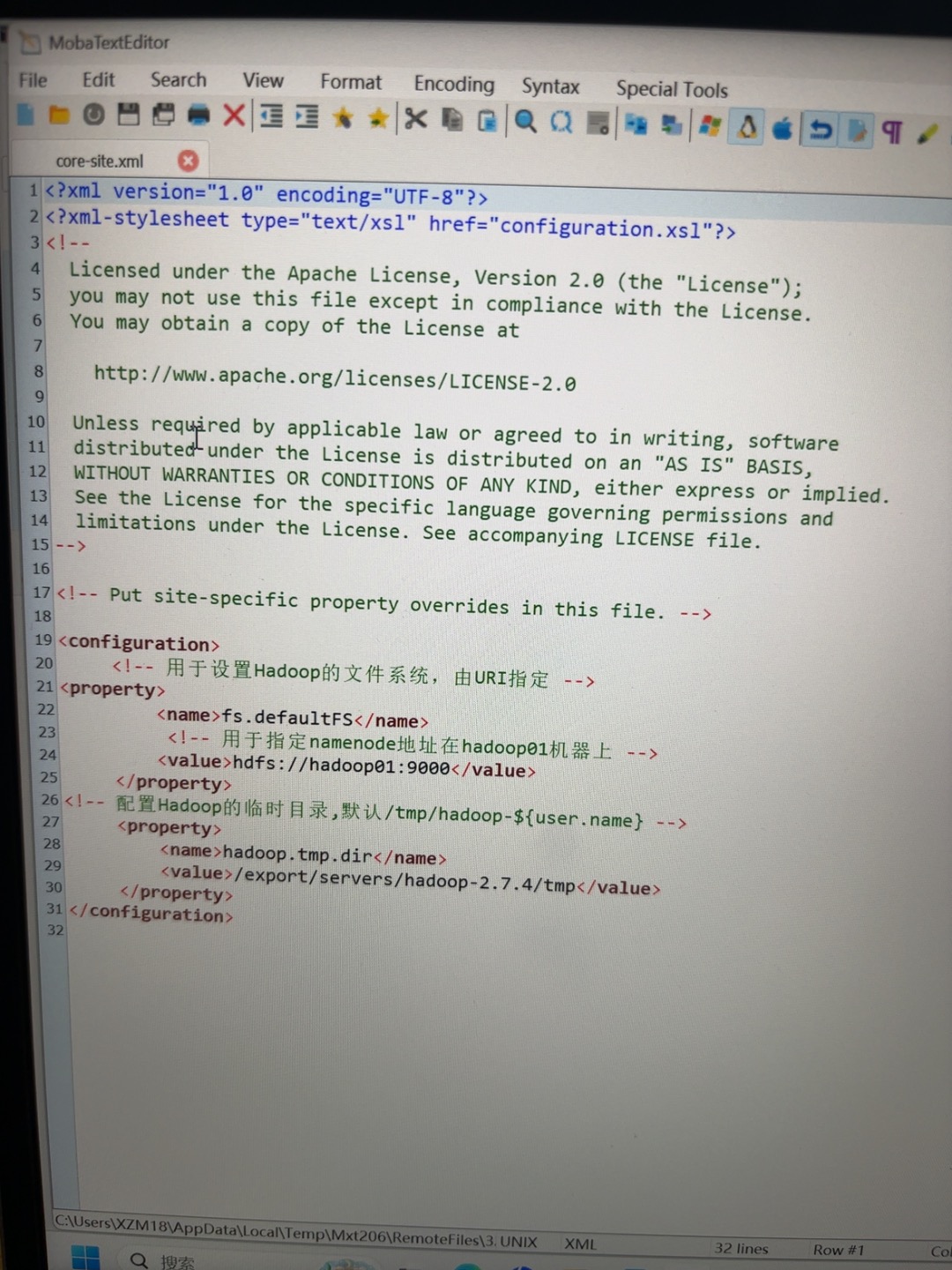

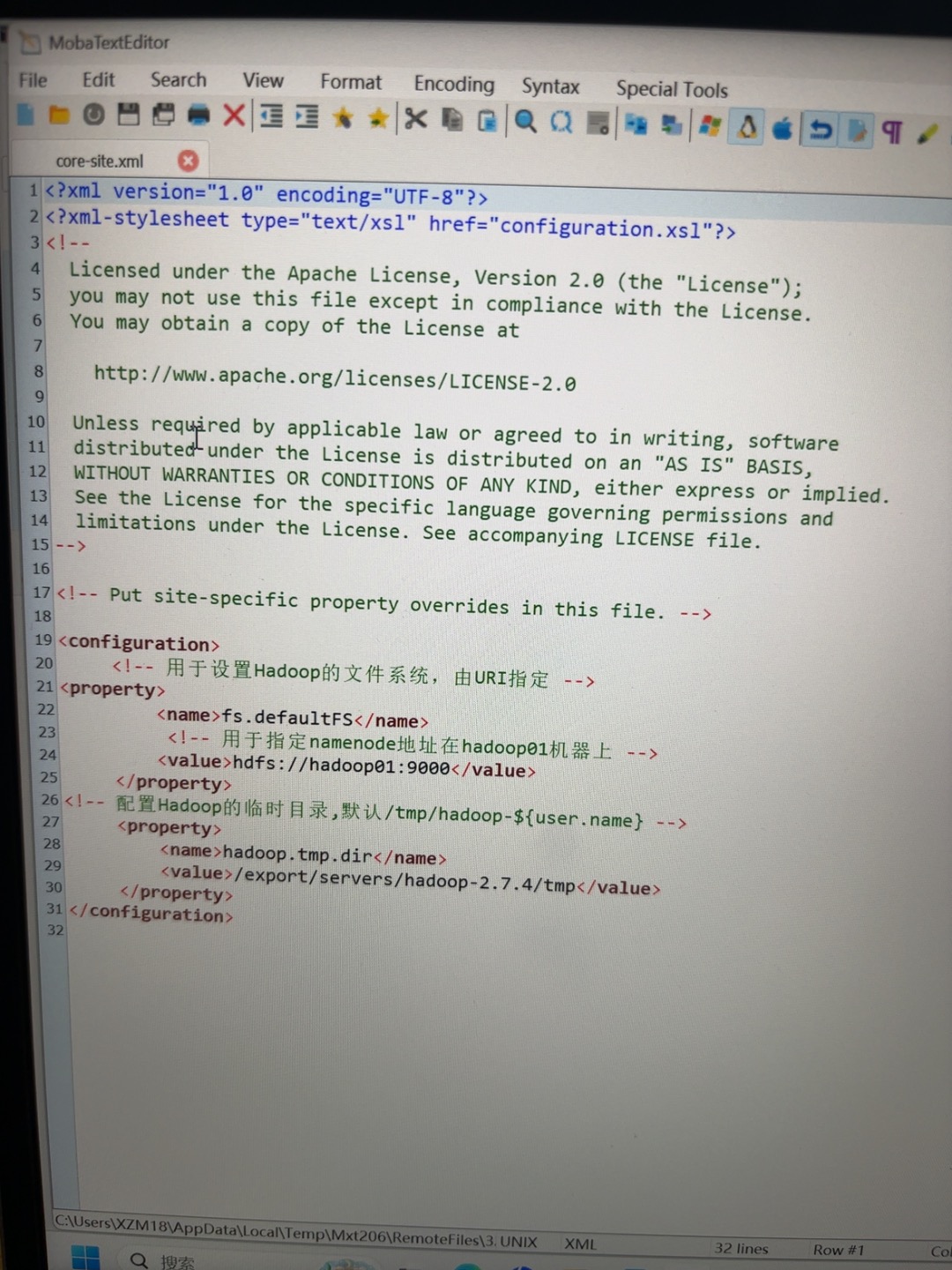

hadoop-env.sh、core-site.xml、hdfs-site.xml 等配置文件存在语法错误或路径错误。解决方案:

检查 hadoop-env.sh 是否设置了 HADOOP_HOME 和 JAVA_HOME。

检查 core-site.xml 和 hdfs-site.xml 中的配置是否与集群一致。

示例 core-site.xml:

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

hdfs-site.xml:<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>/data/hdfs/namenode</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/data/hdfs/datanode</value>

</property>

</configuration>

现象:

Already formatted.

原因:

解决方案:

rm -rf /data/hdfs/namenode/*

hadoop namenode -format

检查权限问题

core-site.xml 中的代理用户配置。确保 HDFS 数据目录存在且可访问

确认 Java 环境配置正确

JAVA_HOME 并验证 Java 版本。检查 Hadoop 配置文件

core-site.xml 和 hdfs-site.xml 配置正确。避免重复格式化

$HADOOP_HOME/logs/)可以获取更详细的错误信息。sudo 执行格式化命令可以绕过权限问题。如果你愿意提供具体的错误信息,我可以帮你进一步定位问题。希望这些方法对你有帮助!