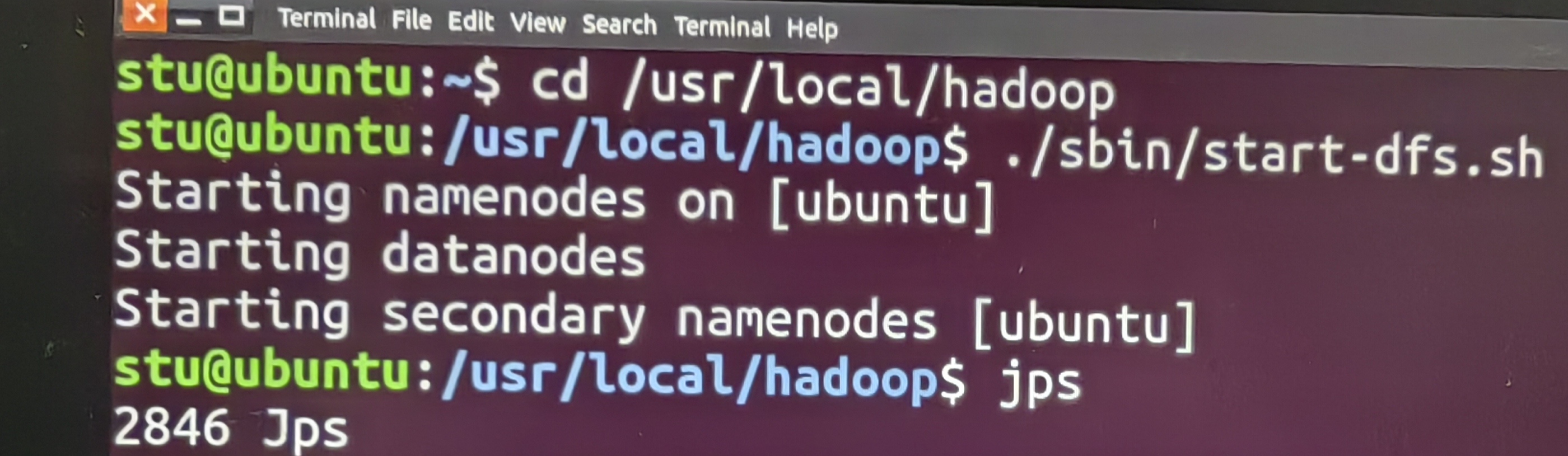

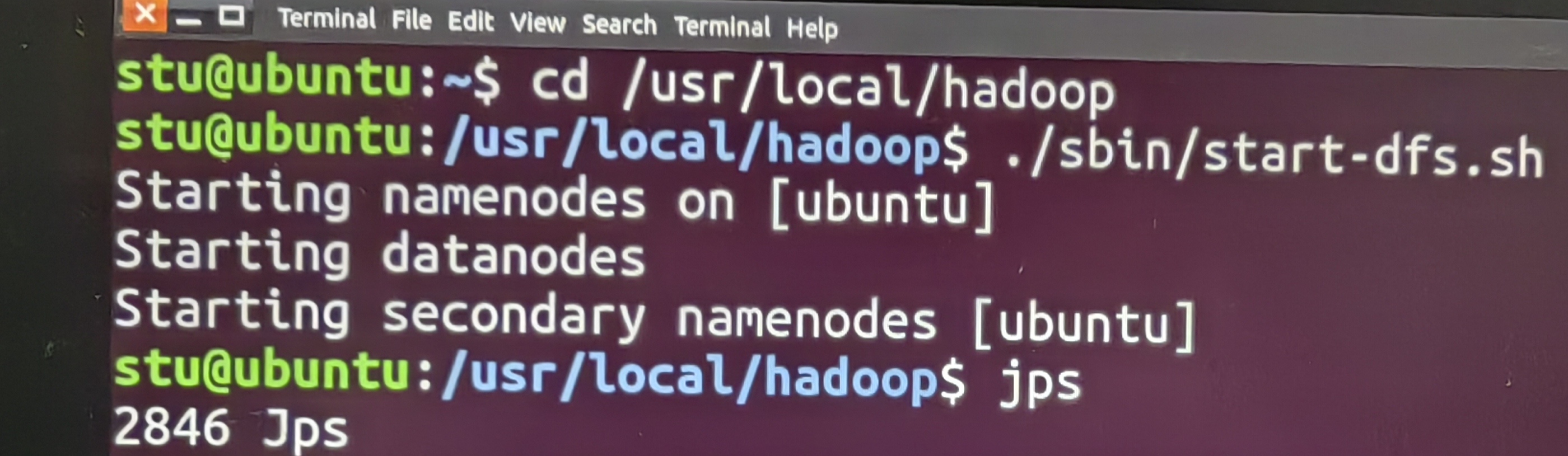

根据步骤安装完SSH,Java和Hadoop后运行命令jps未出现NameNode、DataNode和SecondaryNode,前面运行没看出来有什么问题,查看问题所在应该怎么做怎么解决

根据步骤安装完SSH,Java和Hadoop后运行命令jps未出现NameNode、DataNode和SecondaryNode,前面运行没看出来有什么问题,查看问题所在应该怎么做怎么解决

关注

关注让【宝码香车】来帮您解答,本回答参考DeepSeek编写,并整理提供。

如果答案让您满意,请采纳、点赞、关注,非常感谢!

.

每日一句正能量,让它带给您好心情:路是自己走出来的,机会是自己创造的。

.

根据您提供的信息,Hadoop启动后jps命令未显示NameNode、DataNode和SecondaryNameNode进程。这是一个常见的Hadoop安装问题,以下是系统性的排查步骤:

首先查看Hadoop的日志文件,这是最直接的排查方法:

# 查看NameNode日志

cat /usr/local/hadoop/logs/hadoop-stu-namenode-ubuntu.log

# 查看DataNode日志

cat /usr/local/hadoop/logs/hadoop-stu-datanode-ubuntu.log

# 查看SecondaryNameNode日志

cat /usr/local/hadoop/logs/hadoop-stu-secondarynamenode-ubuntu.log

重点关注日志中的ERROR和WARN级别的信息。

检查启动脚本是否真正成功启动了服务:

# 重新启动HDFS服务并观察输出

/usr/local/hadoop/sbin/stop-dfs.sh

/usr/local/hadoop/sbin/start-dfs.sh

# 检查进程是否存活

ps -ef | grep hadoop

常见的配置问题会导致进程无法启动:

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://ubuntu:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop/tmp</value>

</property>

</configuration>

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>/usr/local/hadoop/hdfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/usr/local/hadoop/hdfs/data</value>

</property>

</configuration>

确保本地SSH连接正常工作:

# 测试本地SSH连接

ssh localhost

# 如果需要密码,重新设置SSH密钥

ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

chmod 0600 ~/.ssh/authorized_keys

验证JAVA_HOME配置是否正确:

# 检查Java安装

java -version

javac -version

# 检查Hadoop环境配置

cat /usr/local/hadoop/etc/hadoop/hadoop-env.sh | grep JAVA_HOME

# 确保JAVA_HOME设置正确(根据实际路径修改)

export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64

如果是首次安装,需要格式化NameNode:

# 停止所有服务

/usr/local/hadoop/sbin/stop-dfs.sh

# 格式化NameNode(注意:这会清除所有数据)

/usr/local/hadoop/bin/hdfs namenode -format

# 重新启动服务

/usr/local/hadoop/sbin/start-dfs.sh

确保相关端口没有被防火墙阻挡:

# 检查Hadoop相关端口是否监听

netstat -tlnp | grep java

# 应该看到50070(NameNode HTTP), 50090(SecondaryNameNode)等端口

检查目录权限:

# 确保Hadoop目录权限正确

sudo chown -R stu:stu /usr/local/hadoop

chmod -R 755 /usr/local/hadoop

创建一个诊断脚本快速检查常见问题:

#!/bin/bash

echo "=== Hadoop进程诊断 ==="

jps

echo -e "\n=== Java环境检查 ==="

echo "JAVA_HOME: $JAVA_HOME"

java -version 2>&1 | head -3

echo -e "\n=== SSH连接测试 ==="

ssh -o ConnectTimeout=5 localhost exit

if [ $? -eq 0 ]; then

echo "SSH连接: 正常"

else

echo "SSH连接: 失败"

fi

echo -e "\n=== 端口监听检查 ==="

netstat -tlnp | grep -E ':(50070|50090|9000)'

保存为hadoop_diagnose.sh并运行:

chmod +x hadoop_diagnose.sh

./hadoop_diagnose.sh

请按照以上步骤逐一排查,通常可以解决大部分Hadoop启动问题。如果仍有问题,请提供具体的错误日志信息。