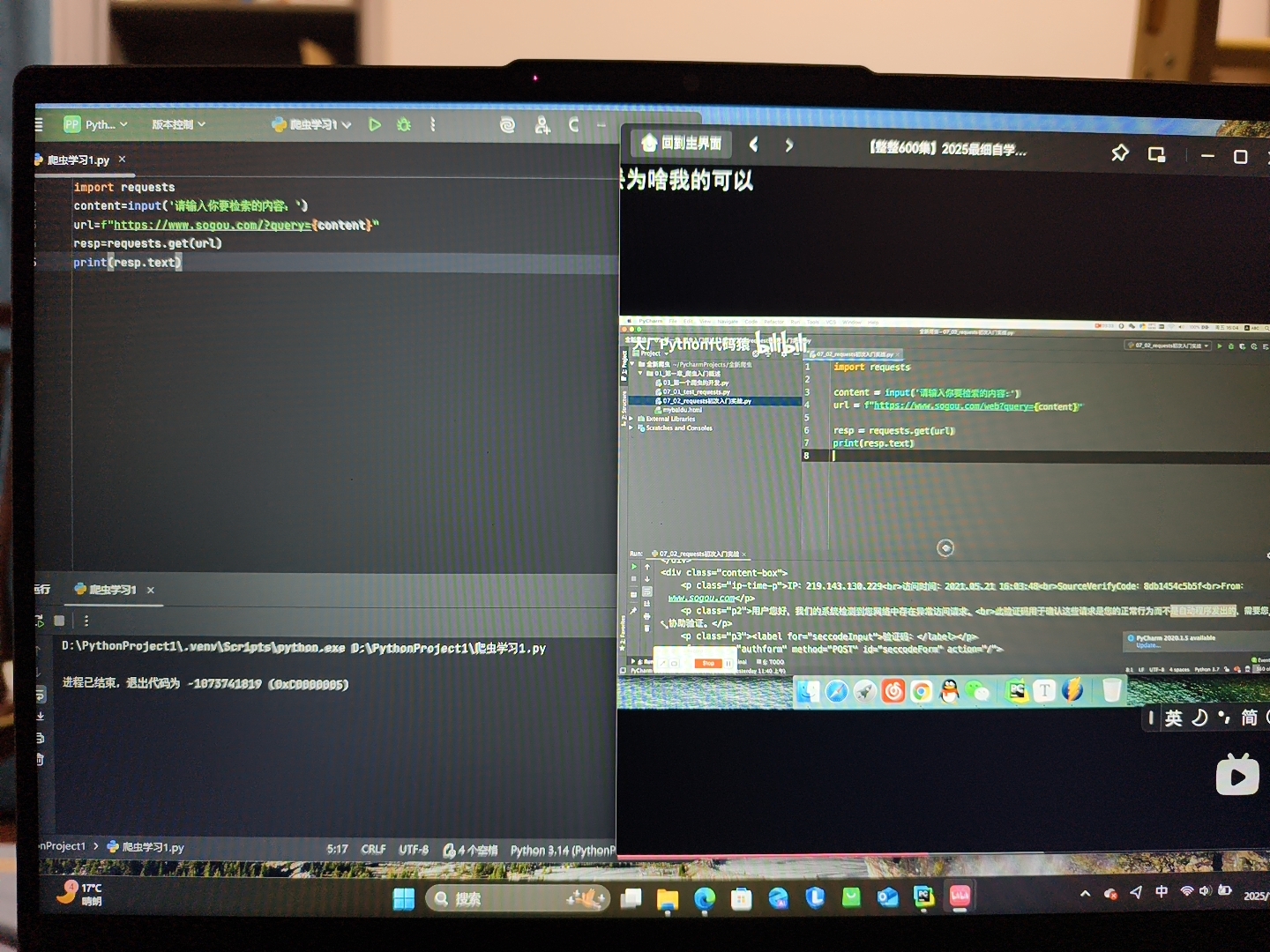

这个是一个很低级的爬虫代码,但是不知道为什么一样的代码,但是和这个博主运行的结果不一样,不知道哪里出了问题

晚上好🌙🌙🌙

本答案参考通义千问

你提到“这是一个很低级的爬虫代码”,但不知道为什么和博主运行的结果不一样。这种问题在爬虫开发中非常常见,可能是由于以下几个原因导致的:

网站结构变化

soup.select("div.content"))找不到内容。请求头缺失或不正确

User-Agent,服务器可能会拒绝你的请求,返回错误页面或空内容。headers 参数,模拟浏览器访问。动态加载内容

requests 库无法获取到这些内容。Selenium 或 Playwright 模拟浏览器行为。IP 被封禁或反爬机制

编码问题

response.encoding 不一致,导致解析失败。response.encoding = 'utf-8' 或其他编码方式。网络环境问题

确认目标网页是否可访问

print(response.status_code) 查看响应状态码(如 200 表示成功)。打印响应内容

print(response.text),查看实际返回的内容是否是你期望的。检查 HTML 结构

soup.select("div.content"))与实际结构匹配。添加 User-Agent 请求头

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36"

}

response = requests.get(url, headers=headers)

处理动态内容

Selenium:from selenium import webdriver

driver = webdriver.Chrome()

driver.get(url)

content = driver.find_element_by_class_name("content").text

print(content)

driver.quit()

调试输出关键变量

response.status_code、response.url、response.text,帮助定位问题。假设你的原始代码如下:

import requests

from bs4 import BeautifulSoup

url = "https://example.com"

response = requests.get(url)

soup = BeautifulSoup(response.text, "html.parser")

content = soup.select("div.content")

print(content)

修改后版本:

import requests

from bs4 import BeautifulSoup

url = "https://example.com"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36"

}

try:

response = requests.get(url, headers=headers, timeout=10)

response.raise_for_status() # 检查请求是否成功

print(f"Status Code: {response.status_code}")

print(f"Response URL: {response.url}")

# 设置正确的编码

response.encoding = 'utf-8'

soup = BeautifulSoup(response.text, "html.parser")

# 检查 HTML 内容

print("HTML Content:")

print(response.text[:500]) # 打印前500个字符

# 获取目标内容

content = soup.select("div.content")

if content:

for item in content:

print(item.get_text(strip=True))

else:

print("未找到目标内容,请检查选择器。")

except Exception as e:

print(f"发生异常: {e}")

| 问题 | 解决方案 |

|------|----------|

| 网站结构变化 | 使用浏览器开发者工具更新选择器 |

| 请求头缺失 | 添加 User-Agent 请求头 |

| 动态加载内容 | 使用 Selenium 或 Playwright |

| 编码问题 | 设置 response.encoding |

| 反爬机制 | 使用代理 IP 或降低请求频率 |

如果你愿意提供具体的代码片段或目标网页地址,我可以进一步帮你分析问题所在。