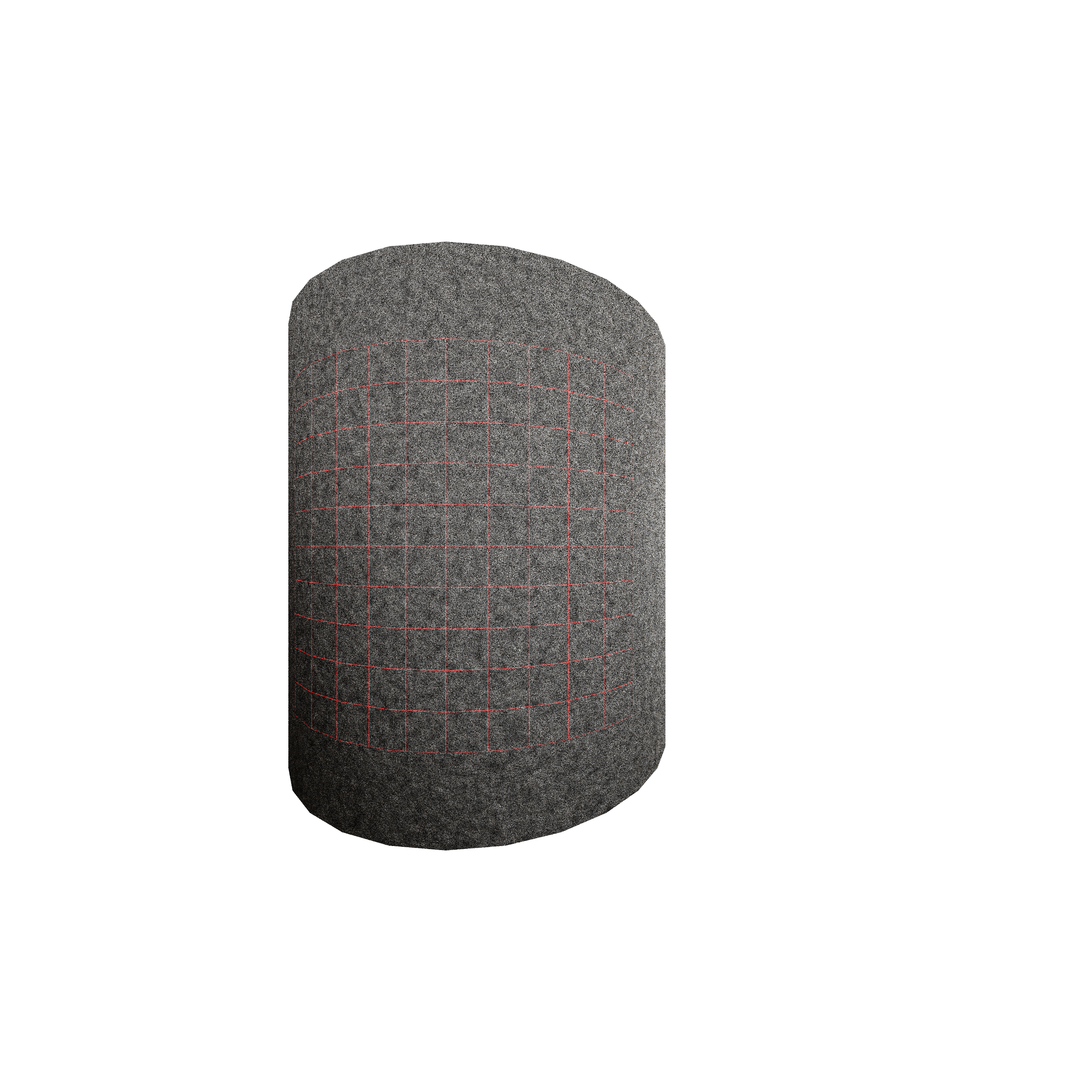

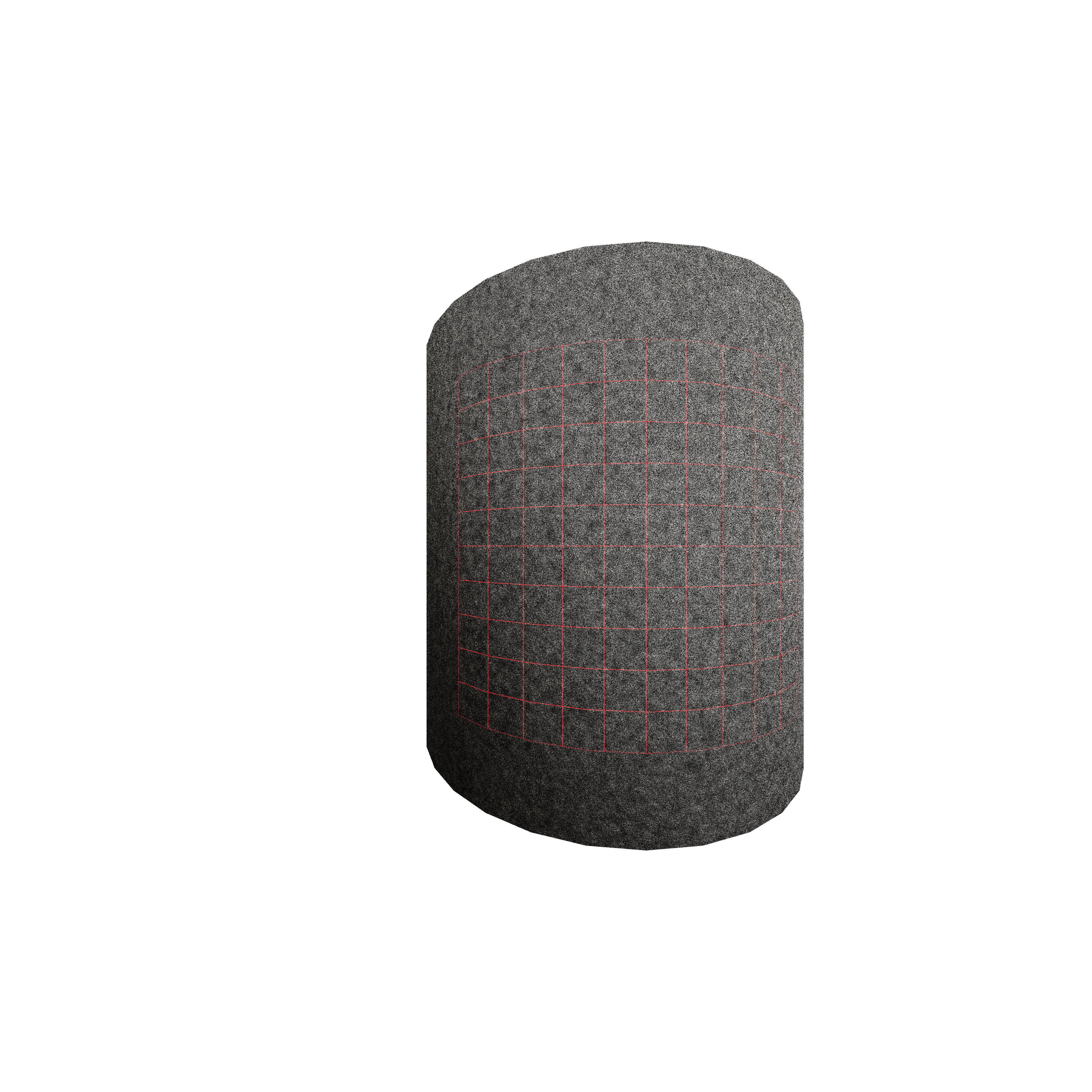

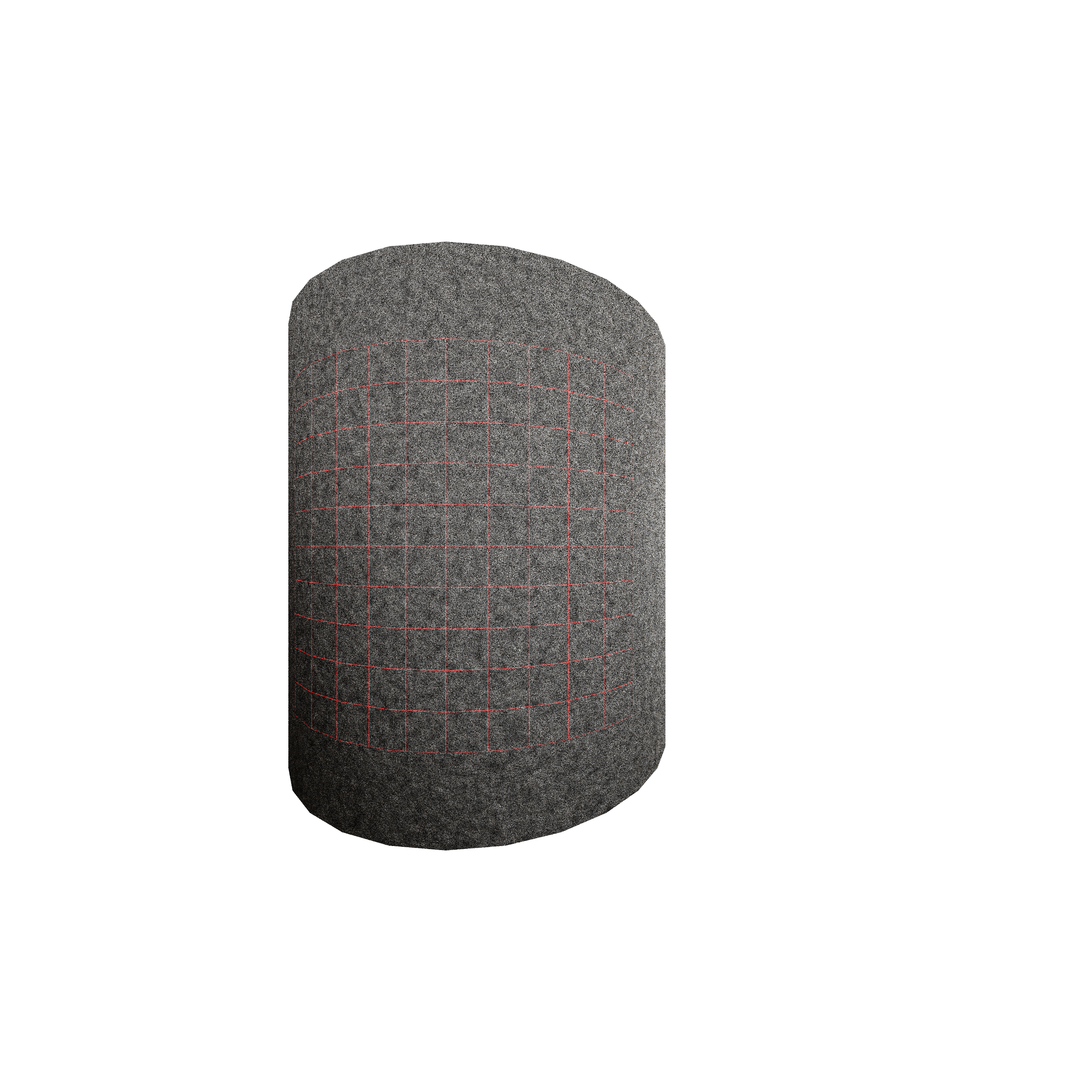

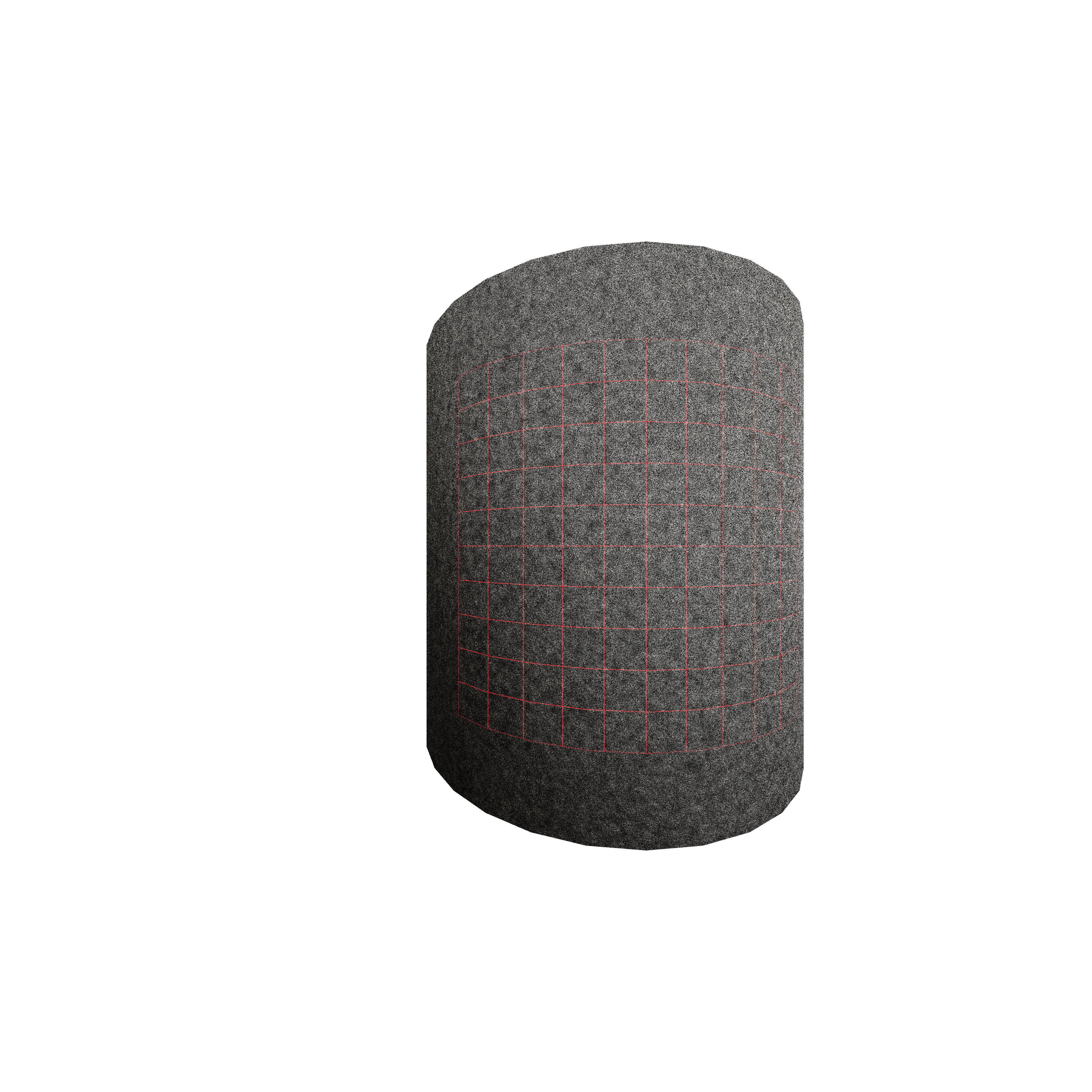

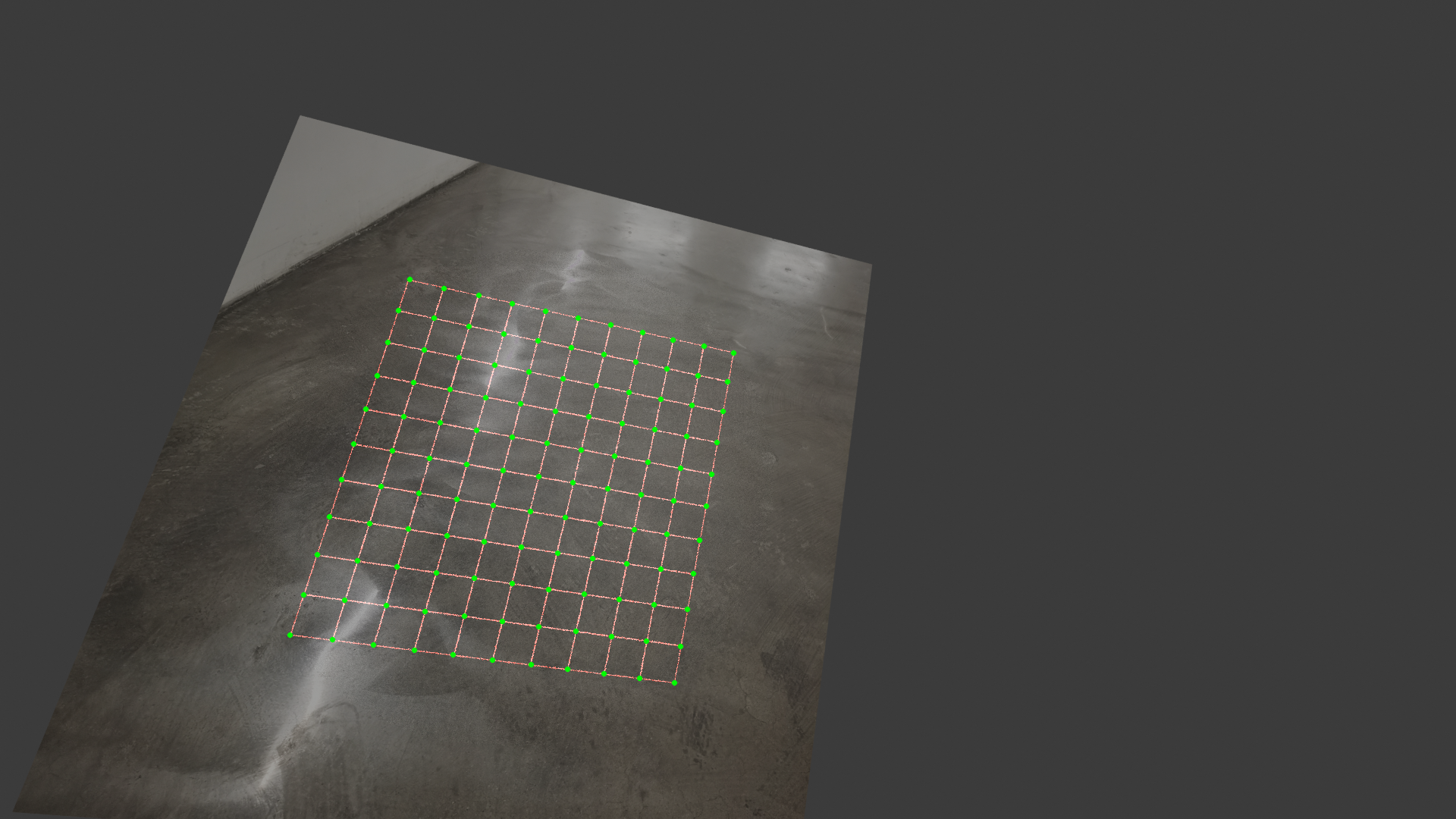

这是我用blender渲染出的两个图片,圆柱侧面是模拟的激光网格,应该用什么样的代码去检测这两张图片才能够正确无误的检测标记出所有的交点,并给出空间的坐标信息呢,最好是用matlab和python解决。

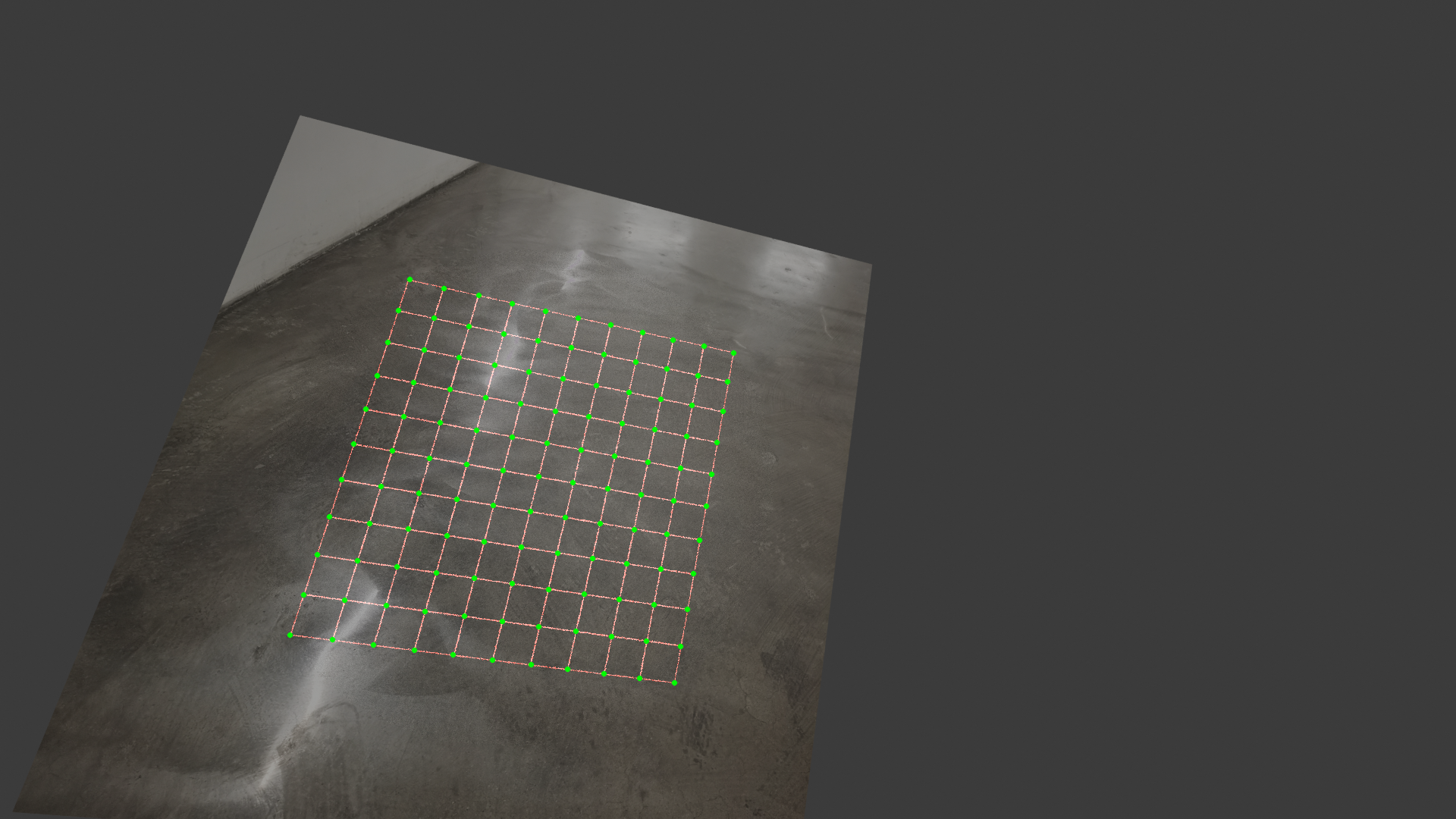

能跟下面这样就好了

这是我用blender渲染出的两个图片,圆柱侧面是模拟的激光网格,应该用什么样的代码去检测这两张图片才能够正确无误的检测标记出所有的交点,并给出空间的坐标信息呢,最好是用matlab和python解决。

阿里嘎多学长整理AIGC生成,因移动端显示问题导致当前答案未能完全显示,请使用PC端查看更加详细的解答过程

问题分析

你需要检测两张图片中的交点,并给出空间的坐标信息。这些图片是由Blender渲染出的,包含激光网格的圆柱侧面。

解决方案

可以使用以下方法来解决这个问题:

核心代码

以下是核心代码的示例:

import cv2

import numpy as np

# 读取图片

img1 = cv2.imread('img1.jpg')

img2 = cv2.imread('img2.jpg')

# 边缘检测

gray1 = cv2.cvtColor(img1, cv2.COLOR_BGR2GRAY)

gray2 = cv2.cvtColor(img2, cv2.COLOR_BGR2GRAY)

edges1 = cv2.Canny(gray1, 50, 150)

edges2 = cv2.Canny(gray2, 50, 150)

# 特征匹配

sift = cv2.SIFT_create()

kp1, des1 = sift.detectAndCompute(edges1, None)

kp2, des2 = sift.detectAndCompute(edges2, None)

bf = cv2.BFMatcher()

matches = bf.knnMatch(des1, des2, k=2)

# 匹配特征点

good_matches = []

for m, n in matches:

if m.distance < 0.7 * n.distance:

good_matches.append(m)

# 计算空间坐标

src_pts = np.float32([kp1[m.queryIdx].pt for m in good_matches]).reshape(-1, 1, 2)

dst_pts = np.float32([kp2[m.trainIdx].pt for m in good_matches]).reshape(-1, 1, 2)

H, _ = cv2.findHomography(src_pts, dst_pts, cv2.RANSAC, 5.0)

注意

上述代码仅供参考,需要根据具体的需求和图片特征进行调整和优化。