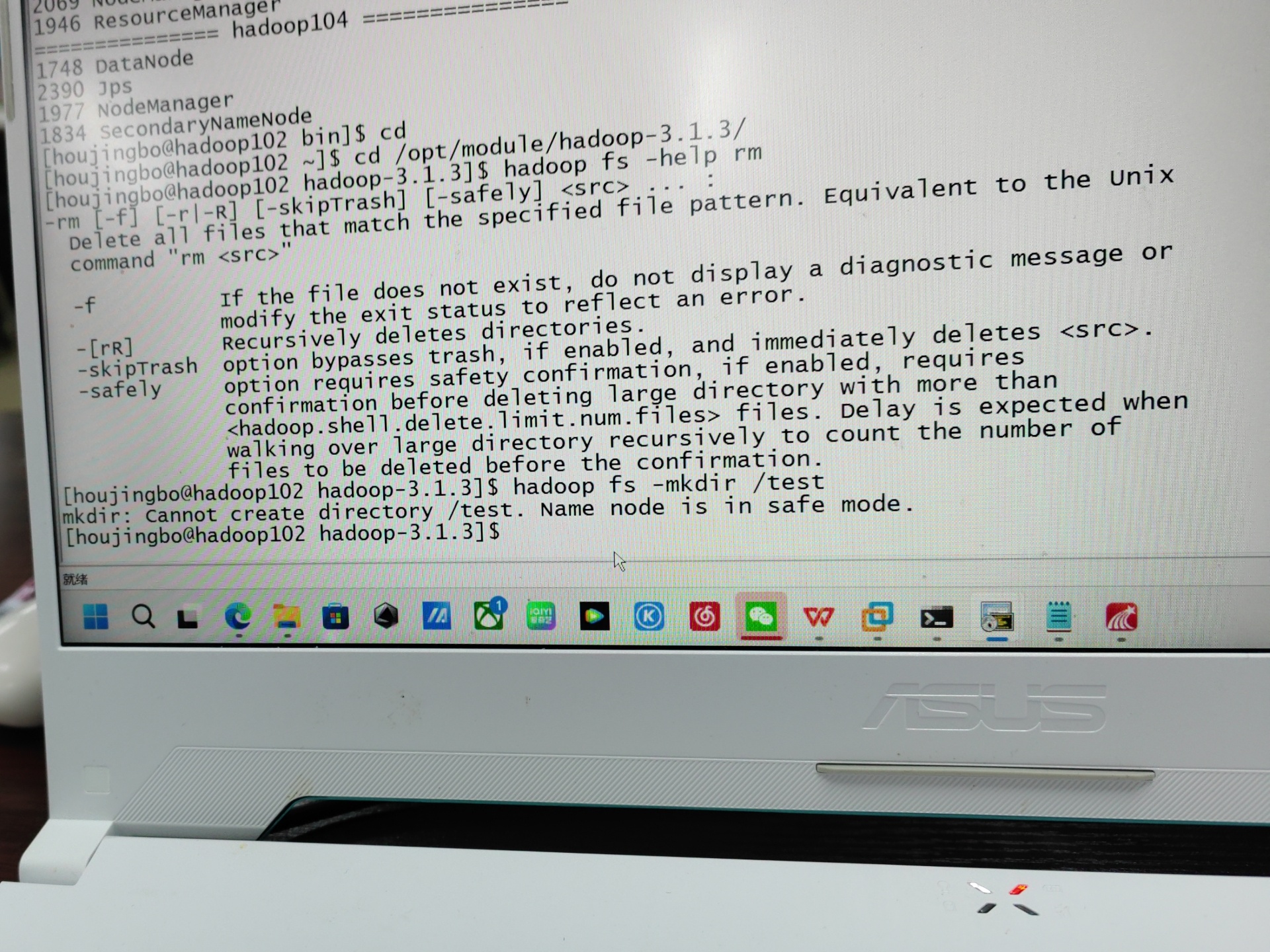

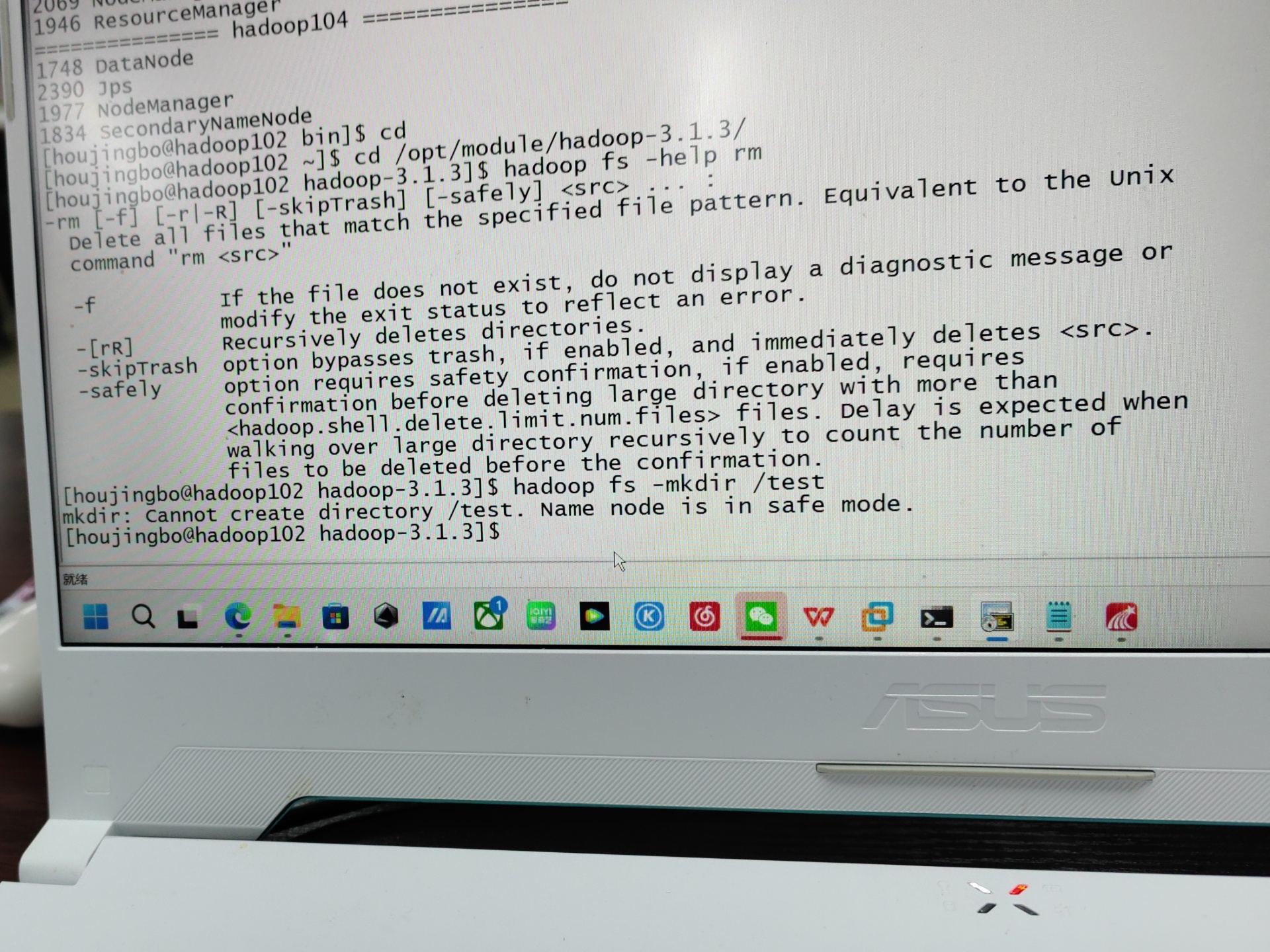

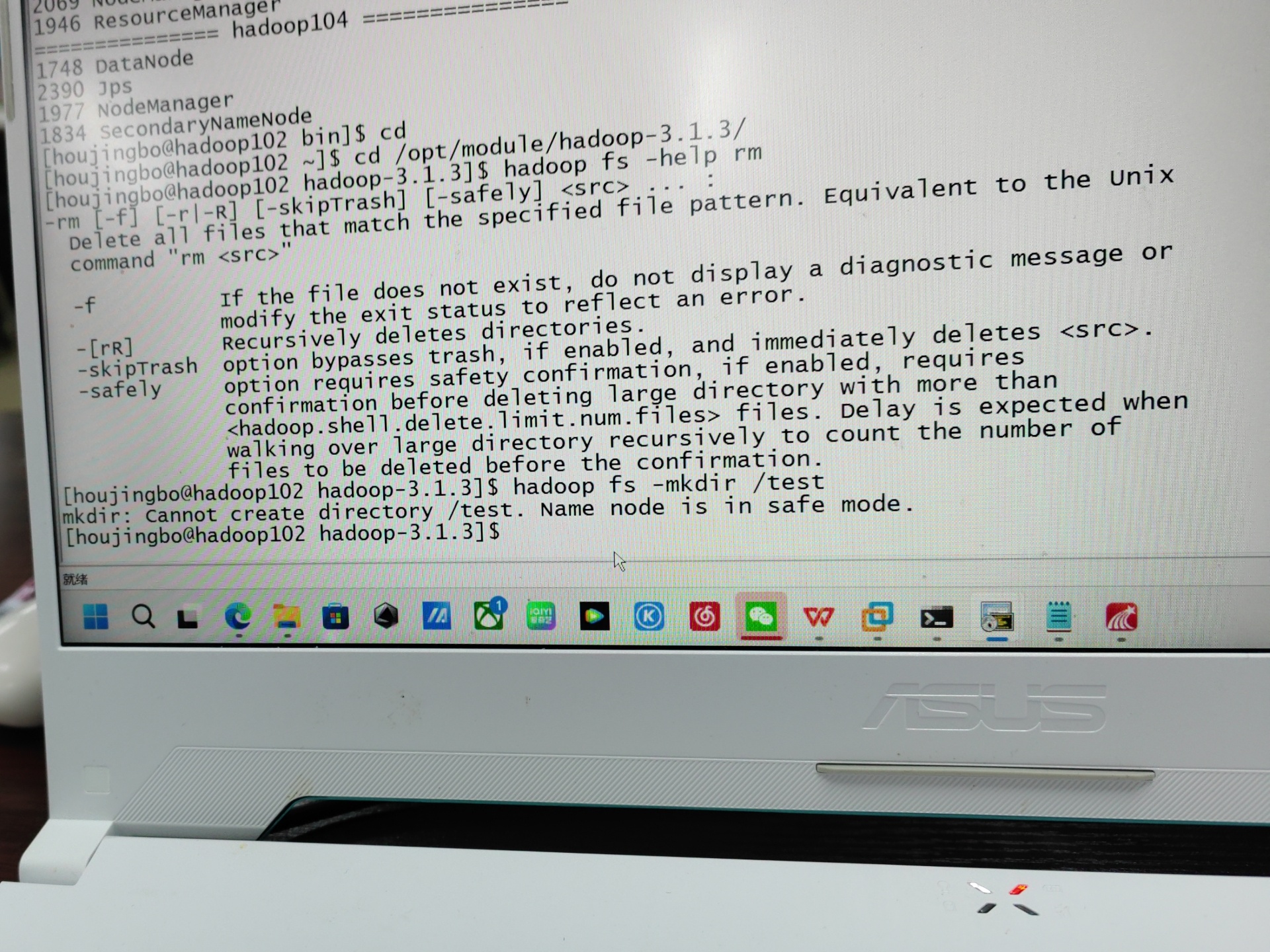

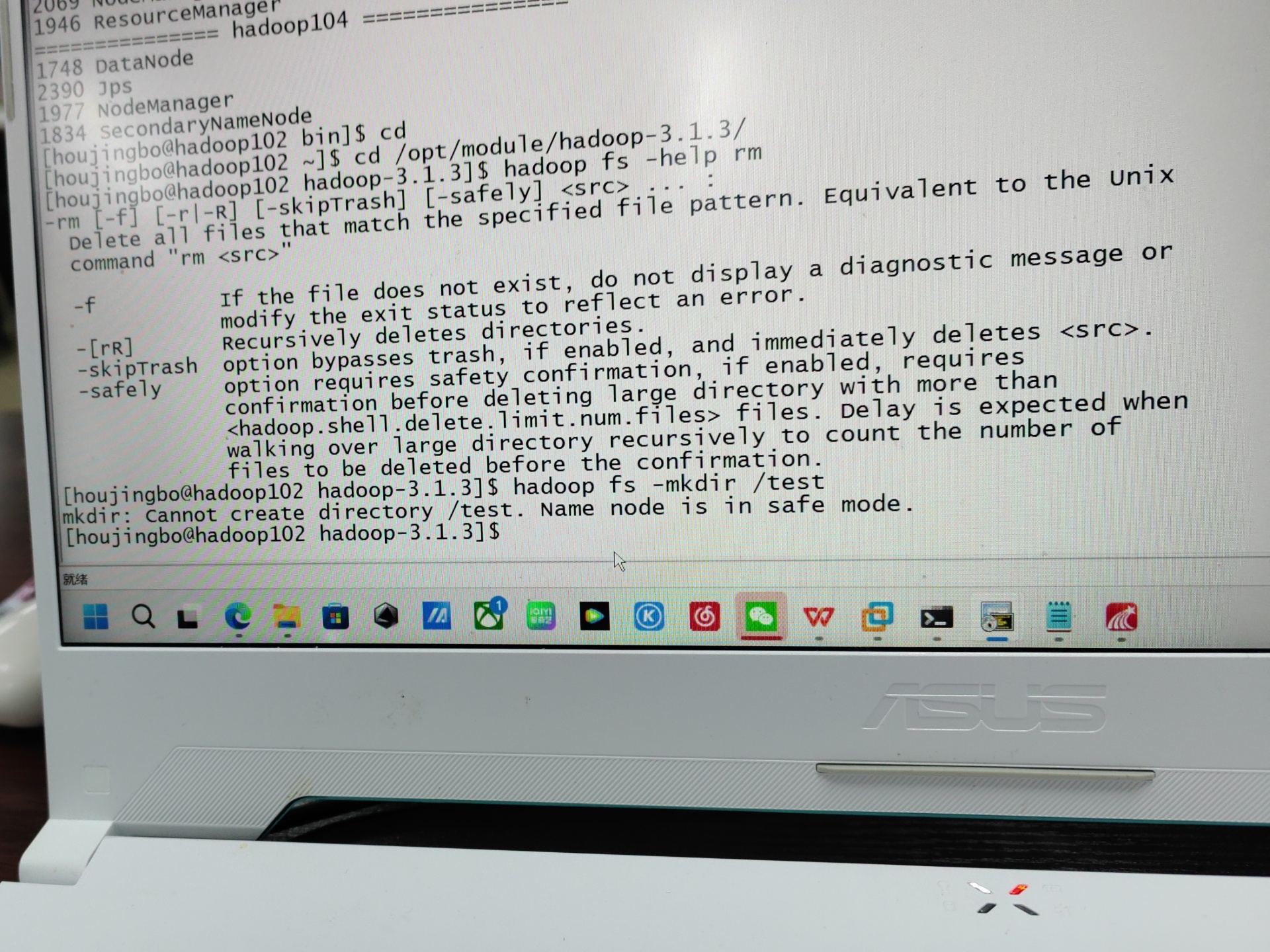

之前文件受损了 快照受损但是被恢复过来了 但是继续往下操作 就显示进入安全模式 怎么也退不出去了 用什么方法能退出安全模式

回答参考qwen

你提到的问题是:Hadoop 进入了安全模式(Safe Mode),并且无法退出。虽然你提到了 VMware 和快照恢复,但核心问题是 Hadoop 的 NameNode 处于安全模式,这与 VMware 本身的安全模式无关 —— 所谓“安全模式”在这里是 Hadoop HDFS 的保护机制,不是虚拟机系统的安全模式。

HDFS 在启动时自动进入安全模式,是为了检查块的复制情况。只有当满足以下条件时才会自动退出:

dfs.replication = 3)但在你的情况下:

“文件受损了,快照受损但是被恢复过来了”

说明可能有大量数据块丢失或未完全恢复,导致 HDFS 认为系统不安全,因此卡在安全模式。

# 查看当前是否处于安全模式

hdfs dfsadmin -safemode get

# 尝试手动关闭安全模式

hdfs dfsadmin -safemode leave

如果返回:

Safe mode is OFF

则成功退出。

⚠️ 如果命令无效或自动重新进入,请继续看下面。

如果你强制 leave 失败或很快又进去了,说明 HDFS 检测到仍有大量块未达标。

查看缺失块的比例

hdfs fsck / -files -blocks -locations | grep "Missing"

查看整体健康状态

hdfs fsck /

输出中关注:

Total blocks(总块数)Missing Blocks(缺失块数)Percent of blocks satisfying the minimal replication requirement只有当这个百分比 ≥ 99.9% 时,HDFS 才允许自动退出。

解决缺失问题

dfs.namenode.name.dir(元数据目录)完整dfs.datanode.data.dir(数据目录)中的所有 DataNode 数据也正常恢复重启 NameNode 和 DataNode

# 停止 HDFS

stop-dfs.sh

# 启动 HDFS

start-dfs.sh

启动后观察日志:

tail -f $HADOOP_LOG_DIR/hadoop-*-namenode-*.log

等待其完成块报告后再尝试:

hdfs dfsadmin -safemode leave

编辑 hdfs-site.xml,添加或修改:

<property>

<name>dfs.namenode.safemode.threshold-pct</name>

<value>0.5</value> <!-- 改为50%,便于退出 -->

</property>

然后重启 NameNode,并执行:

hdfs dfsadmin -safemode leave

🛑 注意:此方法仅建议在数据不重要或已确认大部分可用时使用,生产环境慎用!

⚠️ 使用 VMware 快照恢复 Hadoop 节点存在巨大风险:

✅ 推荐做法:

hdfs dfs -copyFromLocal + 备份元数据(如定期备份 namesecondary 或启用 HA)| 步骤 | 操作 |

|---|---|

| 1 | 运行 hdfs fsck / 检查块完整性 |

| 2 | 确保所有 DataNode 已启动并连接到 NameNode |

| 3 | 等待块报告完成(查看日志) |

| 4 | 执行 hdfs dfsadmin -safemode leave |

| 5 | 若仍失败,检查配置和磁盘数据是否完整 |