现有环境:

win11+docker desktop

已经操作的步骤及问题

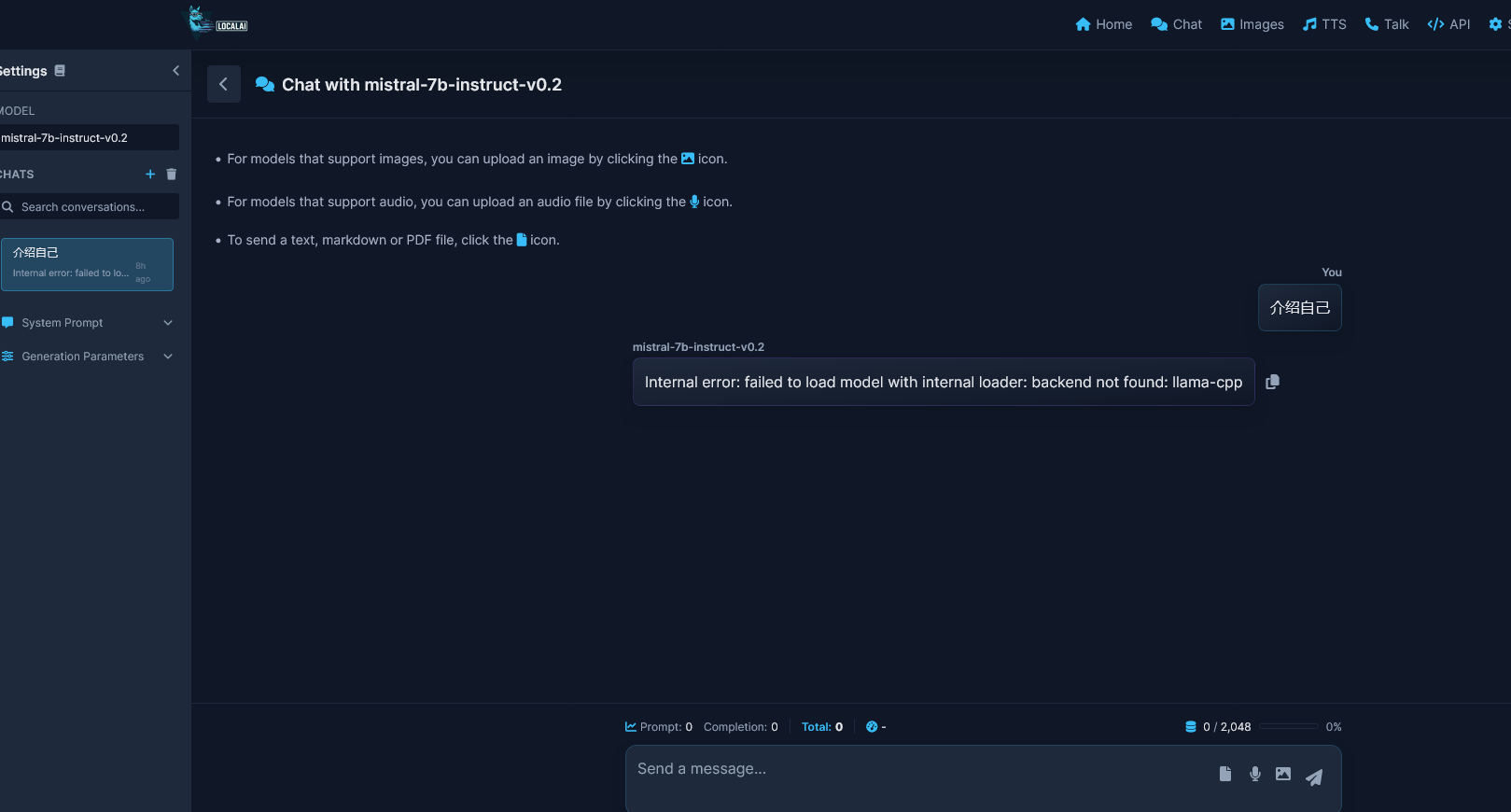

分别用yml文件部署了localai和localaiaio,均只有模型没办法有后端,也尝试手动安装后端,也不行。所以上网找帮手,有偿请人指导安装,让我知道我出的问题在哪里,谢谢。

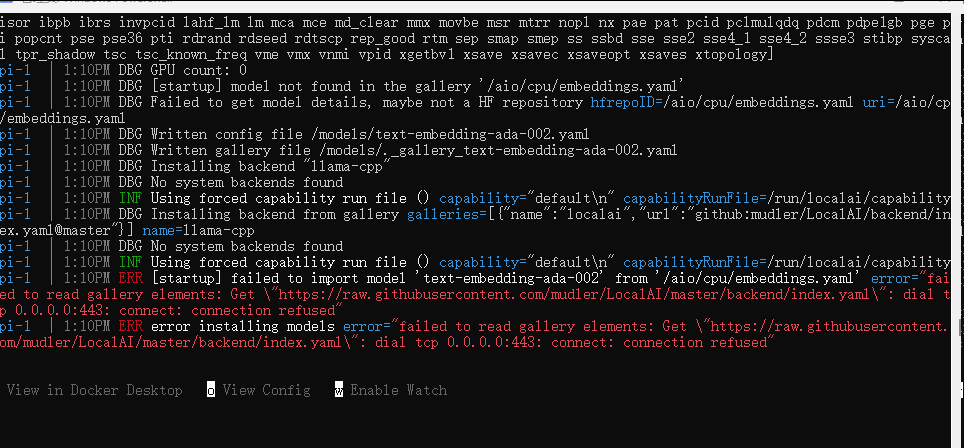

通过看了几次日志,发现:

api-1 | 1:10PM DBG No system backends found

api-1 | 1:10PM INF Using forced capability run file () capability="default\n" capabilityRunFile=/run/localai/capability

api-1 | 1:10PM ERR [startup] failed to import model 'text-embedding-ada-002' from '/aio/cpu/embeddings.yaml' error="failed to read gallery elements: Get \"https://raw.githubusercontent.com/mudler/LocalAI/master/backend/index.yaml\": dial tcp 0.0.0.0:443: connect: connection refused"

api-1 | 1:10PM ERR error installing models error="failed to read gallery elements: Get \"https://raw.githubusercontent.com/mudler/LocalAI/master/backend/index.yaml\": dial tcp 0.0.0.0:443: connect: connection refused"

api-1 | 1:13PM DBG guessDefaultsFromFile: NGPULayers set NGPULayers=99999999

api-1 | 1:13PM DBG Model file loaded: granite-embedding-107m-multilingual-f16.gguf architecture=bert bosTokenID=0 eosTokenID=2 modelName="Granite Embedding 107m Multilingual"

api-1 | 1:13PM DBG No system backends found

api-1 | 1:13PM INF Using forced capability run file () capability="default\n" capabilityRunFile=/run/localai/capability

api-1 | 1:13PM INF Preloading models from //models

api-1 |

api-1 | Model name: text-embedding-ada-002

api-1 |

但我已经kexue上了的,应该不至于不能访问啊。