下午好🌅🌅🌅

本答案参考通义千问

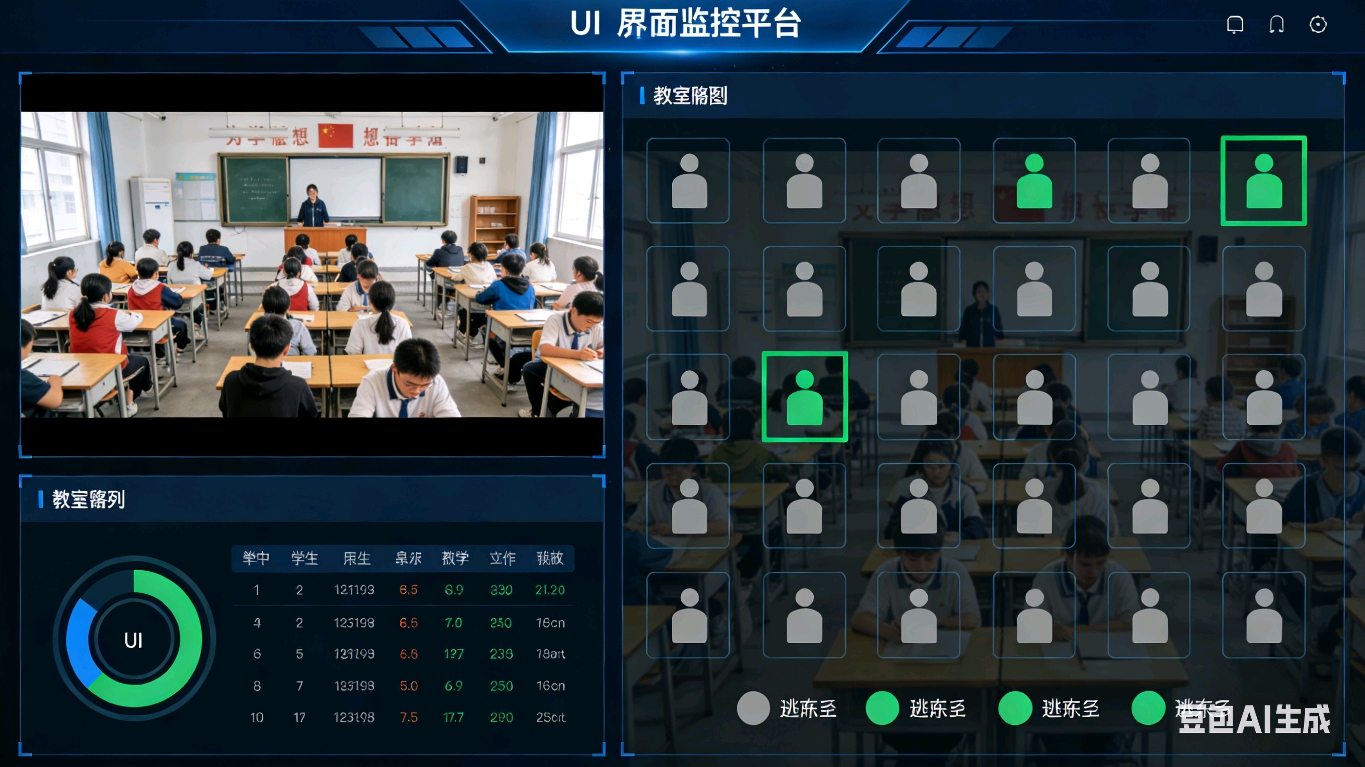

你的项目非常具有现实意义,尤其是在教育和智能教室管理领域。你提到的“座位是否被占用”是核心目标,而如何将二维图像中的检测结果映射到三维空间中的固定座位位置,是实现该目标的关键难点。

✅ 一、问题核心总结

你希望:

- 根据摄像头画面中的人的位置,判断每个固定座位是否有人;

- 前端显示绿色/灰色表示状态;

- 不进行人脸识别或身份追踪,只关注“是否有座位被占用”。

✅ 二、技术思路设计建议

1. ROI 区域定义与映射

重点:建立“座位坐标系”与“图像坐标系”的映射关系。

解决方案:

-

步骤一:标定座位位置

- 在实际场景中,为每个座位定义一个固定的 ROI(Region of Interest)区域。

- 可以通过手动标注或者使用标定板(如棋盘格)来计算相机的内参和外参,从而将3D 空间中的座位坐标转换为 2D 图像坐标。

-

步骤二:图像坐标与座位的映射

- 使用 Homography(单应性)变换 或 投影矩阵 将图像中的矩形区域(ROI)映射到对应的座位。

- 如果摄像头是固定机位,可以预先采集多个帧,计算每个座位在图像中的边界框(bounding box)。

-

步骤三:实时检测与匹配

- 对每一帧图像进行人体检测(如 YOLO、SSD、OpenPose 等),获取人的 bounding box;

- 判断 bounding box 的中心点是否落在某个座位的 ROI 内;

- 如果是,则标记该座位为“占用”;否则为“空闲”。

注意: 这里 不能仅仅依赖 bbox 中心点,因为人可能部分在座位上,但中心点不在 ROI 内,这种情况需要更复杂的判断逻辑(比如面积重叠度)。

2. 座位与人的归属关系

重点:以“座位为中心”维护状态更稳定,适合长期监控。

推荐策略:

-

以“座位为中心”:

- 每个座位有独立的状态(占用/空闲);

- 每次检测后更新所有座位状态;

- 优点:结构清晰,便于状态维护和可视化;

- 缺点:需要频繁检测,对性能有一定要求。

-

以“人为中心”:

- 每个人有一个 ID,记录其所在座位;

- 优点:适合跟踪多个人;

- 缺点:如果遮挡或多人同时出现,容易出错。

建议:优先选择“以座位为中心”的方式,因为你的需求不需要识别具体人,只需要知道哪个座位被占用了。

3. 遮挡处理策略

重点:遮挡是影响准确率的重要因素,需采用鲁棒算法。

常见处理方法:

-

使用多帧信息融合:

- 不仅看当前帧,还要参考前几帧的检测结果,避免因遮挡导致误判。

-

基于时间序列的滤波:

- 如 Kalman Filter 或 Particle Filter,用于预测人是否还在座位上。

-

结合深度信息(如果有):

- 如果使用 RGB-D 相机(如 Intel RealSense),可以利用深度图判断人是否坐在座位上。

-

设定时间阈值:

- 如果一个人连续 N 帧未出现在座位 ROI 内,则认为离开;

- 同理,若连续 N 帧出现在 ROI 内,则认为占用。

4. 工程经验与推荐开源项目

重点:已有成熟方案可借鉴,节省开发时间。

推荐关键词与项目:

-

关键词:

- Person Detection + Object Tracking

- Seat Occupancy Detection

- Fixed Camera Surveillance

- YOLO + OpenCV for Real-time Detection

- Homography Mapping

- Multi-Object Tracking (MOT)

-

开源项目推荐:

✅ 三、代码示例(Python + OpenCV + YOLOv5)

import cv2

import numpy as np

from yolov5 import detect

# 定义座位的 ROI 区域(假设为 6 个座位)

seats_roi = [

[[x1, y1], [x2, y2]], # 座位1的 ROI

[[x1, y1], [x2, y2]], # 座位2的 ROI

...,

]

# 加载 YOLOv5 模型

model = detect.load_model("yolov5s.pt")

def is_in_roi(bbox, roi):

x1, y1, x2, y2 = bbox

rx1, ry1 = roi[0]

rx2, ry2 = roi[1]

return (x1 > rx1 and x2 < rx2 and y1 > ry1 and y2 < ry2)

def update_seat_status(boxes):

seat_occupied = [False] * len(seats_roi)

for box in boxes:

for i, roi in enumerate(seats_roi):

if is_in_roi(box, roi):

seat_occupied[i] = True

break

return seat_occupied

# 主循环

cap = cv2.VideoCapture(0)

while True:

ret, frame = cap.read()

results = model(frame)

boxes = results.xyxy[0].cpu().numpy() # 获取检测结果

occupied = update_seat_status(boxes)

# 显示前端界面(伪代码)

for i, status in enumerate(occupied):

color = "green" if status else "gray"

draw_seat(i, color) # 假设函数用于绘制前端界面

cv2.imshow('Frame', frame)

if cv2.waitKey(1) == 27:

break

✅ 四、总结与建议

| 问题 | 解决方案 |

|------|----------|

| 如何映射座位到图像? | 使用 Homography 或 ROI 标定 |

| 座位与人的归属关系? | 以“座位为中心”更稳定 |

| 遮挡处理? | 多帧融合 + 时间滤波 + 阈值判断 |

| 推荐技术栈? | YOLOv5 + OpenCV + DeepSORT |

| 开源项目? | DeepSORT、YOLOv5、MMDetection |

如果你愿意,我可以进一步帮你设计前端界面、数据存储(如 MySQL、Redis)或实时推送(WebSocket)模块。欢迎继续提问!🌟