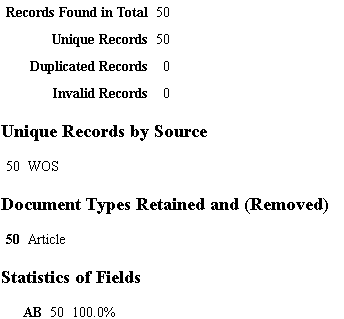

使用wos下载的,不管导进去多少文献,去重后都只显示50,而且没有重复的

中午好🌞🌞🌞

本答案参考通义千问

你提到在使用 CiteSpace 处理 Web of Science (WOS) 数据时,不管导入多少文献,去重后只显示50条,且没有重复项。这可能是由于以下几个原因导致的:

CiteSpace 对导入的数据格式有严格要求,尤其是 WOS 数据需要是 CSV 格式,并且字段名称要与 CiteSpace 要求的字段一致。

AU:作者TI:标题PY:年份SO:来源AB:摘要LA:语言DE:关键词UT:UT 码(唯一标识符)如果这些字段缺失或命名不一致,CiteSpace 可能无法正确解析数据,导致只显示部分文献。

CiteSpace 的去重功能是基于 UT 码(Unique ID) 或 标题+作者+年份 进行判断的。如果你的数据中 UT 码缺失 或 重复项未被识别,可能误判为“无重复”。

某些旧版本的 CiteSpace 对 WOS 数据支持不够完善,建议使用 最新版 CiteSpace(如 CiteSpace 6.1.9 或更高)。

CiteSpace 默认对导入数据量有一定限制(例如,最多支持 1000 条文献),如果你导入了大量文献,可能会被截断。

确保你的 CSV 文件包含以下字段,并且字段名与 CiteSpace 兼容:

| 字段名 | 含义 |

|--------|--------------|

| AU | 作者 |

| TI | 标题 |

| PY | 年份 |

| SO | 来源 |

| AB | 摘要 |

| LA | 语言 |

| DE | 关键词 |

| UT | UT 码(唯一标识符) |

注意: 如果你从 WOS 导出的是 TXT 或 RIS 格式,建议先转换为 CSV 格式。

在 CiteSpace 中:

如果你发现 CiteSpace 去重后只显示 50 条,可能是由于某些文献的 UT 码重复或缺失。你可以通过以下方式解决:

AU, TI, PY, SO, AB, LA, DE, UT

"John Smith", "A New Method", "2020", "Journal of Science", "This paper introduces...", "English", "Method, Research", "WOS:000487654321"

"Jane Doe", "Advanced Analysis", "2021", "Nature", "This study explores...", "English", "Analysis, Data", "WOS:000487654322"

...

注意: 确保每个文献的

UT字段唯一,否则会被 CiteSpace 自动去重。

如果你的 CSV 文件过大或格式混乱,可以使用 Python 脚本进行预处理。

import pandas as pd

# 读取 CSV 文件

df = pd.read_csv("your_data.csv")

# 保留必要字段

required_columns = ['AU', 'TI', 'PY', 'SO', 'AB', 'LA', 'DE', 'UT']

df = df[required_columns]

# 去除重复的 UT 码(根据需求)

df = df.drop_duplicates(subset=['UT'])

# 保存为新的 CSV

df.to_csv("cleaned_data.csv", index=False)

运行此代码后,将生成一个格式规范、去重后的 CSV 文件,再导入 CiteSpace 即可解决问题。

| 问题点 | 解决方案 |

|--------|----------|

| 数据格式错误 | 确保字段名称与 CiteSpace 兼容,尤其是 UT 字段 |

| 去重逻辑问题 | 使用 UT 作为唯一标识符,确保其唯一性 |

| CiteSpace 版本问题 | 升级到最新版本(如 CiteSpace 6.1.9) |

| 数据量限制 | 调整 Maximum number of documents to import 设置 |

| 数据预处理 | 使用 Python 脚本清理和规范数据 |

UT 字段唯一,这是 CiteSpace 去重的核心依据。如需进一步帮助,请提供你使用的 CiteSpace 版本 和 CSV 文件片段,我可以帮你更具体地分析问题。