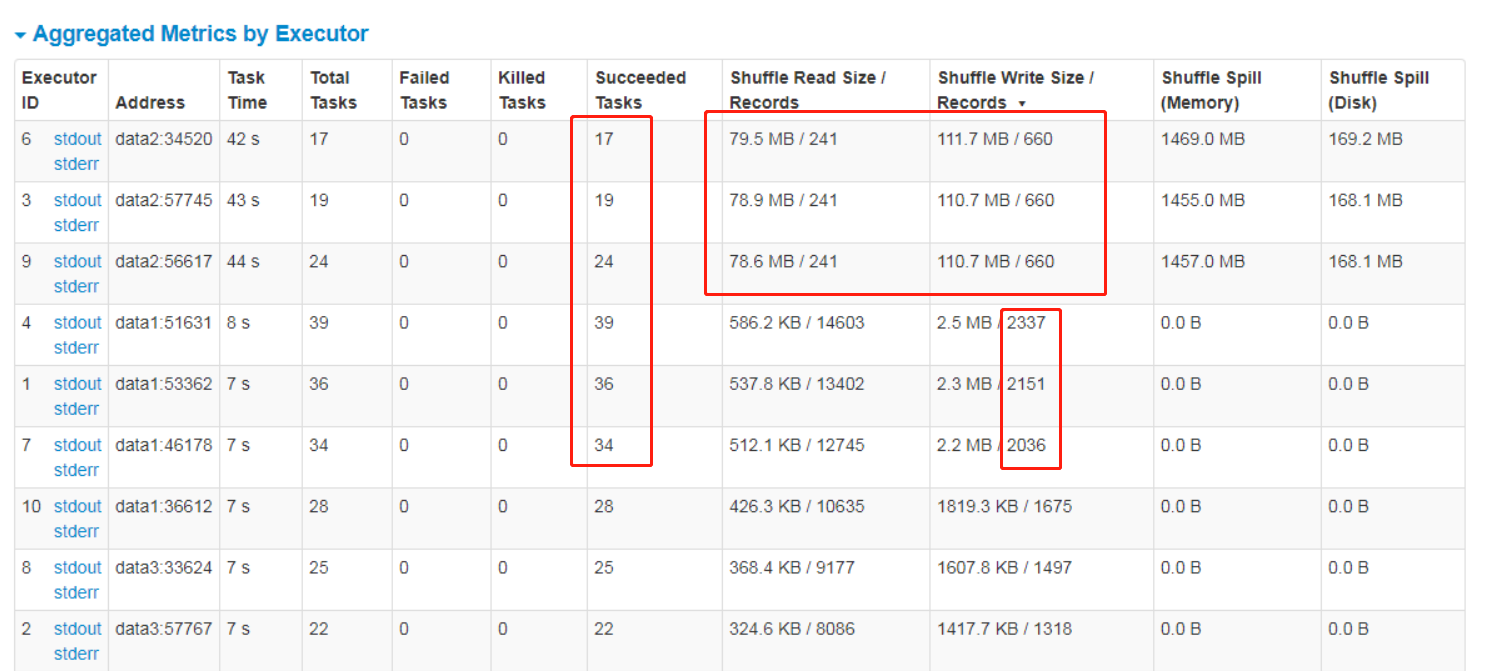

是这样的,我跑spark任务,我发现总是卡在最后3个task上面,然后一看发现都在data2上面,为啥这3个executor的tasks的数量比其他要少,而且记录数少。

spark的一个疑问,请大神解答。

- 写回答

- 好问题 0 提建议

- 关注问题

- 邀请回答

-

2条回答 默认 最新

关注

关注让阿豪来帮你解答,本回答参考chatgpt3.5编写提供,如果还有疑问可以评论或留言

问题分析:- 可能是由于数据倾斜导致部分executor上的task数量较少,而且记录数也较少。

- 可能是数据分区不均匀导致某些executor上的task数量较少。 解决方案:

- 检查数据分布情况,看是否存在数据倾斜。可以通过查看数据2的分布情况,可能需要重新进行数据分区。

- 调整任务调度策略,比如尝试使用动态分配资源策略,平衡executor上的task数量。 案例: 假设数据2是一个DataFrame,使用Spark进行处理时,可以通过以下代码查看数据分布情况:

val data2 = spark.read.format("csv").load("path_to_data2") data2.groupBy("column_name").count().show()如果发现数据倾斜或数据分区不均匀,可以调整数据分区方式或调度策略。

解决 无用评论 打赏 举报