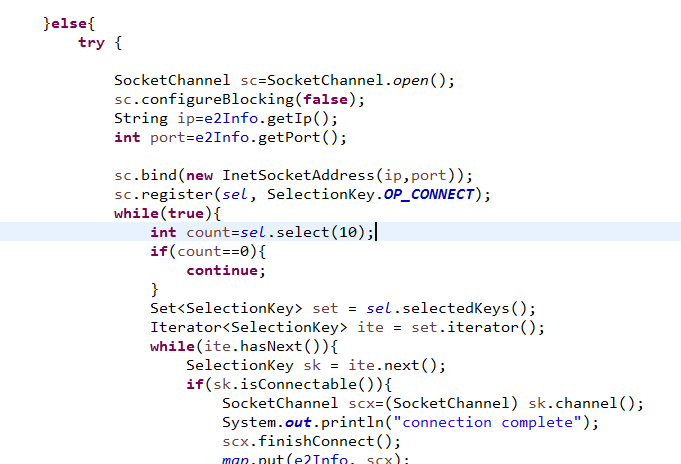

上面的图片是我截取的一部分代码, 是放在while死循环里面的一段..

因为执行起来很快,不知道循环到多少次的时候开始,每次执行到bind那里的时候,都会出现

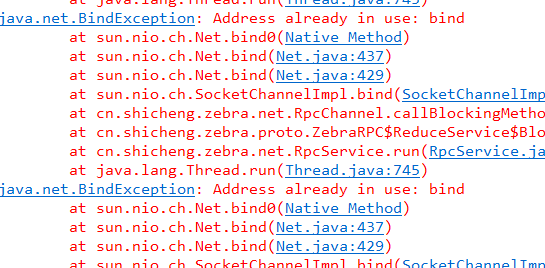

如下的异常:

上网搜索了下,那个异常主要是因为端口已经被其他线程所绑定,但是, 我这里使用的是socketchannel,是作为客户端,又不是服务器,也就是说绑定的是一个远程的地址(这里使用的是本机回传地址),那么问题来了,难道一个服务器端口只能被一个客户端绑定?咋那么回事?

上面的图片是我截取的一部分代码, 是放在while死循环里面的一段..

因为执行起来很快,不知道循环到多少次的时候开始,每次执行到bind那里的时候,都会出现

如下的异常:

上网搜索了下,那个异常主要是因为端口已经被其他线程所绑定,但是, 我这里使用的是socketchannel,是作为客户端,又不是服务器,也就是说绑定的是一个远程的地址(这里使用的是本机回传地址),那么问题来了,难道一个服务器端口只能被一个客户端绑定?咋那么回事?