1条回答 默认 最新

lyhsdy 2018-12-06 01:33关注

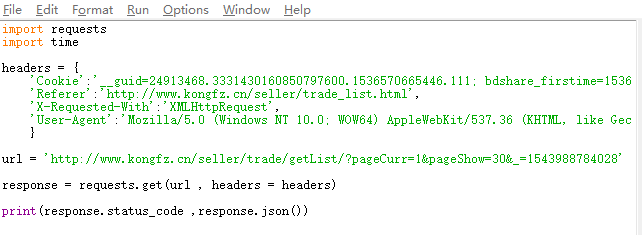

lyhsdy 2018-12-06 01:33关注因为网站做了反爬,直接输入你的URL在浏览器就是空值

www.kongfz.cn/seller/trade/getlist/?pgeCurr=1&pageShow=30&_=1543988784028

可以尝试使用下requests.session()来传递cookie解决 无用评论 打赏 举报

悬赏问题

- ¥15 matlab(相关搜索:紧聚焦)

- ¥15 基于51单片机的厨房煤气泄露检测报警系统设计

- ¥15 路易威登官网 里边的参数逆向

- ¥15 Arduino无法同时连接多个hx711模块,如何解决?

- ¥50 需求一个up主付费课程

- ¥20 模型在y分布之外的数据上预测能力不好如何解决

- ¥15 processing提取音乐节奏

- ¥15 gg加速器加速游戏时,提示不是x86架构

- ¥15 python按要求编写程序

- ¥15 Python输入字符串转化为列表排序具体见图,严格按照输入