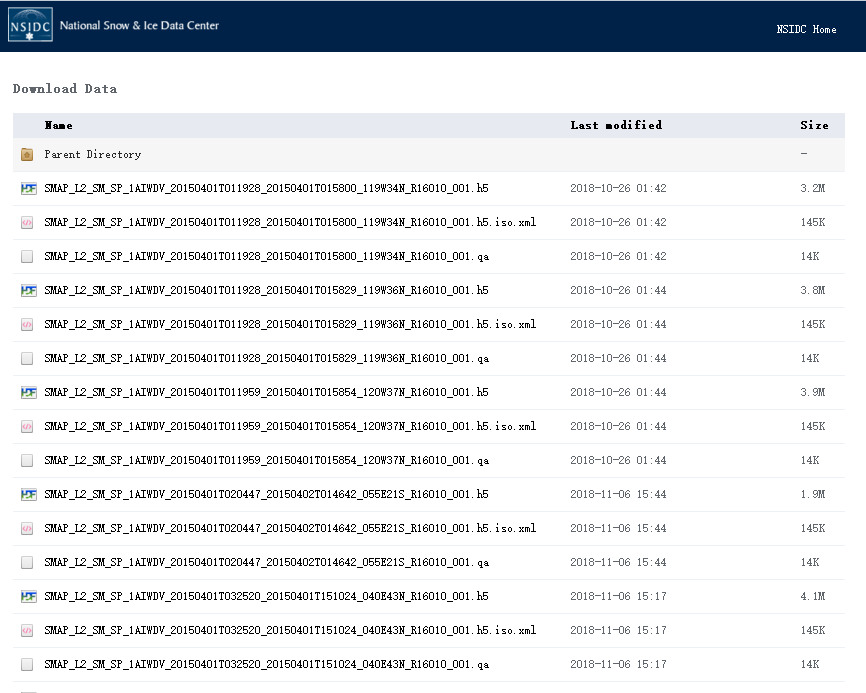

如图,我要批量下载这个网页目录下的所有文件。用了下面这段代码:

如图,我要批量下载这个网页目录下的所有文件。用了下面这段代码:

wget -r -nH --cut-dirs 2 --restrict-file-names=nocontrol -P F:\data --http-user=XXXX --http-passwd=XXXX https://n5eil01u.ecs.nsidc.org/SMAP/SPL2SMAP_S.002/2015.03.31/

(由于隐私,用户名和密码我用XXXX代替)

执行代码后过程如下:

--2018-12-06 23:39:12-- https://urs.earthdata.nasa.gov/oauth/authorize?app_type=401&client_id=_JLuwMHxb2xX6NwYTb4dRA&response_type=code&redirect_uri=https%3A%2F%2Fn5eil01u.ecs.nsidc.org%2FOPS%2Fredirect&state=aHR0cDovL241ZWlsMDF1LmVjcy5uc2lkYy5vcmcvU01BUC9TUEwyU01BUF9TLjAwMi8yMDE1LjAzLjMxLw

Resolving urs.earthdata.nasa.gov (urs.earthdata.nasa.gov)... 2001:4d0:241a:4081::89, 198.118.243.33

Connecting to urs.earthdata.nasa.gov (urs.earthdata.nasa.gov)|2001:4d0:241a:4081::89|:443... connected.

HTTP request sent, awaiting response... 401 Unauthorized

Authentication selected: Basic realm="Please enter your Earthdata Login credentials. If you do not have a Earthdata Login, create one at https://urs.earthdata.nasa.gov//users/new"

Reusing existing connection to [urs.earthdata.nasa.gov]:443.

HTTP request sent, awaiting response... 302 Found

Location: https://n5eil01u.ecs.nsidc.org/OPS/redirect?code=b01004c779d377e755a8baf424ff2a756a0d61469640e0175dd9a42b92100c71&state=aHR0cDovL241ZWlsMDF1LmVjcy5uc2lkYy5vcmcvU01BUC9TUEwyU01BUF9TLjAwMi8yMDE1LjAzLjMxLw [following]

--2018-12-06 23:39:14-- https://n5eil01u.ecs.nsidc.org/OPS/redirect?code=b01004c779d377e755a8baf424ff2a756a0d61469640e0175dd9a42b92100c71&state=aHR0cDovL241ZWlsMDF1LmVjcy5uc2lkYy5vcmcvU01BUC9TUEwyU01BUF9TLjAwMi8yMDE1LjAzLjMxLw

Connecting to n5eil01u.ecs.nsidc.org (n5eil01u.ecs.nsidc.org)|128.138.97.102|:443... connected.

HTTP request sent, awaiting response... 302 Found

Location: https://n5eil01u.ecs.nsidc.org/SMAP/SPL2SMAP_S.002/2015.03.31/ [following]

--2018-12-06 23:39:16-- https://n5eil01u.ecs.nsidc.org/SMAP/SPL2SMAP_S.002/2015.03.31/

Connecting to n5eil01u.ecs.nsidc.org (n5eil01u.ecs.nsidc.org)|128.138.97.102|:443... connected.

HTTP request sent, awaiting response... 200 OK

Length: unspecified [text/html]

Saving to: 'F:/data/2015.03.31/index.html'

2015.03.31/index.html [ <=> ] 29.25K 49.5KB/s in 0.6s

2018-12-06 23:39:17 (49.5 KB/s) - 'F:/data/2015.03.31/index.html' saved [29950]

FINISHED --2018-12-06 23:39:17--

Total wall clock time: 6.4s

Downloaded: 1 files, 29K in 0.6s (49.5 KB/s)

最终仅仅只是下了个Index文件。

我想问一下这里面是哪里出错了?