1条回答 默认 最新

你知我知皆知 2024-08-07 15:17关注

你知我知皆知 2024-08-07 15:17关注以下回答参考 皆我百晓生、券券喵儿 等免费微信小程序相关内容作答,并由本人整理回复。

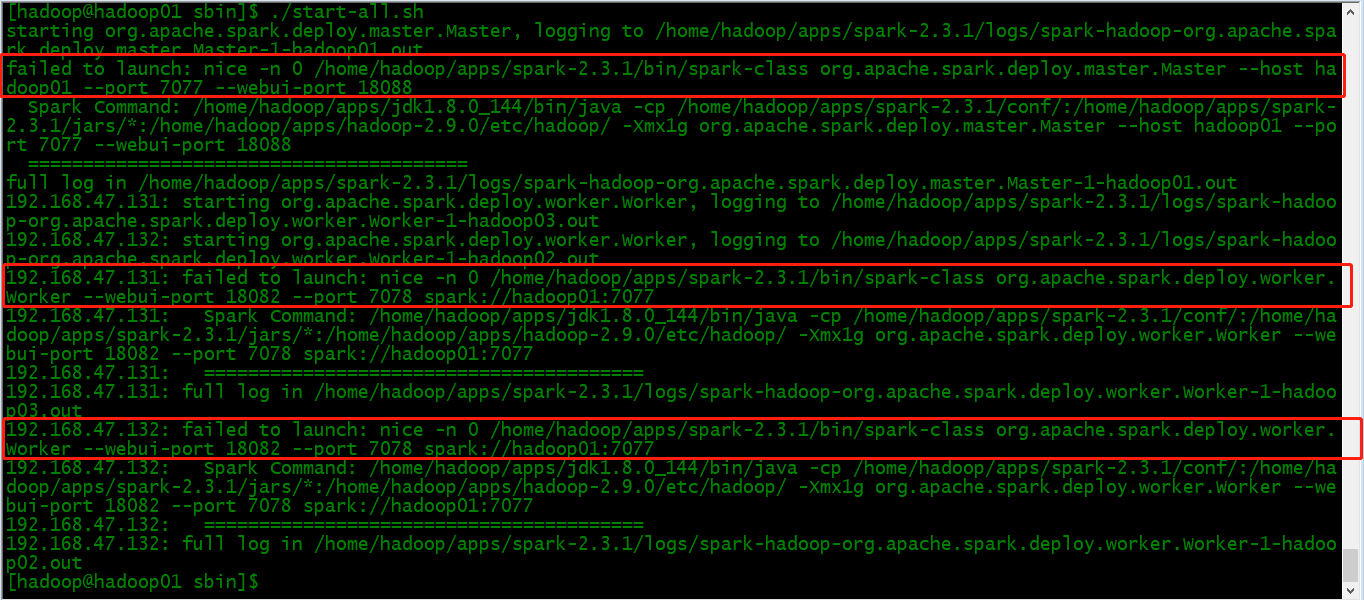

从您提供的日志来看,似乎Spark在尝试启动时遇到了一些问题。这可能是因为Spark环境配置错误、硬件资源不足或者是Spark版本不兼容等原因导致的。

以下是一些建议和步骤来解决这个问题:

步骤 1: 检查Spark环境配置

确保您的Spark环境配置正确且最新。如果您使用的是Hadoop集群,可以检查以下几点:

- 确保Hadoop版本与Spark版本兼容。

- 检查HDFS路径设置是否正确(例如:如果使用了Zookeeper作为分布式文件系统)。

- 确保JDK版本与Spark版本兼容。

- 确保所有依赖库都已正确安装并添加到类路径中。

步骤 2: 检查硬件资源

- 确保Hadoop集群有足够的可用内存和CPU资源。

- 如果是虚拟机环境,请确认虚拟机的硬件配置满足Spark运行的需求。

步骤 3: 检查Spark版本

- 确认使用的Spark版本是您期望的版本,并且已经更新到了最新状态。

- 如果您正在使用Apache Spark,确保其依赖包已更新到最新版本。

步骤 4: 检查Spark服务端口

- 确保Spark服务端口没有被其他程序占用。

- 如果Spark服务是通过网络访问的,确保网络连接正常并且防火墙允许访问这些端口。

步骤 5: 检查Spark主进程

- 检查Spark主进程的日志是否有任何错误消息或警告。

- 在控制台输出Spark的详细日志以获取更多关于失败原因的信息。

步骤 6: 重启Spark服务

- 使用

./start-slave.sh命令重新启动Spark服务。 - 如果问题仍然存在,您可以考虑使用Spark的诊断工具进行更深入的调试。

步骤 7: 查看Spark堆栈跟踪

- 打开终端,输入

jstack或者jmap命令查看Spark的堆栈跟踪。 - 这将帮助您了解Spark在启动过程中遇到的具体错误。

希望以上建议能帮到您解决问题!如果问题仍未得到解决,请提供更多的日志细节以便进一步分析。

解决 无用评论 打赏 举报