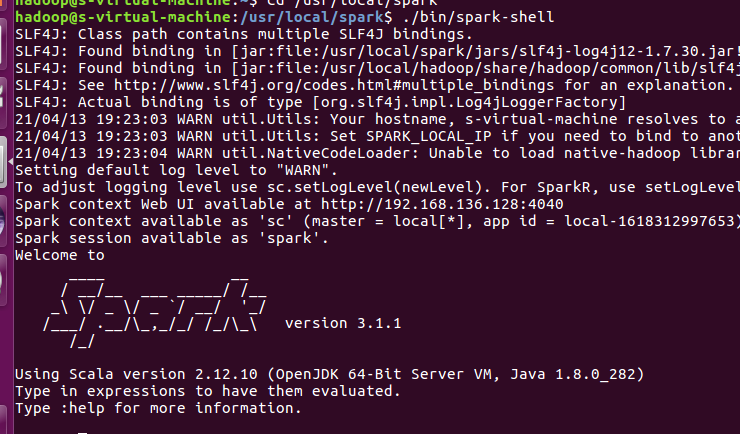

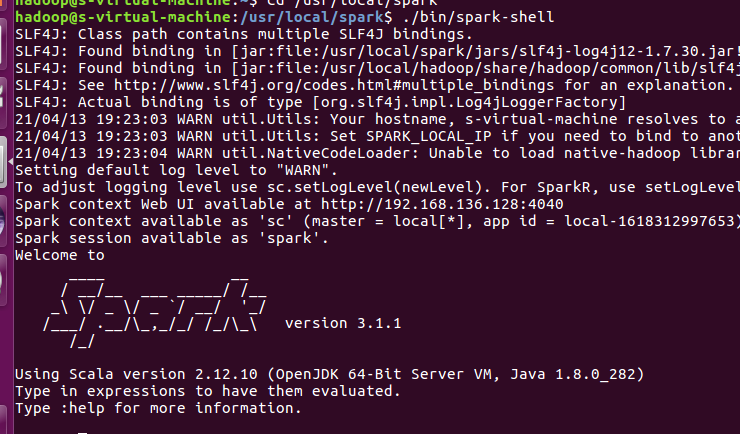

为什么spark执行spark-shell就可以启动成功,

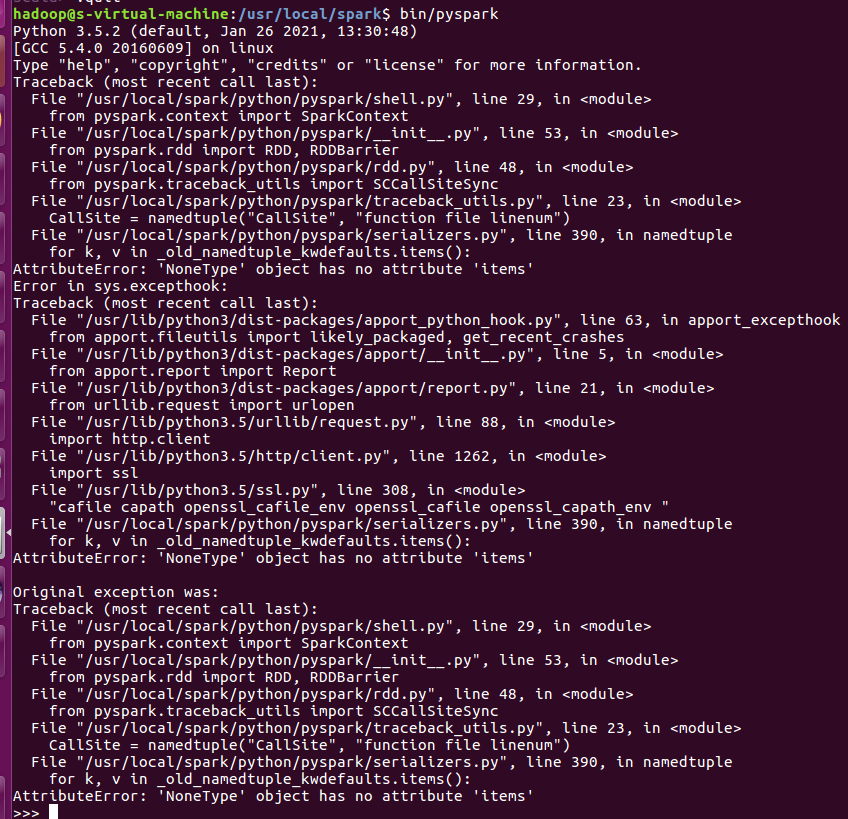

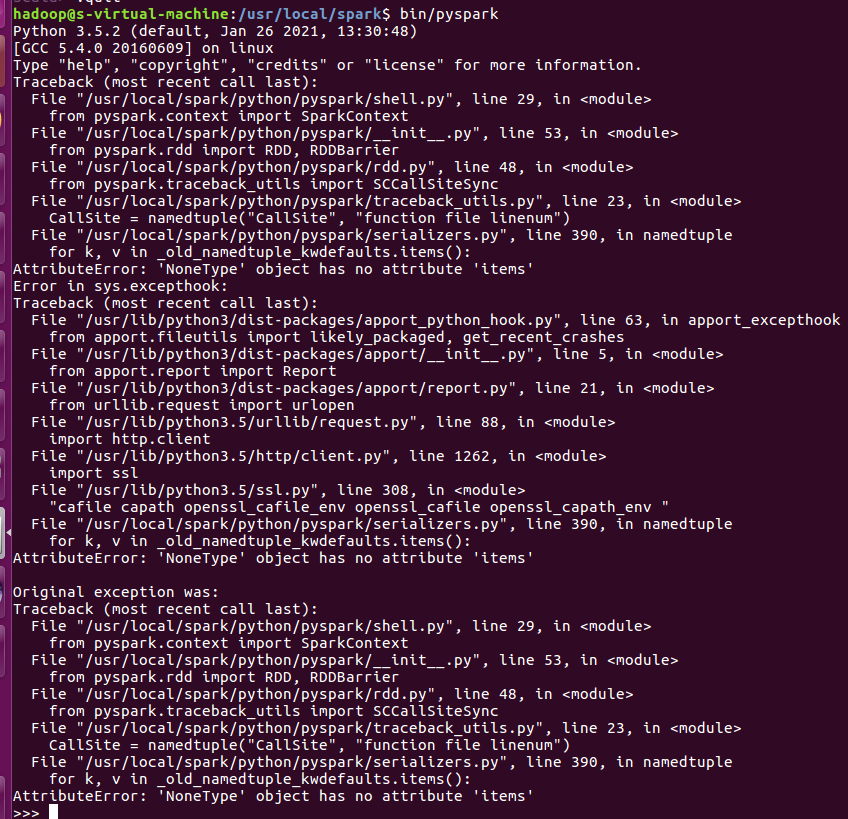

执行pyspark就会出现这个问题?

有小伙伴知道吗?

我是按教程python版本安装的啊

有没有大佬告诉我这个菜鸟啊[face]monkey2:019.png[/face]

关注

关注让阿豪来帮你解答,本回答参考chatgpt3.5编写提供,如果还有疑问可以评论或留言问题表述比较模糊,但从截图中可以看到pyspark执行出现问题的原因是找不到pyspark的可执行文件。这通常是由于环境变量配置不正确导致的。下面我将分两部分进行解答:

spark-shell时会去寻找Scala的可执行文件,并成功启动。pyspark时需要找到Python的可执行文件。如果环境变量中没有正确配置Python路径,则会出现无法找到Python可执行文件的问题。python --version 或 python3 --version,确保Python已成功安装并且可被识别。echo $PATH,查看当前环境变量中是否包含Python的路径。~/.bashrc 或 ~/.bash_profile 文件,在文件末尾添加 export PATH=/path/to/python/bin:$PATH(其中/path/to/python是你Python的安装路径)。source ~/.bashrc 或 source ~/.bash_profile 让修改生效,然后再尝试执行pyspark。 在确认Python已正确安装且添加到环境变量后,应该可以成功执行pyspark启动PySpark。 如果以上步骤无法解决问题,可以尝试重新安装PySpark或查看官方文档获得更多帮助。 希望以上解答能帮助你解决问题。如果仍有疑问,欢迎继续提问。