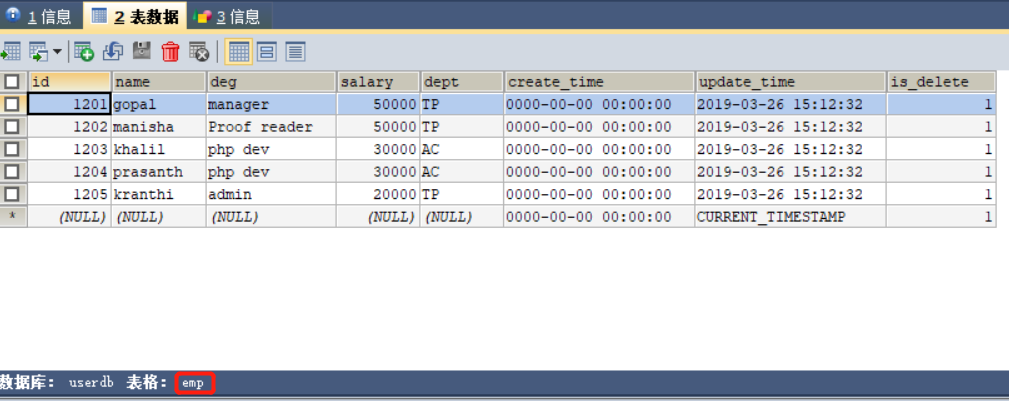

mysql中的原始数据如下:

通过如下命令将此表格导入到hive中

bin/sqoop import --connect jdbc:mysql://192.168.12.69:3306/userdb --username root --password 123 --table emp --fields-terminated-by '\001' --hive-import --hive-table sqooptohive.emp_hive --hive-overwrite --delete-target-dir --m 1

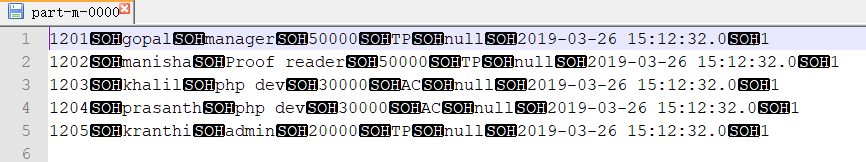

导入成功后,从hdfs系统中下载下来对应的文件内容为:

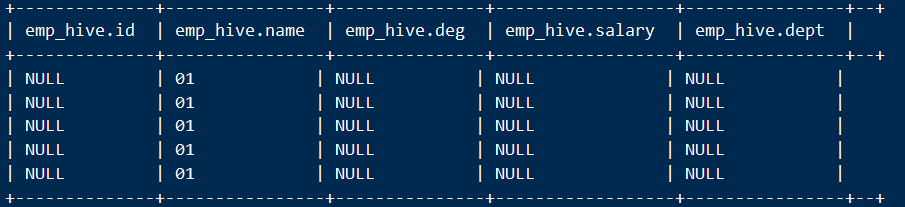

在hive中使用查询语句:

select * from emp_hive;

字段的字权威null了,结果如下: