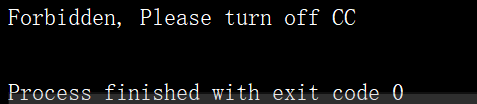

初学爬虫,想要登陆一个网站,可是总是出现这个情况,啊啊啊,弄了好久了,感jio要爆炸了,求救求救

代码如下

import requests

data = {'pwuser':'**', 'pwpwd':'**'}

r = requests.post("http://www.sulanfund.com/bbs/login.php?", data=data)

print(r.text)

不知道怎么回事,去百度也找不到,求救~~~~~

初学爬虫,想要登陆一个网站,可是总是出现这个情况,啊啊啊,弄了好久了,感jio要爆炸了,求救求救

代码如下

import requests

data = {'pwuser':'**', 'pwpwd':'**'}

r = requests.post("http://www.sulanfund.com/bbs/login.php?", data=data)

print(r.text)

不知道怎么回事,去百度也找不到,求救~~~~~

对照浏览器的抓包结果看下,特别注意user-agent、cookie是否正确。如果浏览器也不行了,那么就是服务器有反爬的限制。