python3.7 通过pip 安装requests 报错,百度上也查过很多方法

1、通过更改源

2、通过wheel安装

3、pip --timout=60000等方式都不能解决

公司每台电脑上都装了赛门铁克(Symantec),会不会与这个有影响。

求详细解决方式

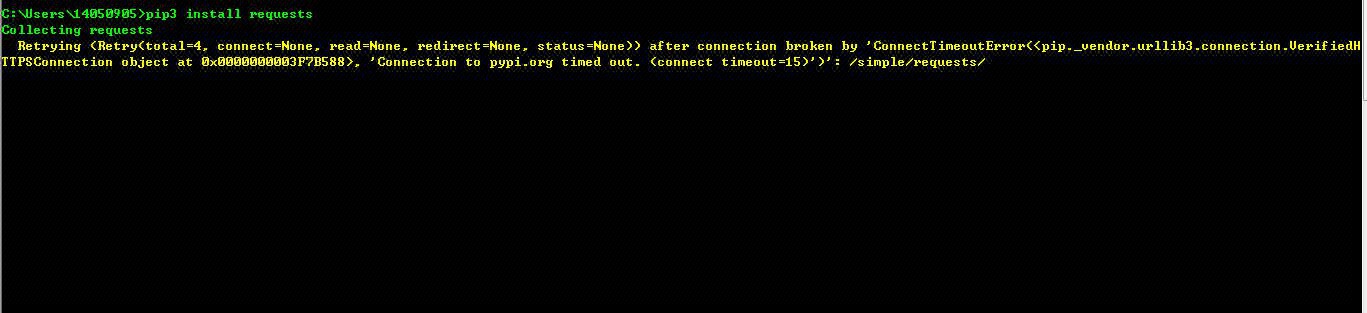

报错如下:

Retrying (Retry(total=4, connect=None, read=None, redirect=None, status=None)) after connection broken by 'ConnectTimeoutError(, 'Connection to pypi.org timed out. (connect timeout=15)')': /simple/requests/