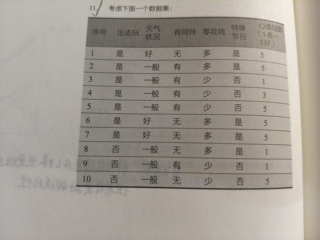

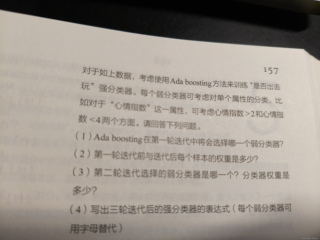

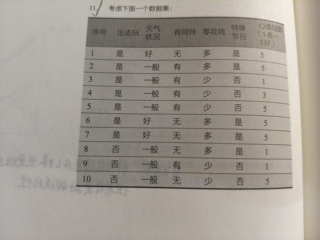

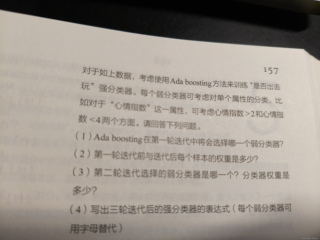

人工智能导论习题求解,非常感谢!机器学习相关部分,习题求解。Ada boosting的相关,求解求解,考虑下面一个数据集。第一次迭代将会选择哪个弱分类器,迭代前和迭代后每个样本的权重是多少

人工智能导论习题求解,非常感谢!机器学习相关部分,习题求解。Ada boosting的相关,求解求解,考虑下面一个数据集。第一次迭代将会选择哪个弱分类器,迭代前和迭代后每个样本的权重是多少

关注

关注引自免费微信小程序:皆我百晓生

好的,首先让我们了解一下 Ada Boost 算法的基本原理。

AdaBoost 是一种集成学习方法,它通过反复迭代逐步提升弱分类器的性能。在每一次迭代中,AdaBoost 使用以前迭代的结果作为新的分类器的训练样本,然后用这些新的训练样本来更新弱分类器。这样可以避免每次迭代都从头开始训练一个新的分类器,从而提高了整个算法的效率。

以下是如何使用 Ada Boost 进行决策树分类的步骤:

以下是一个简单的 Python 示例,展示如何使用 Ada Boost 进行决策树分类:

import numpy as np

from sklearn.datasets import load_iris

from sklearn.tree import DecisionTreeClassifier

# 加载数据集

iris = load_iris()

X = iris.data

y = iris.target

# 创建决策树分类器

clf = DecisionTreeClassifier(random_state=42)

# 训练决策树分类器

clf.fit(X, y)

# 应用决策树分类器

test_data = np.array([[1, 2, 1], [0, 2, 0]])

predicted = clf.predict(test_data)

print(predicted)

在这个例子中,我们首先加载了鸢尾花数据集,然后创建了一个决策树分类器。接着,我们使用数据集训练了这个分类器,并在测试数据上应用了这个分类器。最后,我们打印出了预测结果。

注意,这只是一个基本的例子,实际的 Ada Boost 算法可能会更复杂,需要更多的参数和计算资源。此外,我们也可能需要使用其他的工具和技术来处理数据,例如采样、降维等。