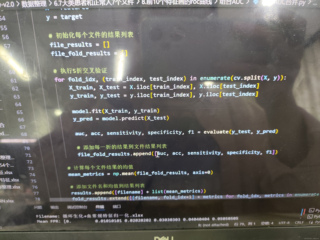

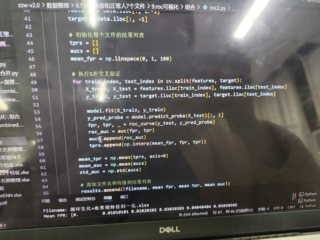

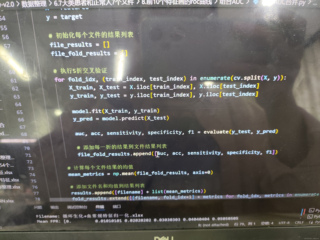

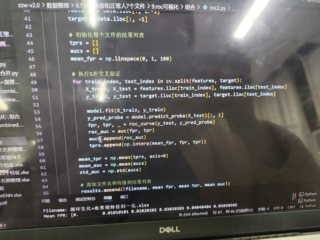

我用python进行kCV交叉验证,第一张图是我第一次计算五折交叉验证的AUC,acc均值,第3张图是我想画一个交叉验证的ROC曲线,用均值画,,但是!AUC结果竟然不一样,为什么,auc高了好多,为啥

我用python进行kCV交叉验证,第一张图是我第一次计算五折交叉验证的AUC,acc均值,第3张图是我想画一个交叉验证的ROC曲线,用均值画,,但是!AUC结果竟然不一样,为什么,auc高了好多,为啥

关注

关注引自免费微信小程序:皆我百晓生

从您提供的信息来看,您在使用Python进行交叉验证时遇到了一些困惑,主要是在不同代码片段中得到的AUC值有差异。这可能是由于不同的评估方法导致的。让我们分析一下。

首先,我们看到您在两个不同的脚本中进行了交叉验证并计算了AUC值。第一个脚本(AUC合并.py)中,您使用的是模型的预测结果来进行AUC和精度等指标的计算,而第二个脚本(roc2.py)则使用了模型的预测概率来进行AUC的计算。

在第一个脚本中,您可能使用了一个阈值将预测概率转换为二分类结果,然后计算AUC。而在第二个脚本中,您直接使用了预测的概率值,这样得到的AUC通常会更高,因为它考虑了所有可能的阈值,并且通常比基于硬分类阈值的AUC更准确。

要解决这个问题,您可以确保在两个脚本中都使用相同的评估方法。例如,如果您想在两个脚本中都使用预测概率计算AUC,那么在第一个脚本中,您也需要使用预测概率而不是硬分类结果。以下是修改后的代码段:

import numpy as np

from sklearn.metrics import roc_auc_score

# ... 其他代码 ...

67

y_pred_proba = model.predict_proba(X_test)[:, 1] # 获取预测概率

68

auc = roc_auc_score(y_test, y_pred_proba) # 使用预测概率计算AUC

如果您想要与第二个脚本中的结果保持一致,应该使用这个修改后的代码段替换原始的第67和68行。这样,无论哪个脚本,您都将基于预测概率计算AUC,从而获得一致的结果。

此外,确保在两个脚本中使用的其他参数、模型以及交叉验证策略都是相同的,这有助于进一步减少差异。

关于绘制ROC曲线,您可以使用matplotlib库中的plot()函数来绘制平均ROC曲线。这里是一个简单的示例:

import matplotlib.pyplot as plt

# ... 其他代码 ...

# 在此处计算出mean_tpr和mean_auc变量

# mean_tpr = ...

# mean_auc = ...

plt.plot(mean_fpr, mean_tpr, label=f'Mean ROC (AUC = {mean_auc:.2f})')

plt.legend(loc="lower right")

plt.xlabel('False Positive Rate')

plt.ylabel('True Positive Rate')

plt.title('Receiver Operating Characteristic')

plt.show()

这段代码将会显示一个包含平均ROC曲线的图表,标题为"Receiver Operating Characteristic",x轴表示假阳性率(FPR),y轴表示真阳性率(TPR)。平均AUC会在图例中显示。

如果还有其他疑问或需要进一步的帮助,请随时告诉我。