在A-LOAM特征提取中融合transformer自注意力机制使其在KITTI数据集00序列的表现更优,或者有其他方法可以改进A-LOAM,愿意参纳(有偿)

6条回答 默认 最新

关注

关注让【宝码香车】来帮你解答,本回答参考DeepSeek编写,并整理提供。

如果还有疑问可以点击头像关注私信或评论。如果答案让您满意,请采纳、点赞、关注,非常感谢!

改进A-LOAM在KITTI数据集00序列的优化方案

针对您提出的改进A-LOAM在KITTI 00序列表现的需求,我将提供几种可行的优化方案,包括融合Transformer自注意力机制的方法以及其他改进方向。

1. 融合Transformer自注意力机制的方案

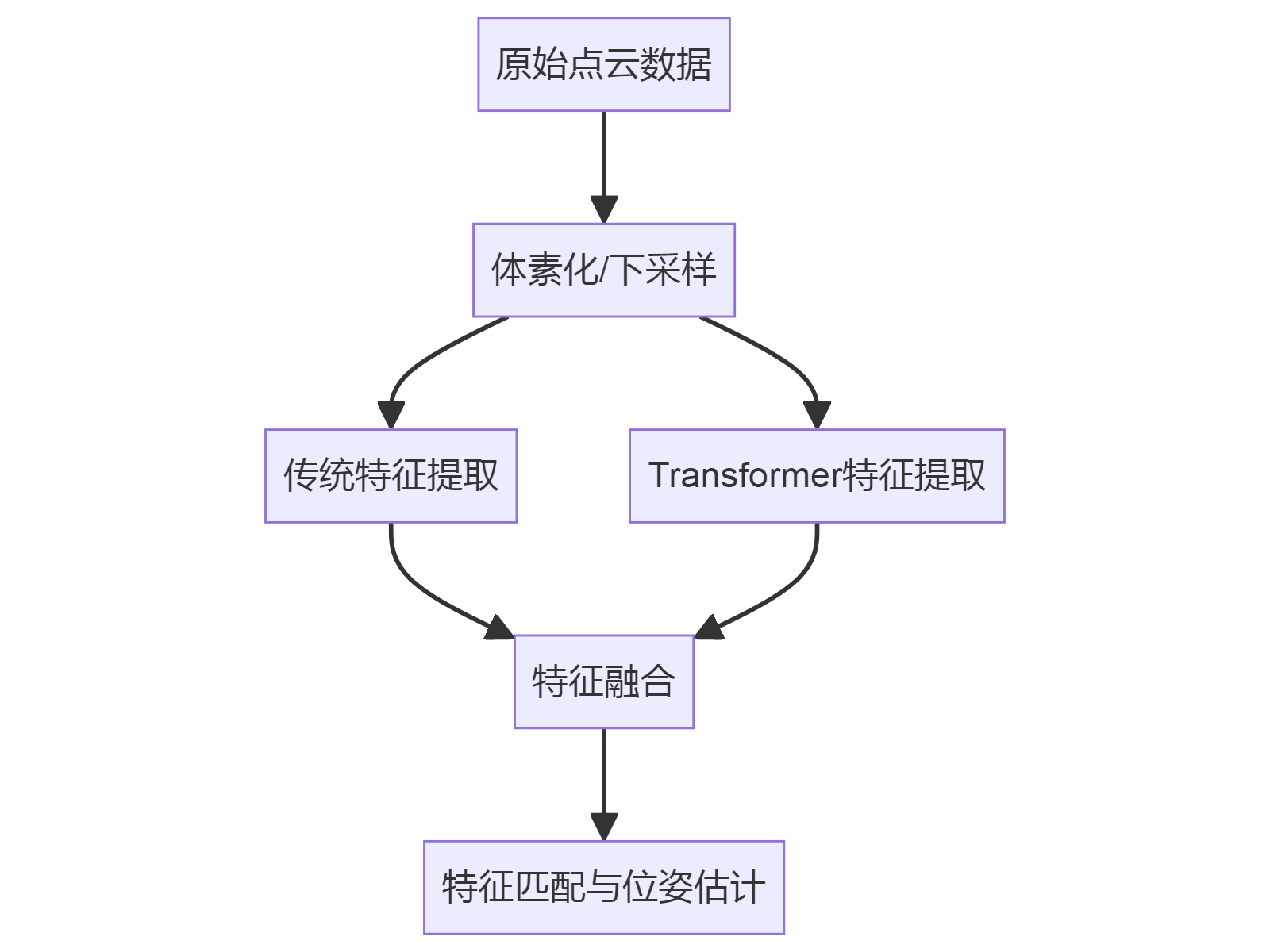

1.1 特征提取模块改进

在A-LOAM的特征提取阶段,可以引入Transformer来增强点云特征的表达能力:

import torch import torch.nn as nn from einops import rearrange class PointCloudTransformer(nn.Module): def __init__(self, dim=64, depth=2, heads=4, dim_head=32): super().__init__() self.to_patch_embedding = nn.Sequential( nn.Linear(3, dim), nn.GELU(), nn.Linear(dim, dim) ) self.transformer = nn.TransformerEncoder( nn.TransformerEncoderLayer(d_model=dim, nhead=heads), num_layers=depth ) def forward(self, x): # x: (B, N, 3) x = self.to_patch_embedding(x) # (B, N, dim) x = self.transformer(x) # (B, N, dim) return x1.2 改进后的特征提取流程

2. 其他改进A-LOAM的方法

2.1 动态特征权重调整

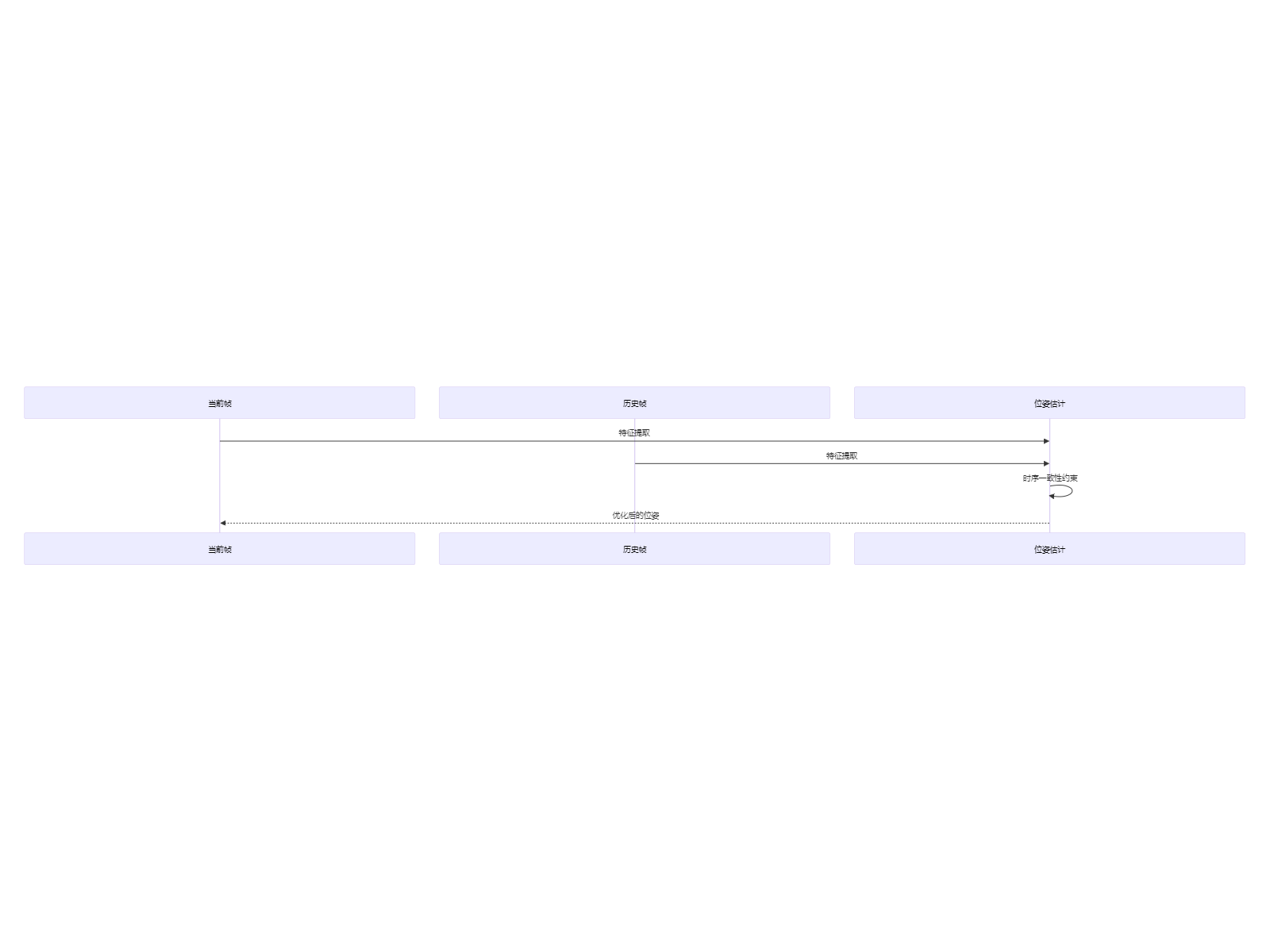

class DynamicFeatureWeight(nn.Module): def __init__(self, in_channels): super().__init__() self.conv = nn.Sequential( nn.Conv1d(in_channels, in_channels//2, 1), nn.BatchNorm1d(in_channels//2), nn.ReLU(), nn.Conv1d(in_channels//2, 1, 1), nn.Sigmoid() ) def forward(self, x): # x: (B, C, N) weights = self.conv(x) # (B, 1, N) return x * weights2.2 时序一致性优化

2.3 基于KITTI 00序列的特定优化

- 地面点优化:针对KITTI数据集中地面占比较大的特点

- 动态物体过滤:增强对移动车辆的鲁棒性

- 回环检测增强:结合视觉或点云描述子

3. 实施建议

- 评估指标:建议使用ATE(Absolute Trajectory Error)和RPE(Relative Pose Error)作为主要评估指标

- 分阶段实施:先验证Transformer模块的有效性,再逐步集成其他优化

- 硬件需求:Transformer模块会增加计算量,建议使用GPU加速

4. 有偿合作说明

如果您需要更深入的技术支持或完整的实现,我们可以提供:

- 完整的代码实现与部署

- 针对KITTI 00序列的定制优化

- 性能评估与调优服务

您可以根据实际需求选择最适合的优化方案组合。建议先从Transformer特征融合开始尝试,因为这是提升特征表达能力的直接方法。

解决 无用评论 打赏 举报