想咨询一个问题,在目标检测任务中,可以将预测每个类别的概率sofamax一下,然后利用知识蒸馏的逻辑蒸馏,教师模型可以提高学生模型的检测效果,我想问一下语义分割中,这个东西还可以用吗,怎么做逻辑蒸馏?有没有相应文章推荐呢?

5条回答 默认 最新

关注

关注让【宝码香车】来帮你解答,本回答参考DeepSeek编写,并整理提供。

如果还有疑问可以点击头像关注私信或评论。如果答案让您满意,请采纳、点赞、关注,非常感谢!

若您愿意支持,欢迎直接打赏,将不胜感激!

语义分割中的知识蒸馏方法

语义分割任务中确实可以应用知识蒸馏技术,而且逻辑蒸馏(Logits Distillation)的思想可以很好地迁移到语义分割任务中。下面我将详细介绍实现方法和相关研究。

语义分割中的知识蒸馏原理

在语义分割中,知识蒸馏的核心思想与目标检测类似,都是让教师模型的输出(通常是softmax后的概率分布)指导学生模型的训练。不同之处在于语义分割是对每个像素点进行分类,因此蒸馏是在像素级别进行的。

基本实现方法

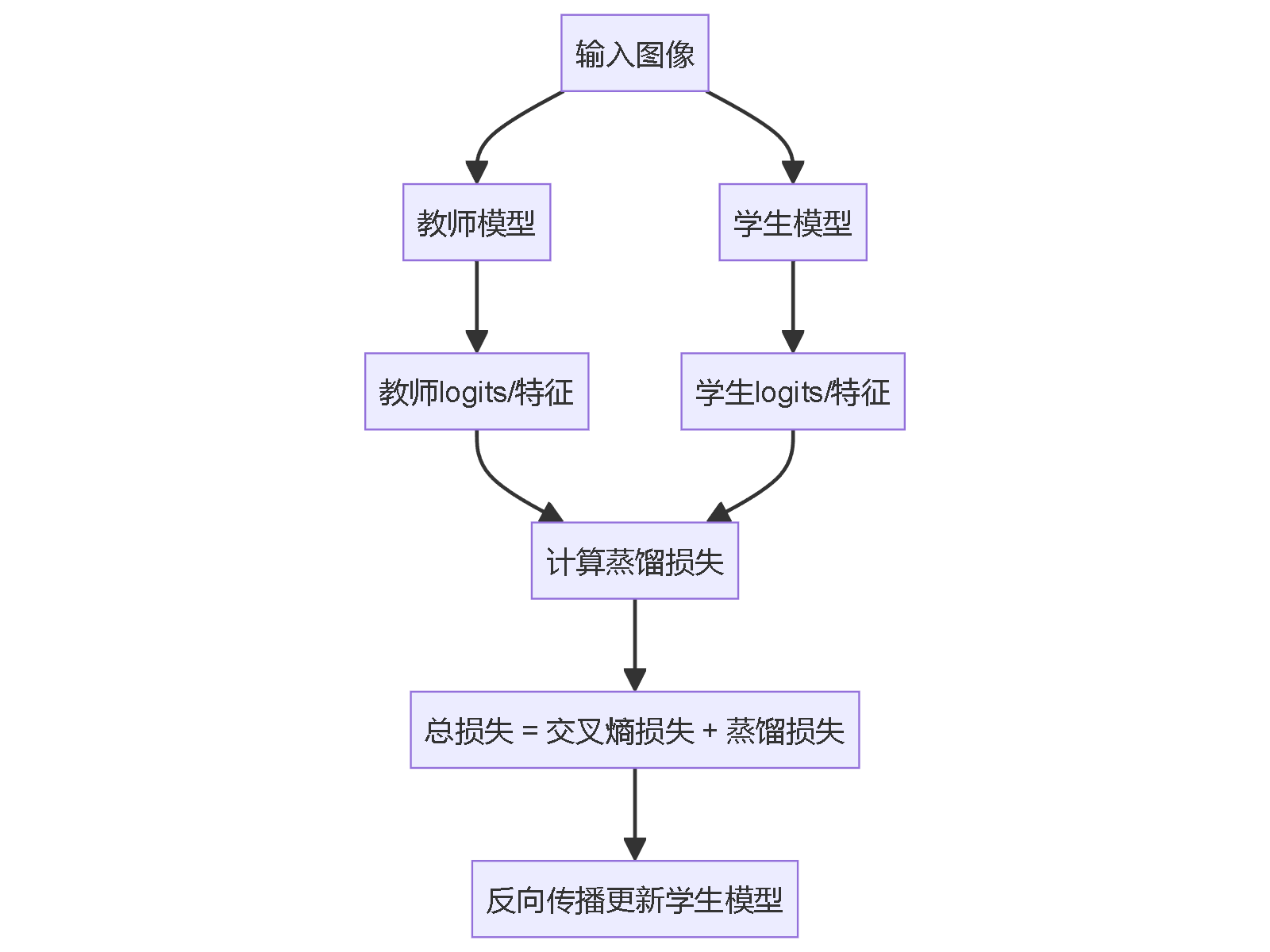

import torch import torch.nn as nn import torch.nn.functional as F class SegmentationDistillLoss(nn.Module): def __init__(self, alpha=0.5, temperature=3): super().__init__() self.alpha = alpha # 蒸馏损失权重 self.temperature = temperature self.ce_loss = nn.CrossEntropyLoss() def forward(self, student_logits, teacher_logits, labels): # 常规交叉熵损失 ce_loss = self.ce_loss(student_logits, labels) # 蒸馏损失 soft_teacher = F.softmax(teacher_logits / self.temperature, dim=1) soft_student = F.log_softmax(student_logits / self.temperature, dim=1) distill_loss = F.kl_div(soft_student, soft_teacher, reduction='batchmean') * (self.temperature ** 2) # 总损失 total_loss = (1 - self.alpha) * ce_loss + self.alpha * distill_loss return total_loss语义分割知识蒸馏流程

进阶蒸馏方法

除了基本的逻辑蒸馏外,语义分割中还有以下几种常用方法:

- 特征蒸馏:在中间层对齐教师和学生模型的特征图

- 关系蒸馏:捕捉像素间的关系信息

- 结构化蒸馏:考虑分割任务的结构化特性

推荐论文

- 《Structured Knowledge Distillation for Semantic Segmentation》 (CVPR 2019)

- 提出结构化知识蒸馏,考虑像素间关系

- 《Knowledge Distillation via Instance Relationship Graph》 (CVPR 2019)

- 使用实例关系图进行蒸馏

- 《Knowledge Adaptation for Efficient Semantic Segmentation》 (CVPR 2019)

- 针对高效语义分割的知识适应方法

- 《Pixel-wise Knowledge Distillation for Dense Prediction》 (TPAMI 2021)

- 像素级别的知识蒸馏框架

- 《Distilling Cross-Task Knowledge via Relationship Matching》 (CVPR 2020)

- 通过关系匹配进行跨任务知识蒸馏

实践建议

- 温度参数调节:通常设置在3-5之间,需要根据任务调整

- 损失权重平衡:蒸馏损失和常规损失的权重需要调优

- 多阶段蒸馏:可以结合逻辑蒸馏和特征蒸馏

- 教师模型选择:教师模型不宜过于复杂,与学生模型差距不宜过大

语义分割中的知识蒸馏已经证明能有效提升小模型的性能,特别是在边缘设备部署场景下非常有用。

本回答被题主选为最佳回答 , 对您是否有帮助呢?解决 无用评论 打赏 举报