让 “紫雾凌寒” 来帮你回答,本回答结合 DeepSeek

如果还有问题,请评论或点击头像私信,如果有帮助到您, 请关注、采纳、点赞

- 关键点分析:

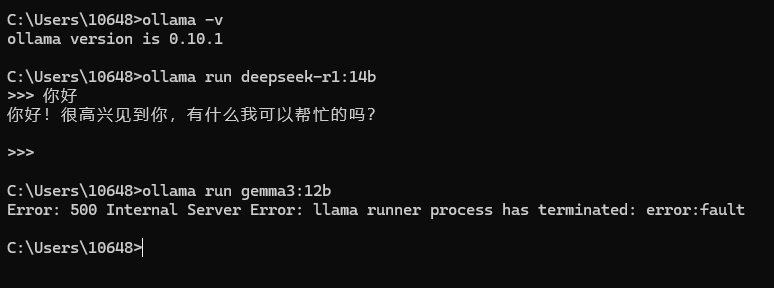

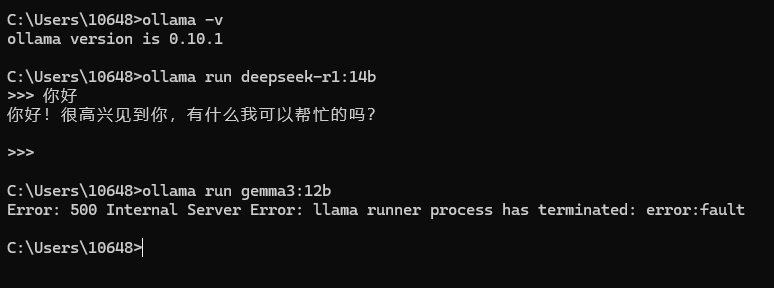

- 主要问题是在ollama上部署deepseek - r1:14b能正常运行,而gemma3:12b出现报错“Error: 500 Internal Server Error: llama runner process has terminated: error:fault”。

- 可能原因包括gemma3:12b模型本身的兼容性问题、ollama配置问题、资源不足等。 - 解决方案:

- 检查模型兼容性:- 确认gemma3:12b模型与ollama的版本是否兼容。可以查看ollama官方文档中支持的模型列表及版本要求。

- 检查ollama配置:

- 查看ollama的日志文件(通常在ollama安装目录下的logs文件夹中),获取更详细的错误信息,以确定具体是哪个环节出错。例如日志中可能会显示缺少某些依赖库等信息。

- 检查ollama的配置文件(一般是~/.ollama/config.yaml),确保配置参数正确。比如内存分配等参数是否适合gemma3:12b模型。例如:

memory: 16GB # 根据模型需求调整,可尝试不同值

- 资源检查:

- 确保服务器有足够的资源(如CPU、内存等)来运行gemma3:12b模型。如果资源不足,可能导致模型运行过程中出错。可以使用top、htop等工具查看系统资源使用情况。

- 尝试重新安装模型:

- 在ollama中删除已安装的gemma3:12b模型,然后重新安装。命令如下:

ollama uninstall gemma3:12b

ollama pull gemma3:12b

- 不同解决方案的优缺点:

- 检查模型兼容性:- 优点:能快速定位是否是模型与ollama版本不匹配导致的问题,如果是可以及时找到解决方向。

- 缺点:可能需要花费时间去查找官方文档确认版本兼容性信息。

- 检查ollama配置:

- 优点:通过查看日志和配置文件,可以深入了解报错原因,针对性地进行调整。

- 缺点:分析日志和配置文件需要一定的技术经验,可能较难快速找到关键问题。

- 资源检查:

- 优点:能直接发现资源不足这个潜在问题,及时解决可避免后续类似错误。

- 缺点:可能需要熟悉系统资源查看工具的使用,对于不熟悉的用户有一定难度。

- 尝试重新安装模型:

- 优点:简单直接,如果是模型安装过程中出现损坏等问题,重新安装可能解决。

- 缺点:如果不是安装问题,重新安装也无法解决根本问题,且可能浪费下载时间。

- 总结:

- 针对“gemma3:12b在ollama上报错500 Internal Server Error”的问题,需要从模型兼容性、ollama配置、资源情况等多方面进行排查。通过检查日志、配置文件、资源使用情况以及尝试重新安装模型等方法,逐步定位并解决问题。

需要注意的是,具体的解决方法可能因服务器环境、ollama版本等因素而有所不同,上述方法仅供参考。

希望以上解答对您有所帮助。如果您有任何疑问,欢迎在评论区提出。

关注

关注