复现这个大学生助学金预测的代码,对结果不太理解,为什么作者官方给的训练结果,准确率那么低,这是正常现象吗?还有为什么datacastle上0.03就是最高分,实在搞不懂,正常的macro F1 score不是都0.7,0.8这样吗,求各位解释一下

https://github.com/lzddzh/DataMiningCompetitionFirstPrize

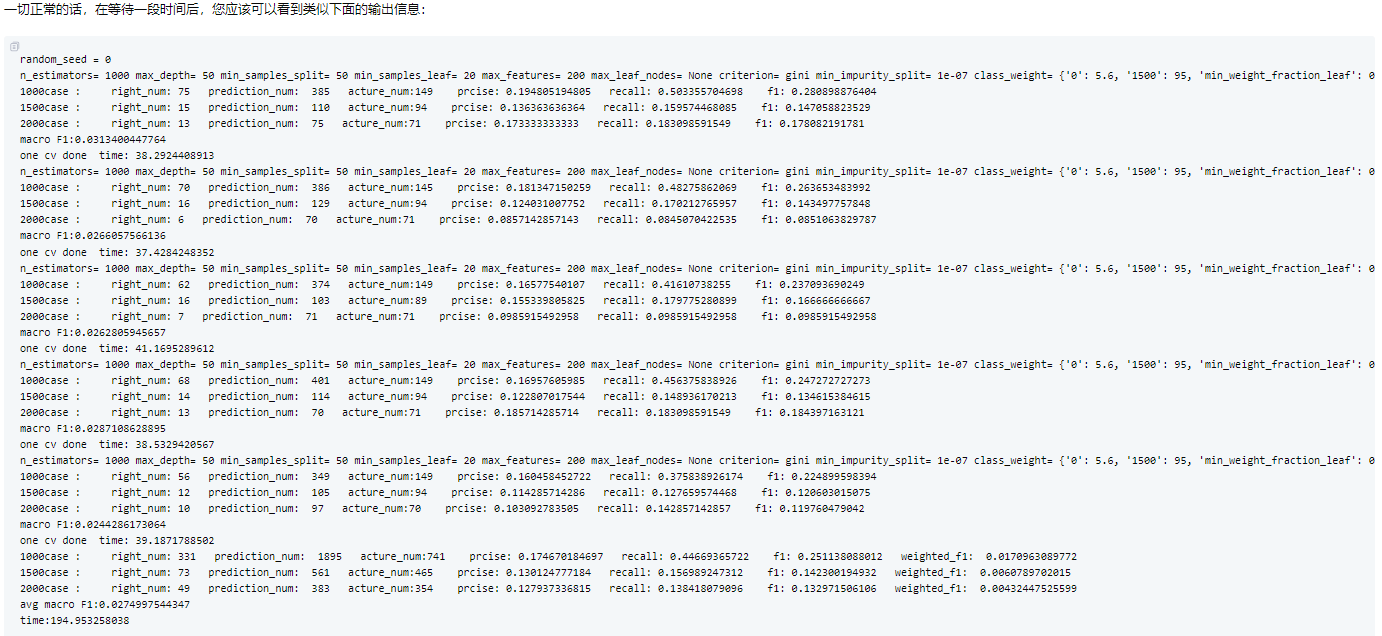

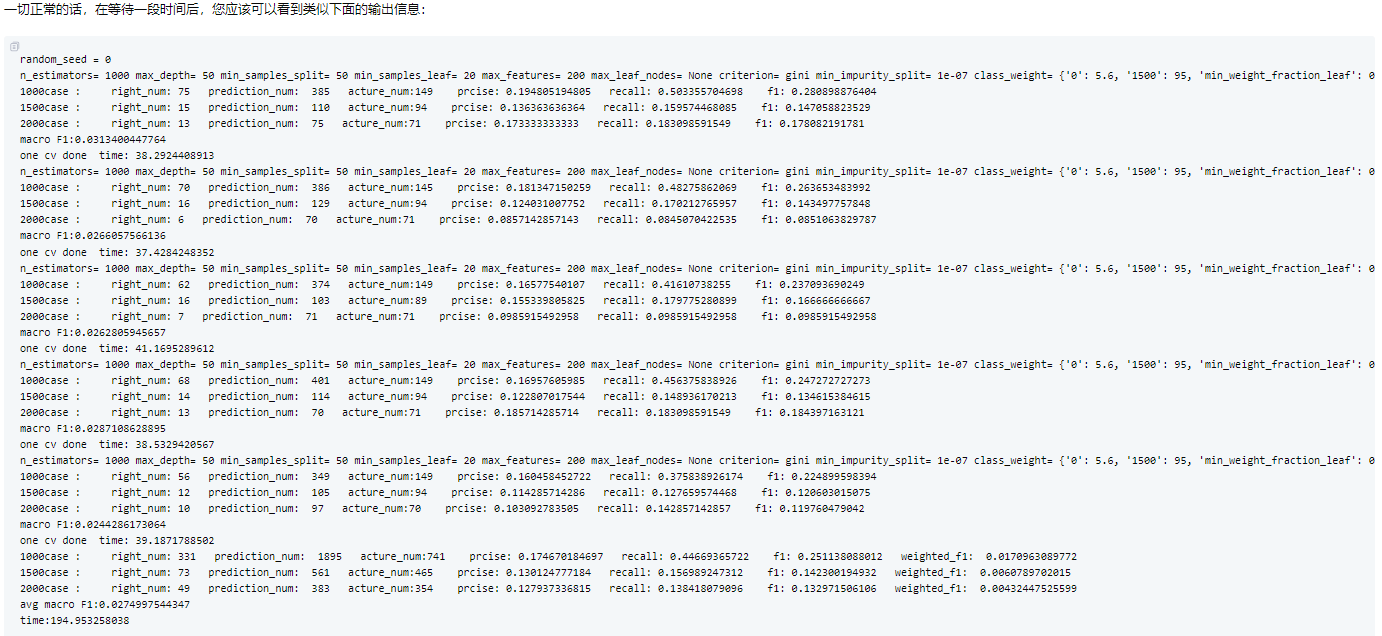

复现这个大学生助学金预测的代码,对结果不太理解,为什么作者官方给的训练结果,准确率那么低,这是正常现象吗?还有为什么datacastle上0.03就是最高分,实在搞不懂,正常的macro F1 score不是都0.7,0.8这样吗,求各位解释一下

https://github.com/lzddzh/DataMiningCompetitionFirstPrize

下午好🌅🌅🌅

本答案参考通义千问

你提到的这个项目是关于大学生助学金预测的,属于数据挖掘竞赛(Data Mining Competition)的一种,通常这类任务的目标是通过学生的各种特征(如成绩、家庭情况、消费记录等)来预测是否符合获得助学金的条件。

你提到的代码链接是:https://github.com/lzddzh/DataMiningCompetitionFirstPrize,这是一个GitHub仓库,可能包含了一些模型训练和预测的代码。你对以下几点有疑问:

下面我将逐一为你解释这些现象,并提供一些分析建议。

重点:

当数据集存在严重类别不平衡时,准确率不是一个可靠的评价指标。

重点:

不同的竞赛平台有不同的评分标准,不要用常规的F1或准确率去理解它们的得分。

重点:

不要混淆不同的评估指标!

例如:Log Loss 和 F1 Score 是完全不同的概念,不能直接比较。

如果你希望复现并改进这个项目,可以参考以下步骤:

import pandas as pd

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler, LabelEncoder

# 加载数据

df = pd.read_csv('data.csv')

# 处理缺失值

df.fillna(df.median(), inplace=True)

# 编码分类变量

le = LabelEncoder()

df['category'] = le.fit_transform(df['category'])

# 标准化

scaler = StandardScaler()

df_scaled = scaler.fit_transform(df.drop('target', axis=1))

X_train, X_test, y_train, y_test = train_test_split(

df_scaled, df['target'], test_size=0.2, random_state=42

)

from xgboost import XGBClassifier

from sklearn.metrics import f1_score, accuracy_score

model = XGBClassifier(use_label_encoder=False, eval_metric='logloss')

model.fit(X_train, y_train)

y_pred = model.predict(X_test)

print("Accuracy:", accuracy_score(y_test, y_pred))

print("Macro F1 Score:", f1_score(y_test, y_pred, average='macro'))

from sklearn.model_selection import GridSearchCV

param_grid = {

'n_estimators': [100, 200],

'learning_rate': [0.01, 0.1],

'max_depth': [3, 5]

}

grid_search = GridSearchCV(XGBClassifier(use_label_encoder=False), param_grid, cv=5)

grid_search.fit(X_train, y_train)

best_model = grid_search.best_estimator_

| 问题 | 原因 | 解释 | |------|------|------| | 准确率低 | 类别不平衡、模型简单、数据预处理不足 | 准确率不是最佳指标,应关注F1、AUC等 | | 0.03是最高分 | 评分指标可能为Log Loss或MSE | 不同平台评分标准不同,不要混淆指标 | | F1 score是否应在0.7~0.8 | 视数据难度而定 | 中等难度下是合理的,但也要看具体任务 |

如果你愿意,我可以帮你进一步分析该仓库中的代码,并指出其中可能存在的问题。欢迎继续提问!