晚上好🌙🌙🌙

本答案参考通义千问

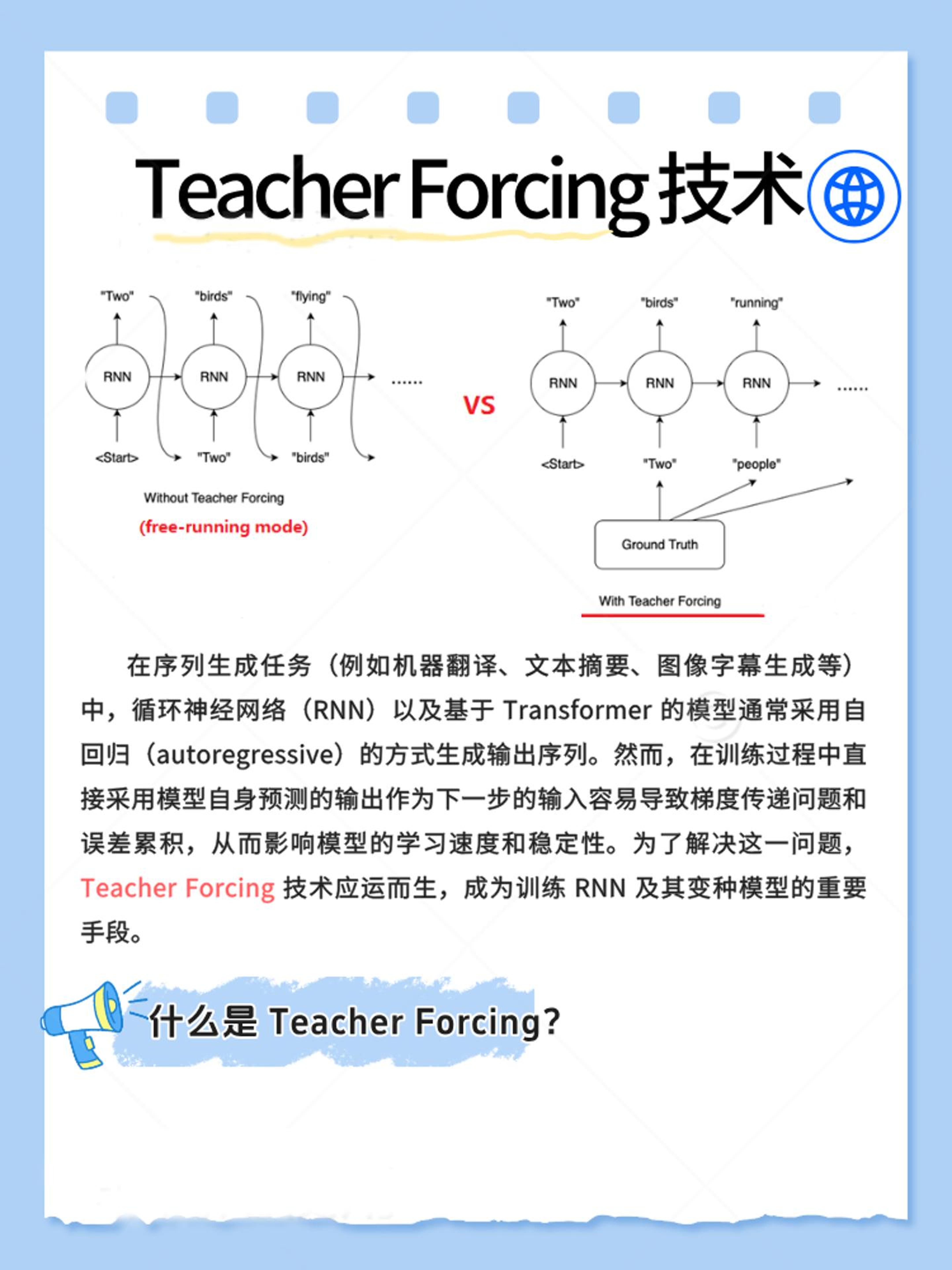

Teacher Forcing 是一种在序列生成模型(如语言模型、机器翻译、语音识别等)中广泛使用的训练策略。它通过在训练过程中使用真实的目标输出(即 ground truth)作为下一步的输入,而不是模型自己预测的结果,从而提升模型的学习效率和稳定性。

为什么需要 Teacher Forcing?

-

自回归模型中的问题

在自回归模型中,每一步的预测都依赖于前一步的输出。如果模型在早期步骤中预测错误,这些错误会随着后续步骤不断累积,导致最终结果偏离正确路径。

-

长时依赖关系难以捕捉

由于错误传播的问题,模型在训练时很难准确学习到长时依赖关系(如句子中的上下文或段落结构)。

-

训练不稳定

如果模型在早期阶段输出错误,会导致梯度不稳定,甚至出现梯度消失或爆炸的问题。

Teacher Forcing 的作用

1. 加速训练收敛

- 每一时刻均使用 ground truth 信息,模型不必承受早期预测错误的累积。

- 能更快学习到正确的序列依赖关系。

2. 提高训练稳定性

- 避免了因模型错误带来的梯度不稳定问题。

- 使得训练过程更加平滑,尤其在处理长序列任务时表现更好。

Teacher Forcing 的工作原理

以一个简单的语言模型为例:

- 初始输入:

[START],期望输出 Mary。 - 下一步:即使模型第一步预测为

a,教师强制机制会忽略该预测,直接将 Mary 作为下一步的输入,期望输出 had。

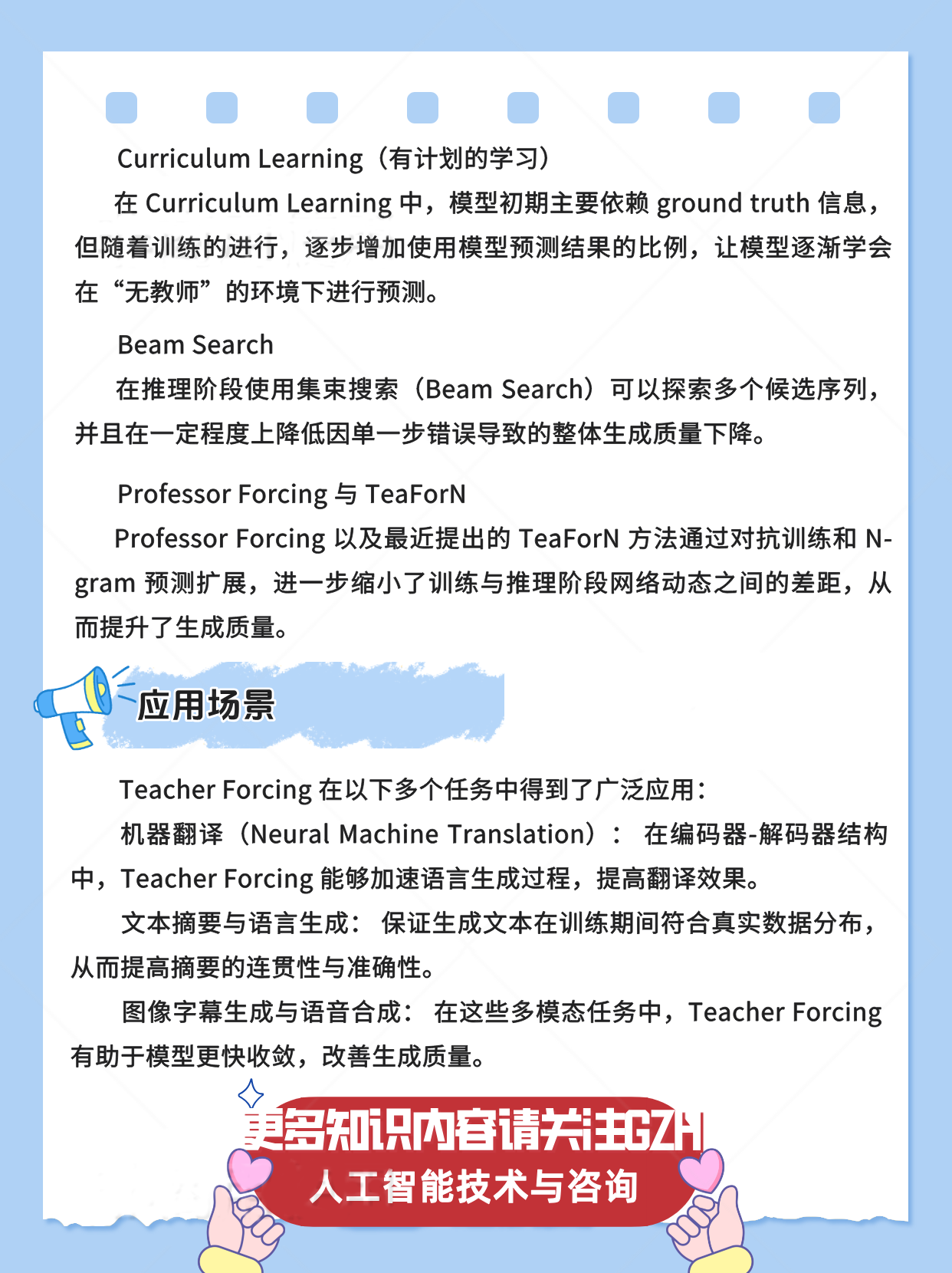

Free-running 模式(无 Teacher Forcing)

- 模型每一步的输入为上一时刻预测值。

- 若初始预测错误,则可能导致后续输出全盘失误。

Teacher Forcing 模式

- 每一步都以 ground truth 作为输入。

- 保证模型学习到正确的统计分布。

Teacher Forcing 的优缺点

优点

-

训练效率高

- 每一步都使用正确输入,模型能更快对比预测值与实际值。

- 误差能及时反馈,加速收敛。

-

更稳定的梯度传递

- 避免了因连续错误输入带来的梯度不稳定问题。

- 在复杂长序列任务上表现更好。

缺点

-

暴露偏差(Exposure Bias)

- 训练过程中始终依赖 ground truth 信息。

- 而在推理阶段,模型需要使用自己的预测值作为输入,导致训练与推理时输入分布不一致。

- 这种不匹配可能导致生成质量下降。

-

推理表现不稳定

- 训练过程中没有模拟真实生成时的累积误差。

- 模型在测试阶段容易出现错误传递和解码偏差。

对抗 Teacher Forcing 缺点的改进方法

1. Scheduled Sampling

- 在训练过程中以一定概率选择使用模型自身的预测结果而非 ground truth 作为下一步输入。

- 逐步过渡到与推理时一致的生成方式。

- 能够缓解训练与推理之间的差异,使模型具备“自纠正”能力。

2. Curriculum Learning

- 模型初期主要依赖 ground truth 信息。

- 随着训练的进行,逐步增加使用模型预测结果的比例。

- 让模型逐渐学会在“无教师”的环境下进行预测。

3. 推理阶段使用集束搜索(Beam Search)

- 探索多个候选序列。

- 在一定程度上降低因单一步错误导致的整体生成质量下降。

4. Professor Forcing 和 TeaForN

- 通过对抗训练和 N-gram 预测扩展,进一步缩小训练与推理阶段网络动态之间的差距。

- 提升生成质量。

总结:Teacher Forcing 的核心思想

| 核心思想 | 内容 |

|----------|------|

| 输入来源 | 使用 ground truth 作为每一步的输入 |

| 目的 | 提高训练效率和稳定性,避免错误累积 |

| 问题 | 导致训练与推理阶段的输入分布不一致(Exposure Bias) |

| 改进方向 | 逐步引入模型预测,模拟真实推理环境 |

示例代码(基于 PyTorch)

以下是一个简单的 Teacher Forcing 实现示例(适用于 Seq2Seq 模型):

import torch

import torch.nn as nn

class EncoderDecoder(nn.Module):

def __init__(self, input_size, hidden_size, output_size):

super().__init__()

self.encoder = nn.LSTM(input_size, hidden_size)

self.decoder = nn.LSTM(hidden_size, output_size)

def forward(self, src, tgt, teacher_forcing_ratio=0.5):

# src: [seq_len, batch_size]

# tgt: [seq_len, batch_size]

encoder_out, (hidden, cell) = self.encoder(src)

outputs = torch.zeros(tgt.size(0), tgt.size(1), output_size).to(src.device)

# 第一个输入是 <SOS>

input = torch.tensor([0]).repeat(tgt.size(1)).to(src.device) # 假设 0 是 <SOS> token

for t in range(tgt.size(0)):

decoder_out, (hidden, cell) = self.decoder(input.unsqueeze(0), (hidden, cell))

outputs[t] = decoder_out.squeeze(0)

# 判断是否使用 Teacher Forcing

use_teacher_forcing = torch.rand(1).item() < teacher_forcing_ratio

if use_teacher_forcing:

input = tgt[t] # 使用真实目标输出

else:

input = decoder_out.argmax(1) # 使用模型预测的输出

return outputs

说明:

teacher_forcing_ratio 控制在训练过程中使用真实目标的概率。- 当

teacher_forcing_ratio=1 时,完全使用 Teacher Forcing;当 teacher_forcing_ratio=0 时,完全使用模型预测(即推理模式)。

总结

Teacher Forcing 是一种有效的训练策略,能够显著提高模型的训练速度和稳定性。然而,其在推理阶段可能带来 Exposure Bias 问题,因此需要结合 Scheduled Sampling、Curriculum Learning 等方法进行优化,以实现更好的生成效果。