晚上好🌙🌙🌙

本答案参考通义千问

Teacher Forcing 技术解析 是人工智能领域中一个非常重要的概念,尤其在自回归模型(如语言模型、图像生成模型等)的训练过程中扮演着关键角色。下面我将详细解析 Teacher Forcing 的原理、作用、优缺点以及相关改进方法。

一、为什么需要 Teacher Forcing?

1. 自回归模型中的问题

在自回归模型中,模型的每一步输出都依赖于前一步的预测结果。例如,在生成句子时,模型会根据“我”生成“喜欢”,再根据“喜欢”生成“阅读”。

- 问题: 如果在早期步骤中模型预测错误,这个错误会在后续步骤中不断累积,最终导致整个序列生成失败。

- 后果: 模型难以学习到长时依赖关系,导致生成质量差。

2. 教师强制(Teacher Forcing)的作用

为了解决上述问题,Teacher Forcing 被引入:

- 加速训练收敛:每一时刻均使用 ground truth(真实标签)作为输入,避免了因早期预测错误带来的误差累积。

- 提高训练稳定性:避免因错误输入导致的梯度消失或爆炸问题,使训练过程更加平滑。

二、Teacher Forcing 的工作原理

以一个简单的语言模型为例,假设我们要生成下一个单词:

- 初始输入:

[START],期望输出 Mary。 - 下一步:即使模型第一步预测为

a,教师强制机制会忽略预测结果,直接将正确单词 Mary 作为下一步的输入。

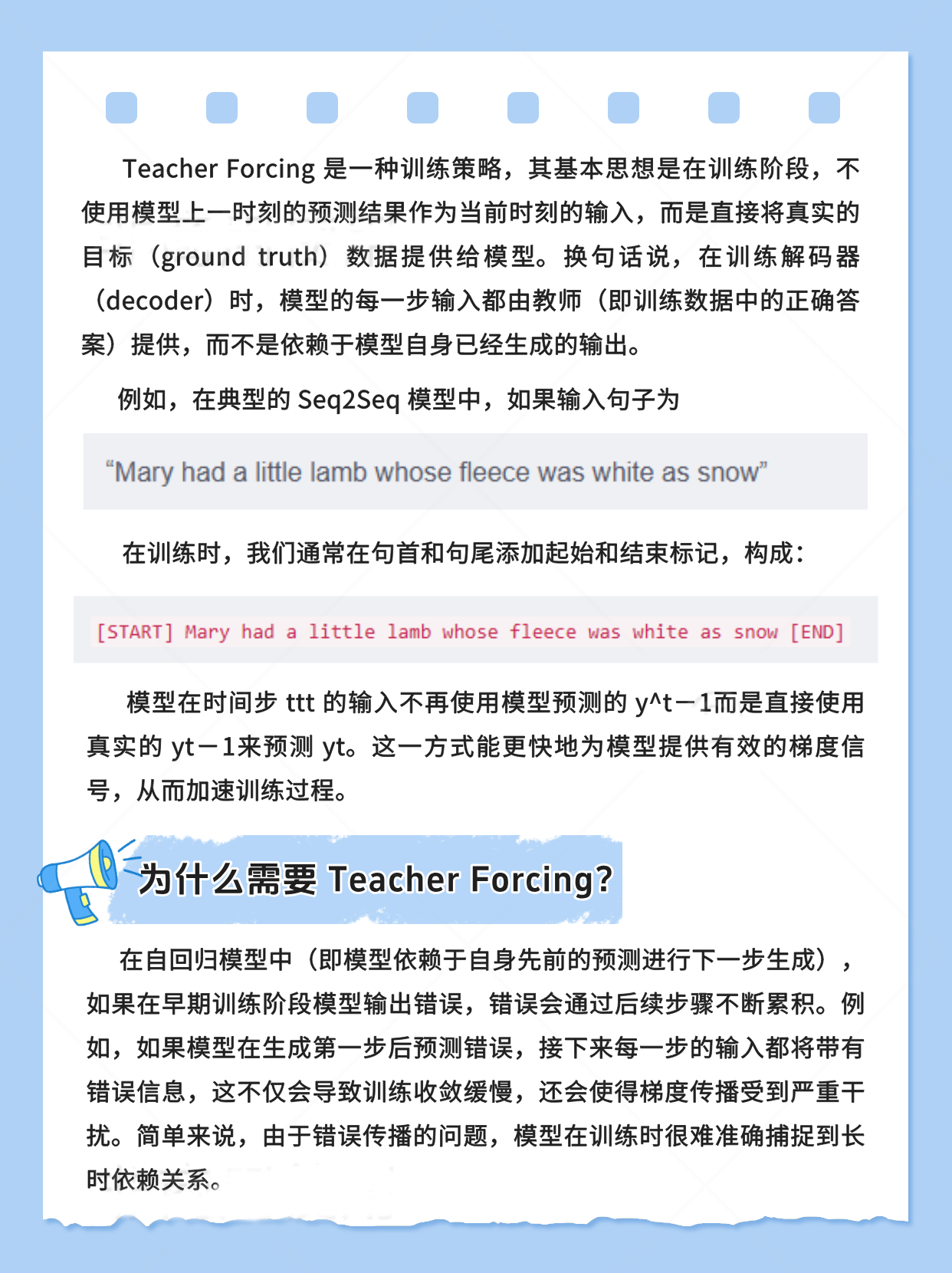

对比两种模式:

| 模式 | 输入来源 | 优点 | 缺点 |

|------|----------|------|------|

| Free-running 模式 | 上一步预测值 | 接近推理阶段 | 容易因早期错误导致后续失败 |

| Teacher Forcing 模式 | ground truth | 稳定、快速收敛 | 训练与推理不一致 |

三、Teacher Forcing 的优缺点

✅ 优点

-

训练效率高

- 每一步都使用正确输入,模型能更快对比预测值与实际值,使得误差能及时反馈,从而加速收敛。

-

更稳定的梯度传递

- 避免了因连续错误输入带来的梯度不稳定问题,使得模型在复杂长序列任务上表现更好。

❌ 缺点

-

暴露偏差(Exposure Bias)

- 训练过程中始终依赖 ground truth 信息,而在实际推理阶段,模型需要使用自己的预测值作为输入,导致训练与推理时输入分布不一致,这种不匹配可能导致生成质量下降。

-

推理表现不稳定

- 由于训练过程中没有模拟真实生成时的累积误差,模型在测试阶段容易出现错误传递和解码偏差。

四、对抗 Teacher Forcing 缺点的改进方法

1. Scheduled Sampling(计划采样)

- 原理:在训练过程中,以一定概率选择使用模型自身的预测结果而非 ground truth 作为下一步输入。

- 效果:逐步过渡到与推理时一致的生成方式,缓解训练与推理之间的差异,使模型具备“自纠正”能力。

2. Curriculum Learning(课程学习)

- 原理:模型初期主要依赖 ground truth 信息,但随着训练的进行,逐步增加使用模型预测结果的比例。

- 效果:让模型逐渐学会在“无教师”的环境下进行预测。

3. Beam Search(集束搜索)

- 原理:在推理阶段使用集束搜索,探索多个候选序列。

- 效果:在一定程度上降低因单一步错误导致的整体生成质量下降。

4. Professor Forcing 和 TeaForN 方法

- Professor Forcing:通过对抗训练来缩小训练与推理之间的差距。

- TeaForN:基于 N-gram 预测扩展,进一步提升生成质量。

五、代码示例(Teacher Forcing 实现)

以下是一个使用 PyTorch 的简化版 Transformer 模型中 Teacher Forcing 的实现示例:

import torch

import torch.nn as nn

class TransformerModel(nn.Module):

def __init__(self, vocab_size, d_model, nhead, num_encoder_layers, num_decoder_layers):

super().__init__()

self.embedding = nn.Embedding(vocab_size, d_model)

self.transformer = nn.Transformer(

d_model=d_model,

nhead=nhead,

num_encoder_layers=num_encoder_layers,

num_decoder_layers=num_decoder_layers

)

self.fc_out = nn.Linear(d_model, vocab_size)

def forward(self, src, tgt, teacher_forcing_ratio=0.5):

# src: [seq_len, batch_size]

# tgt: [seq_len, batch_size]

src = self.embedding(src) # [seq_len, batch_size, d_model]

tgt = self.embedding(tgt) # [seq_len, batch_size, d_model]

output = self.transformer(src, tgt)

output = self.fc_out(output) # [seq_len, batch_size, vocab_size]

return output

# 使用 Teacher Forcing 的训练循环示例

def train(model, src, tgt, optimizer, criterion, teacher_forcing_ratio=0.5):

model.train()

optimizer.zero_grad()

# 前向传播

output = model(src, tgt, teacher_forcing_ratio)

# 计算损失

loss = criterion(output.view(-1, output.size(-1)), tgt.view(-1))

loss.backward()

optimizer.step()

return loss.item()

注意:在实际应用中,teacher_forcing_ratio 可以随着训练轮次逐渐减小,这正是 Scheduled Sampling 的思想。

六、总结

| 项目 | 内容 |

|------|------|

| Teacher Forcing | 在训练过程中使用真实标签作为输入,避免预测错误的累积 |

| 优点 | 加速收敛、稳定训练 |

| 缺点 | 导致训练与推理不一致(暴露偏差) |

| 改进方法 | Scheduled Sampling、Curriculum Learning、Beam Search、Professor Forcing、TeaForN |

如果你对某一部分(如 Scheduled Sampling 的具体实现 或 如何在实际项目中应用 Teacher Forcing)感兴趣,我可以提供更详细的解释或代码示例。