Hadoop集群的搭建一直出错,不知道哪里错了,怎么改都不对

晚上好🌙🌙🌙

本答案参考通义千问

Hadoop集群搭建过程中遇到问题是非常常见的,尤其是在分布式系统中,涉及多个组件(如HDFS、YARN、ZooKeeper等)和复杂的配置。下面我将详细分析可能的错误原因,并提供解决方案,帮助你排查和修复问题。

现象: 集群节点之间无法通信,ping命令失败或SSH无法连接。

解决方案:

检查IP地址配置

/etc/hosts 文件是否配置了所有节点的主机名与IP映射。关闭防火墙

sudo systemctl stop firewalld

sudo ufw disable

SSH免密登录配置

ssh-keygen -t rsa

ssh-copy-id user@datanode_ip

core-site.xml<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://namenode:9000</value>

</property>

</configuration>

namenode 是NameNode的主机名,确保它在 /etc/hosts 中有正确的IP映射。hdfs-site.xml<configuration>

<property>

<name>dfs.replication</name>

<value>2</value>

</property>

</configuration>

yarn-site.xml<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>resourcemanager</value>

</property>

</configuration>

resourcemanager 是ResourceManager的主机名,需在 /etc/hosts 中配置。mapred-site.xml<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

现象: 启动Hadoop时提示“Java not found”或版本不兼容。

解决方案:

安装JDK

sudo apt install openjdk-8-jdk # Ubuntu

sudo yum install java-1.8.0-openjdk-devel # CentOS

设置JAVA_HOME环境变量

~/.bashrc 或 /etc/profile:

export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64

export PATH=$PATH:$JAVA_HOME/bin

source ~/.bashrc

验证Java安装

java -version

javac -version

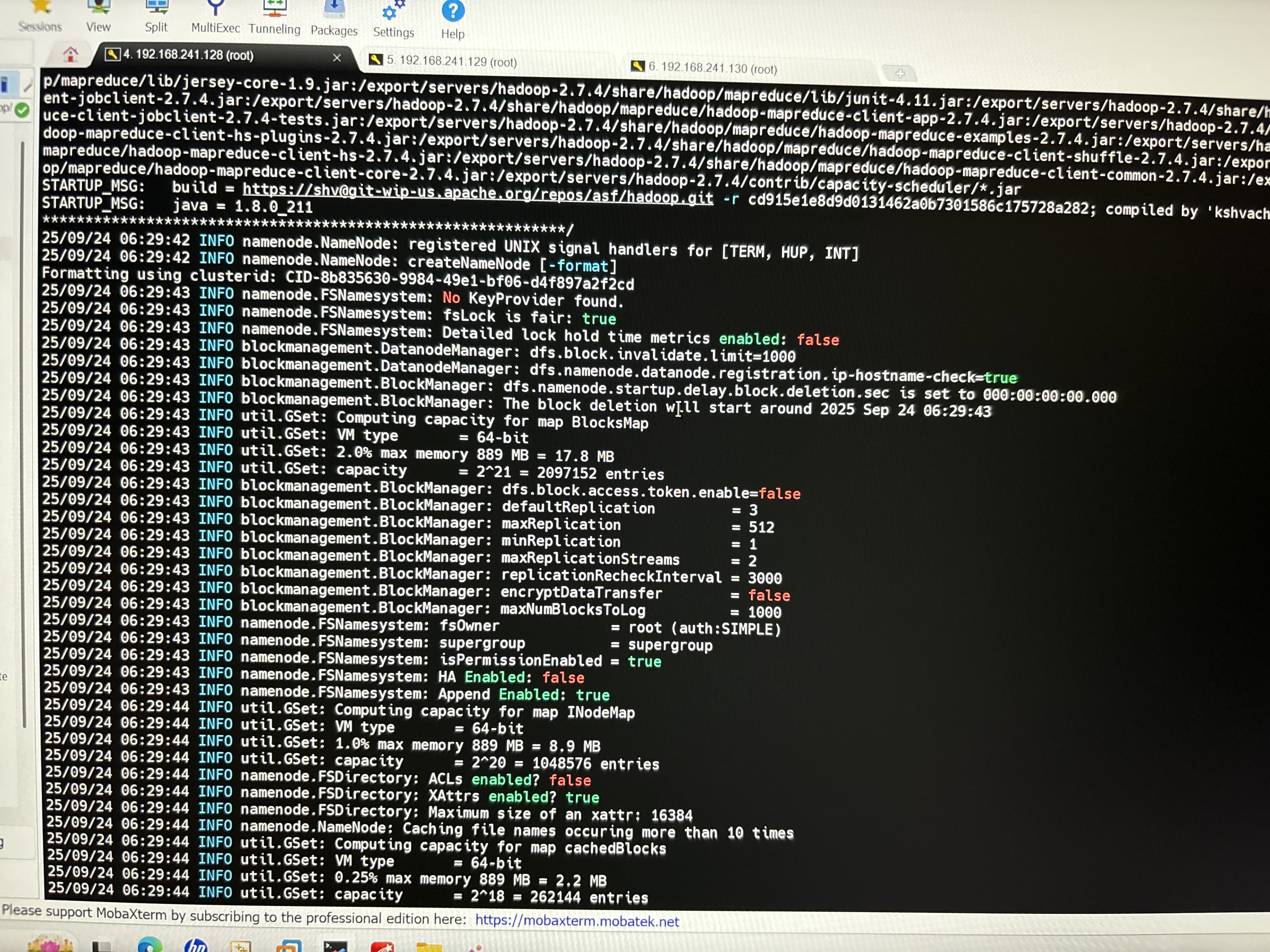

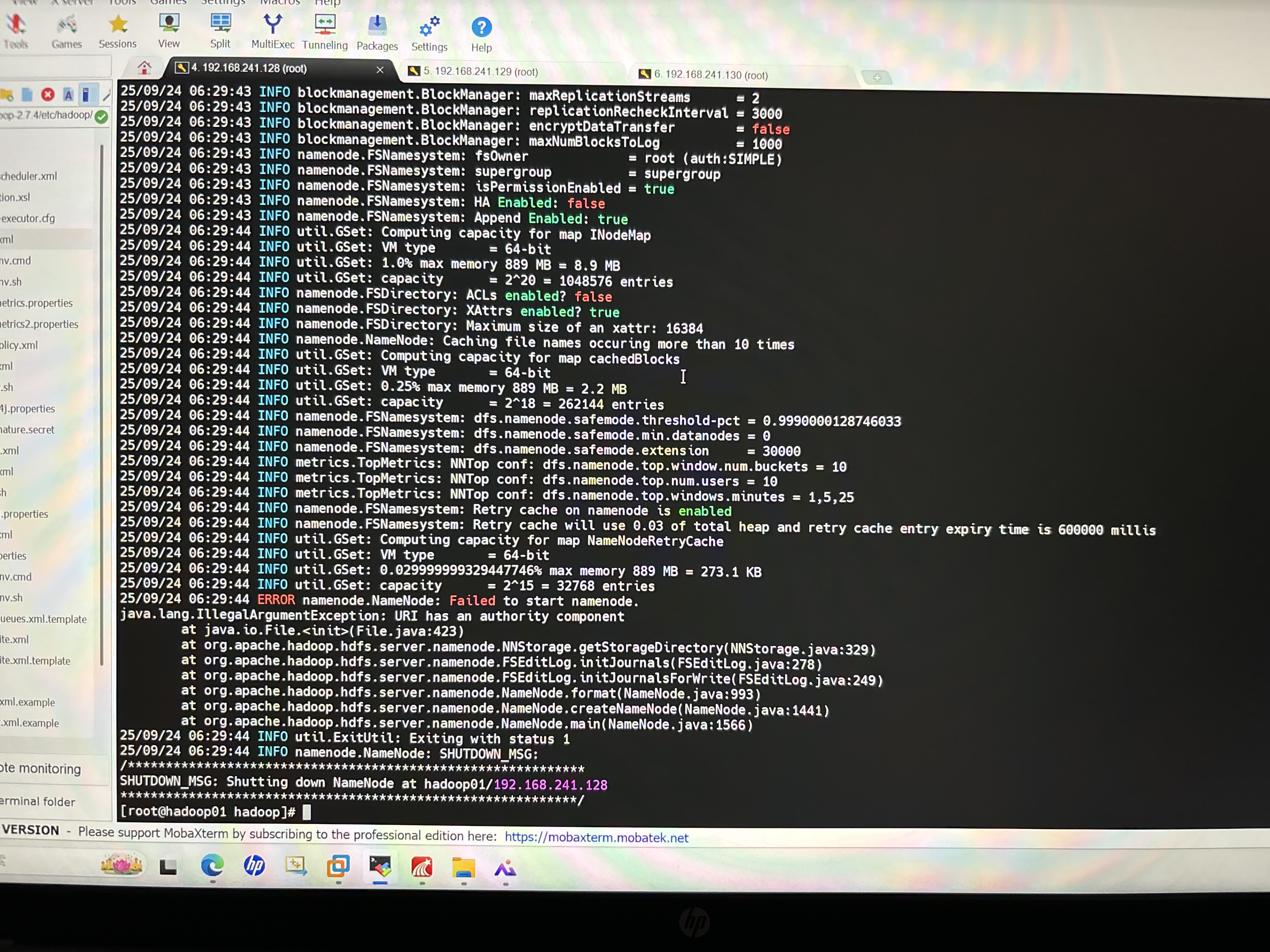

现象: 启动Hadoop后,查看日志发现如下错误:

java.net.ConnectException: Connection refused

解决方案:

检查Hadoop服务状态

jps

NameNode, DataNode, SecondaryNameNode(如果启用)等进程。查看日志文件

$HADOOP_HOME/logs/hadoop-<user>-namenode-<hostname>.log 或 hadoop-<user>-datanode-<hostname>.log 查看具体错误。重新格式化HDFS(仅在初次部署时需要)

hdfs namenode -format

现象: Hadoop无法访问某些目录,出现权限拒绝错误。

解决方案:

创建Hadoop用户目录

sudo mkdir -p /data/hadoop

sudo chown -R hadoop:hadoop /data/hadoop

修改Hadoop配置中的数据目录

hdfs-site.xml:

<property>

<name>dfs.datanode.data.dir</name>

<value>/data/hadoop/datanode</value>

</property>

准备三台服务器

配置 /etc/hosts 文件

192.168.1.100 namenode

192.168.1.101 datanode1

192.168.1.102 datanode2

配置SSH免密登录

安装Java环境

配置Hadoop核心文件

core-site.xml, hdfs-site.xml, yarn-site.xml, mapred-site.xml格式化HDFS

hdfs namenode -format

启动Hadoop

start-dfs.sh

start-yarn.sh

验证集群状态

jps

Connection refused 错误错误日志:

java.net.ConnectException: Call From namenode to datanode:50010 failed on connection exception: java.net.ConnectException: Connection refused

修复方式:

检查 hdfs-site.xml 中的 dfs.datanode.http.address 是否配置正确:

<property>

<name>dfs.datanode.http.address</name>

<value>0.0.0.0:50075</value>

</property>

确保防火墙已关闭或相应端口已开放:

sudo ufw allow 50010/tcp

sudo ufw allow 50075/tcp

| 问题类型 | 常见原因 | 解决方案 |

|----------|-----------|-----------|

| 网络不通 | IP配置错误、防火墙限制 | 检查 /etc/hosts 和防火墙设置 |

| 配置错误 | XML文件配置错误 | 检查 core-site.xml, hdfs-site.xml 等 |

| Java环境 | JDK未安装或路径错误 | 安装JDK并设置 JAVA_HOME |

| 权限问题 | 目录权限不足 | 设置正确权限并修改配置文件 |

| 启动失败 | 服务未启动或日志异常 | 检查 jps 和日志文件 |

如果你能提供具体的错误信息或日志内容,我可以进一步帮你定位问题。欢迎继续提问!