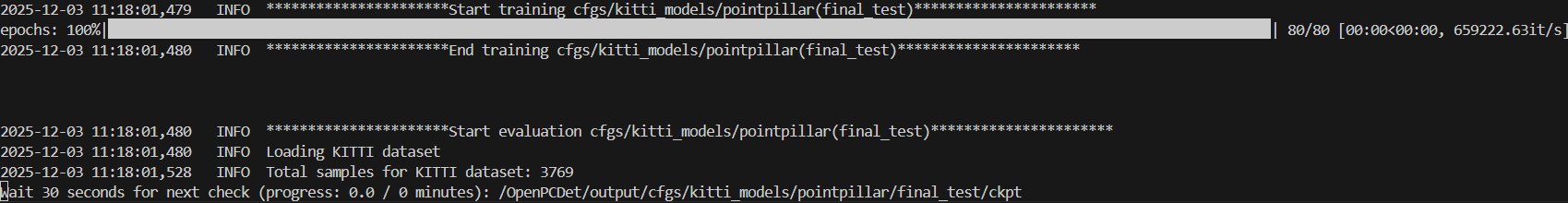

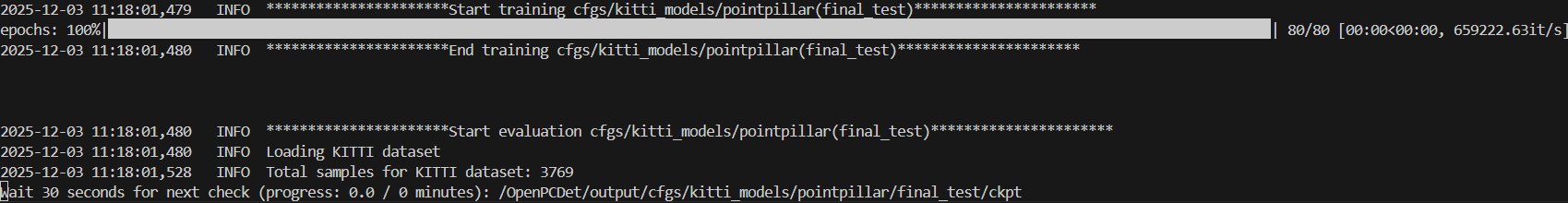

求问:在模型训练过程中,一瞬间直接显示训练完成所有epoch,然后Wait 30 seconds for next check,这是什么原因呢?

晚上好🌙🌙🌙

本答案参考通义千问

在模型训练过程中,如果出现“Wait 30 seconds for next check”的提示,并且看起来像是一瞬间就完成了所有 epoch 的训练,这通常意味着以下几种可能的原因:

训练过程被中断或未正确启动

for epoch in range(num_epochs): 没有被正确调用,或者 model.train() 没有被调用。日志输出被提前终止

print("Epoch 1/10") 被打印,但后续没有执行训练逻辑。训练数据为空或无法读取

DataLoader)返回空的数据,那么训练过程会立即结束,不会进入任何 epoch。训练脚本被意外终止

训练日志显示不准确

检查训练循环是否被正确调用

for epoch in range(...):)确实被执行。for epoch in range(num_epochs):

model.train()

for batch in train_loader:

# 训练逻辑

添加调试输出

print(f"Starting epoch {epoch+1}")

for batch in train_loader:

print("Processing batch...")

验证数据加载器是否正常工作

for batch in train_loader:

print(batch)

break

检查是否有异常或错误

ValueError, IndexError 等)。try-except 块捕获异常并打印详细信息。确保模型和优化器已正确初始化

model 和 optimizer 是否已经定义并传入训练循环。model = MyModel()

optimizer = torch.optim.Adam(model.parameters())

检查训练配置是否合理

num_epochs 是否设置为合理的值(如 10),而不是 0 或负数。num_epochs = 10

使用更详细的日志记录

logging 或 print 输出每一步的状态,确保训练流程清晰可见。import torch

from torch.utils.data import DataLoader, TensorDataset

# 生成示例数据

X = torch.randn(100, 10)

y = torch.randint(0, 2, (100,))

dataset = TensorDataset(X, y)

train_loader = DataLoader(dataset, batch_size=10)

# 定义模型

class MyModel(torch.nn.Module):

def __init__(self):

super().__init__()

self.linear = torch.nn.Linear(10, 2)

def forward(self, x):

return self.linear(x)

model = MyModel()

optimizer = torch.optim.Adam(model.parameters())

criterion = torch.nn.CrossEntropyLoss()

# 设置训练参数

num_epochs = 10

**print(f"Training will run for {num_epochs} epochs.")**

for epoch in range(num_epochs):

**print(f"Starting epoch {epoch + 1}/{num_epochs}")**

model.train()

for batch_idx, (data, target) in enumerate(train_loader):

optimizer.zero_grad()

output = model(data)

loss = criterion(output, target)

loss.backward()

optimizer.step()

**print(f"Batch {batch_idx + 1} completed")**

**print(f"Epoch {epoch + 1} completed")**

print("Training finished.")

如果你能提供具体的代码片段或错误信息,我可以进一步帮助你排查问题。