在写一个爬知乎的爬虫。

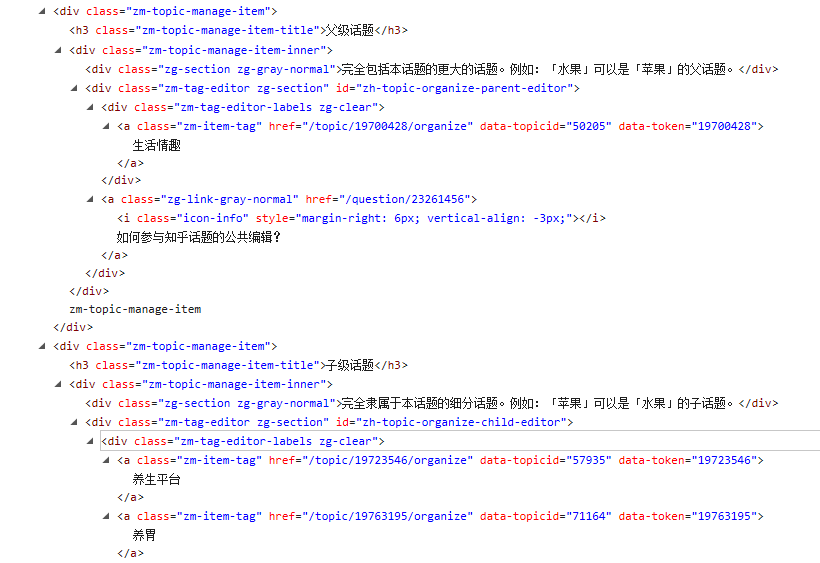

在爬取一个话题的父话题和子话题。

这段代码list = soup.find_all(class_="zm-item-tag")将父话题和子话题全部放到了一个list中,不能区分。

如果设置两个list分别包含子话题和父话题?单独解析父话题和子话题的代码如何写?

如图所示 父话题是 生活情趣

子话题是 养生平台 养胃

求助一个beautifulsoup的问题

- 写回答

- 好问题 0 提建议

- 追加酬金

- 关注问题

- 邀请回答

-

3条回答 默认 最新

threenewbee 2016-02-12 01:27关注

threenewbee 2016-02-12 01:27关注先分别zm-topic-manage-item,判断h3,然后再在内部找zm-item-tag

本回答被题主选为最佳回答 , 对您是否有帮助呢?解决 无用评论 打赏 举报

悬赏问题

- ¥15 mmocr的训练错误,结果全为0

- ¥15 python的qt5界面

- ¥15 无线电能传输系统MATLAB仿真问题

- ¥50 如何用脚本实现输入法的热键设置

- ¥20 我想使用一些网络协议或者部分协议也行,主要想实现类似于traceroute的一定步长内的路由拓扑功能

- ¥30 深度学习,前后端连接

- ¥15 孟德尔随机化结果不一致

- ¥15 apm2.8飞控罗盘bad health,加速度计校准失败

- ¥15 求解O-S方程的特征值问题给出边界层布拉休斯平行流的中性曲线

- ¥15 谁有desed数据集呀