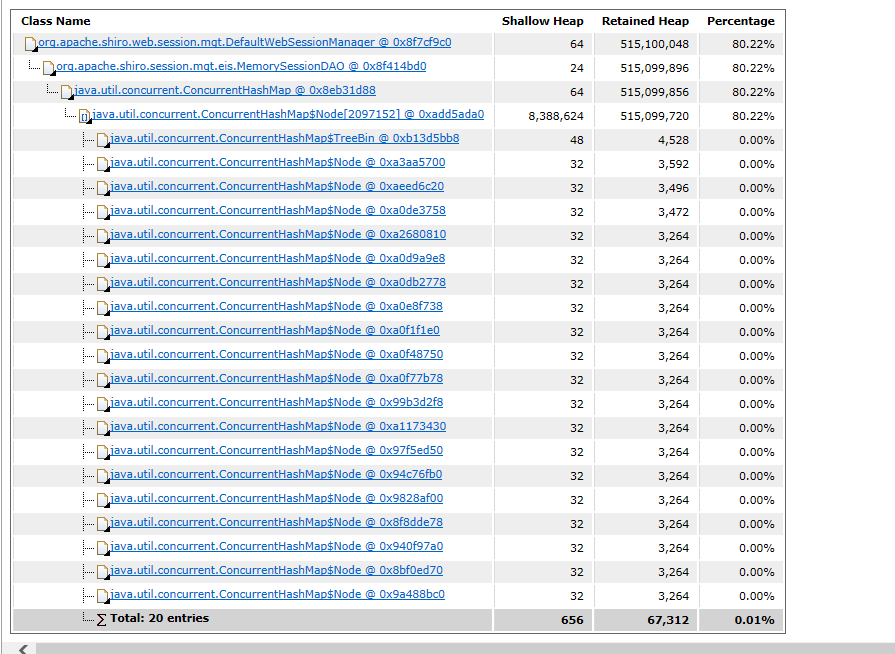

SimpleJdbcInsert insertActor = new SimpleJdbcInsert(jdbcTemplate).withTableName("DATA");

int r_count = dataList.size();

Map[] m_rows = (Map[]) new Map[r_count];

for (int i = 0; i < r_count; i++) {

m_rows[i] = dataList.get(i);

}

int[] idinfos = insertActor.executeBatch(m_rows);

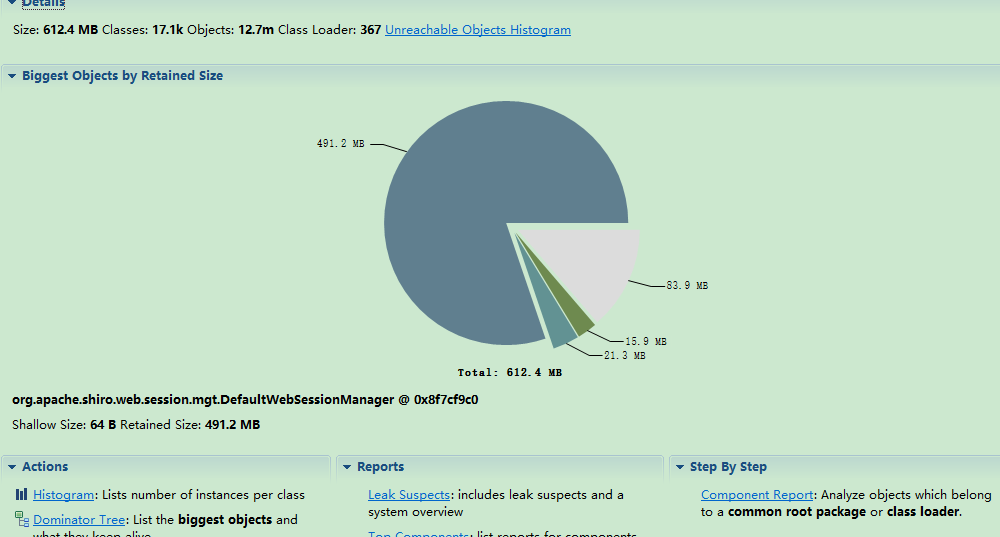

我使用ConcurrentHashMap作为参数传,用于数据的批量插入,使用SimpleJdbcInsert完成批量插入,但是随着插入数据量的增多,内存中的ConcurrentHashMap对象也在不断的增加,一直都没有销毁,这是怎么回事啊???