python小白一枚,刚开始学爬虫,遇到一个动态网页爬取问题,请教各位大神。

需要爬取http://view.news.qq.com/original/intouchtoday/n4083.html

这篇新闻的评论内容,

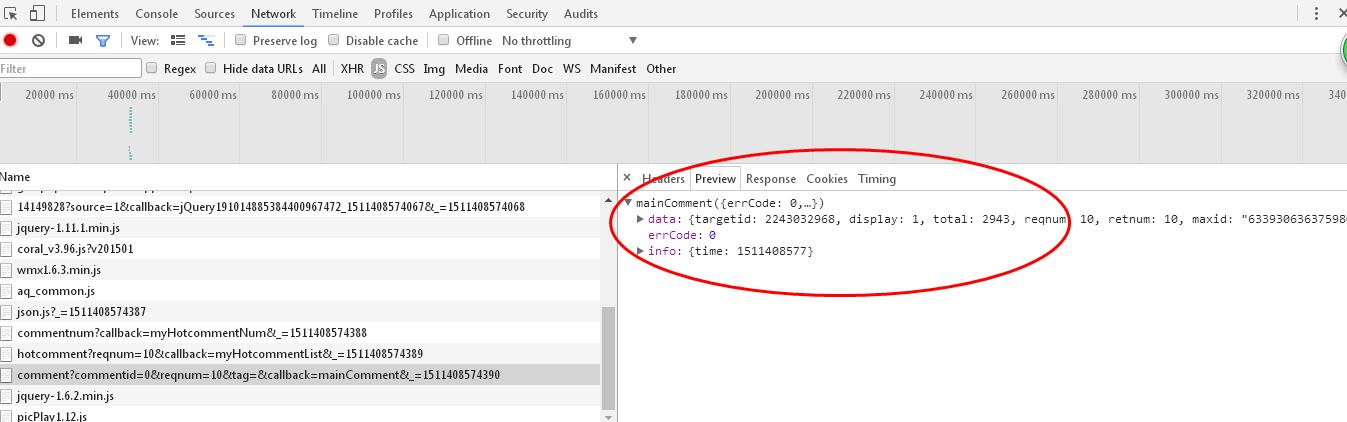

但是在找到了目标request url:

http://coral.qq.com/article/2243032968/comment?commentid=0&reqnum=10&tag=&ca,llback=mainComment&_=1511408574390

,不知道怎么提取里面的评论内容,且里面的内容类似于\u***这样的乱码

python爬虫爬取腾讯新闻评论

- 写回答

- 好问题 0 提建议

- 关注问题

- 邀请回答

-

3条回答 默认 最新

oyljerry 2017-11-23 06:09关注

oyljerry 2017-11-23 06:09关注需要先把内容的mainComment()去掉,它里面是一个json,然后就可以处理,\u是表示unicode的字符。

In [24]: sess = requests.Session() In [24]: sess.headers.update({'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Geck ...: o) Chrome/49.0.2623.221 Safari/537.36 SE 2.X MetaSr 1.0'}) In [24]: res = sess.get("http://coral.qq.com/article/2243032968/comment?commentid=0&reqnum=10&tag=&callback=mainCommen ...: t&_=1511408574390") g = re.match("mainComment\\((.+)\\)", res.text) In [24]: out = json.loads(g.group(1)) In [23]: print(out["data"]["commentid"][0]["content"]) 方便面可以吃不放调料,自己煮,自己搭配本回答被题主选为最佳回答 , 对您是否有帮助呢?解决 无用评论 打赏 举报