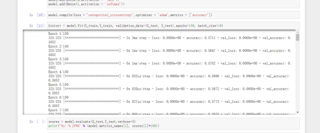

为什么神经网络训练过程中loss和acc趋于不变,而且loss是0.0000e00?求指教

在神经网络训练过程中,如果遇到loss和accuracy(acc)趋于不变,且loss显示为0.0000e00或类似的极小值,这可能是由几个原因造成的:

数值下溢(Underflow):

当loss变得非常小时,可能会因为计算机浮点数的精度限制而变为0.0000e00,这实际上表示loss是一个非常接近于零但并非真正零的值。然而,如果loss持续为这样的值,并且不随训练迭代而变化,这可能不是一个好兆头。

模型已经收敛:

如果模型在训练过程中已经很好地拟合了训练数据,loss可能会变得非常小并且趋于稳定。但是,通常我们会在验证集上观察到类似的loss下降模式,以确保模型没有过拟合。

学习率(Learning Rate)设置不当:

如果学习率设置得过低,模型可能会收敛得非常慢,甚至可能卡在某个局部最小值上。如果学习率设置得过高,模型可能会在训练过程中变得不稳定,甚至导致发散(loss和accuracy都剧烈波动)。

模型结构问题:

模型的结构可能不适合所处理的问题。例如,如果网络层数太少或神经元数量不足,模型可能无法捕获数据的复杂性。

数据集问题:

数据集可能存在问题,如标签错误、数据不平衡或数据质量差。此外,如果训练集和验证集的数据分布存在显著差异,也可能导致模型在验证集上表现不佳。

实现错误:

在代码实现中可能存在错误,例如计算loss或accuracy的函数可能有误,或者数据加载和预处理过程中存在问题。

为了解决这个问题,你可以尝试以下方法:

检查数据集:确保数据集没有问题,并且已经正确地进行了预处理。

调整学习率:尝试使用不同的学习率进行训练,观察loss和accuracy的变化。

使用更复杂的模型结构:尝试增加网络层数或神经元数量,以提高模型的复杂性。

添加正则化:如果怀疑模型过拟合,可以尝试添加正则化项(如L1或L2正则化)来防止过拟合。

检查代码实现:仔细检查计算loss和accuracy的代码,确保没有错误。

使用更先进的优化算法:除了标准的随机梯度下降(SGD)外,还可以尝试使用更先进的优化算法(如Adam、RMSprop等)。

绘制loss和accuracy曲线:在训练过程中绘制loss和accuracy的曲线图,以便更好地了解模型的训练过程。