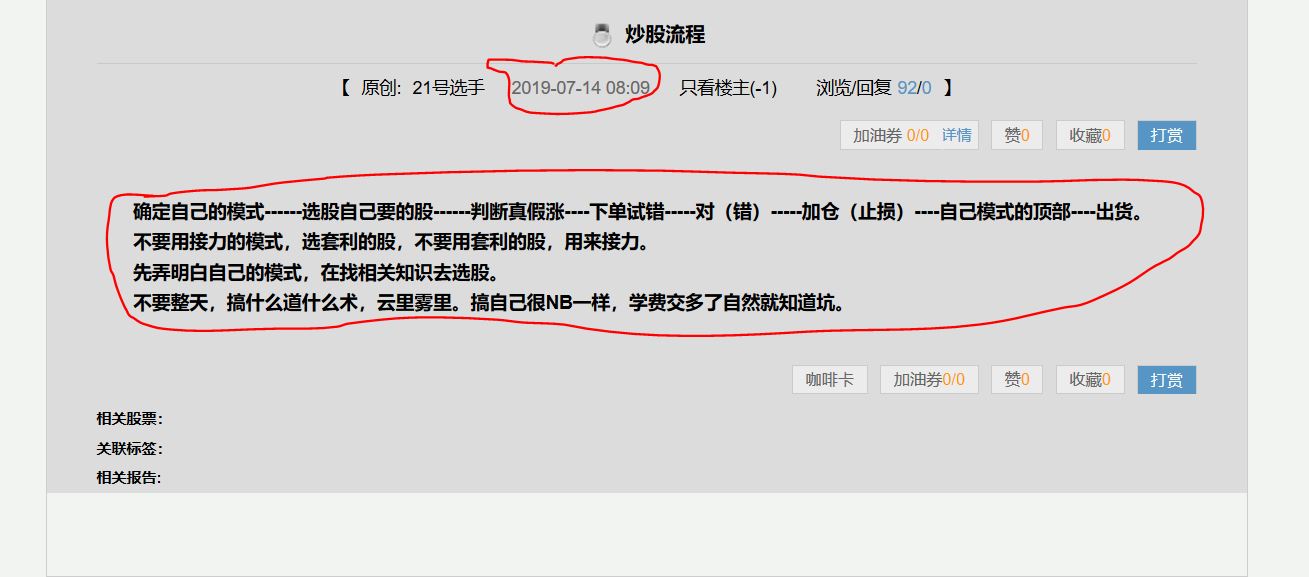

采集网址:https://www.taoguba.com.cn/Article/2523033/1

需采集内容:

使用HtmlAgilityPack

时间xpath:

1、/html/body//span[contains(concat(' ', normalize-space(@class), ' '),' p_tatime ')]

2、//*[@id='new_wrap_container']/DIV[1]/DIV[2]/SPAN[2]

3、//SPAN[@class='p_tatime']

用上述xpath使用谷歌浏览器的xpath helper插件都可以采集到信息,但C#采集到的html都无法采集到时间。

请问哪位可以给个demo,C#实现的,能采集到标红的时间及文字内容