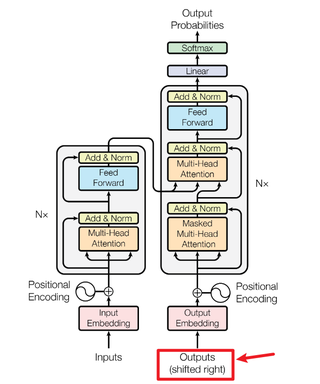

有没有佬知道Transformer中,Decoder最开始接收的输入信息是从哪儿来的?下图红框里那部分的输入(outputs)

关注

关注【以下回答由 GPT 生成】

问题修改后: Transformer中的Decoder的初始输入是从哪里来的?

解答: 在Transformer的Decoder部分,最开始接收的输入信息来自于两个地方:一是来自于Encoder部分的输出信息,二是来自于之前的预测结果。

具体的解决方案如下:

首先,我们需要明确Transformer的整体架构。Transformer由Encoder和Decoder两个部分组成,其中Encoder负责将输入序列进行编码,Decoder负责将编码后的信息进行解码和生成输出序列。

在Encoder部分,输入的序列经过一个Embedding层进行嵌入操作,然后再经过一系列的Multi-Head Attention和Feed-Forward Network层进行处理。最后,Encoder的输出结果将作为Decoder的初始输入。

在Decoder部分,初始输入首先经过一个Embedding层进行嵌入操作,然后再与Encoder的输出结果进行连接操作。在这里需要使用到一个技巧,即将Encoder的输出结果进行shift right操作,即将每个位置的值向右移动一个位置,这是为了确保在Decoder的每一个位置,都只能看到它之前的位置的信息。

接下来,Decoder的输入结果将经过一系列的Multi-Head Attention和Feed-Forward Network层进行处理,最终输出结果作为下一个时刻的输入。

以下是一个简化的代码示例,展示了如何构建Transformer中的Decoder,并展示了初始输入的来源和处理过程:

import torch

import torch.nn as nn

class TransformerDecoder(nn.Module):

def __init__(self):

super(TransformerDecoder, self).__init__()

# 初始化相关操作,省略...

def forward(self, encoder_outputs, decoder_inputs):

# 对encoder_outputs进行shift right操作

shifted_encoder_outputs = torch.cat([torch.zeros_like(encoder_outputs[:, :1]), encoder_outputs[:, :-1]], dim=1)

# 将shifted_encoder_outputs和decoder_inputs进行连接

inputs = torch.cat([shifted_encoder_outputs, decoder_inputs], dim=2)

# 处理输入序列

# 省略...

# 返回处理后的结果作为下一个时刻的输入

return outputs

需要注意的是,上述代码示例是一个简化的版本,相关细节部分可能被省略了。在实际应用中,通常还会涉及到更多的细节处理和参数调整。

希望以上解答能够帮助到您,如果有任何疑问,请随时追问。

【相关推荐】