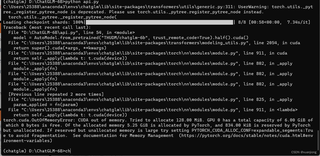

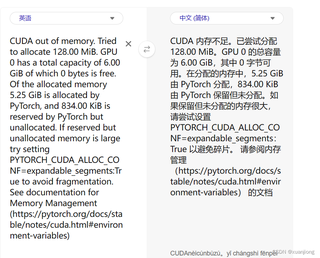

错误中的具体内容为下图

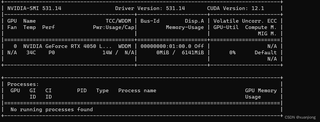

使用nvidia-smi查看gpu也没有占用,如图

这种情况我应该如何清除所占用的部分

关注

关注引自免费微信小程序:皆我百晓生

从您描述的情况来看,您在使用PyTorch时遇到了模型下载错误,并且发现GPU显存并未占用。为了解决问题并清理可能存在的内存占用,您可以尝试以下方法:

重启Kernel或Jupyter Notebook

关闭当前会话中的所有Tensor

.detach()和.cpu()将所有不在使用的Tensor移动到CPU,并释放其在GPU上的显存。# 假设model是您的模型,且它可能包含未释放的张量

for param in model.parameters():

param.grad = None # 清除梯度(如果存在)

del model # 删除模型引用

torch.cuda.empty_cache() # 清空CUDA缓存

检查后台进程

nvidia-smi -l 1 # 每秒刷新一次,实时监控GPU使用情况

ps -aux | grep python # 查看Python后台进程

设置环境变量

import torch

torch.cuda.reset_max_memory_allocated()

卸载不需要的库或模块

重新启动计算机

请注意,实际给出的代码片段仅作为示例,并非针对具体错误进行的修复。对于具体的报错内容(即{img1}、{img2}和{img3}所示内容),请提供详细信息以便我能针对性地给出解决方案。此外,若问题在于模型下载错误而非显存占用,则需要关注网络连接、存储空间以及模型源地址的有效性。