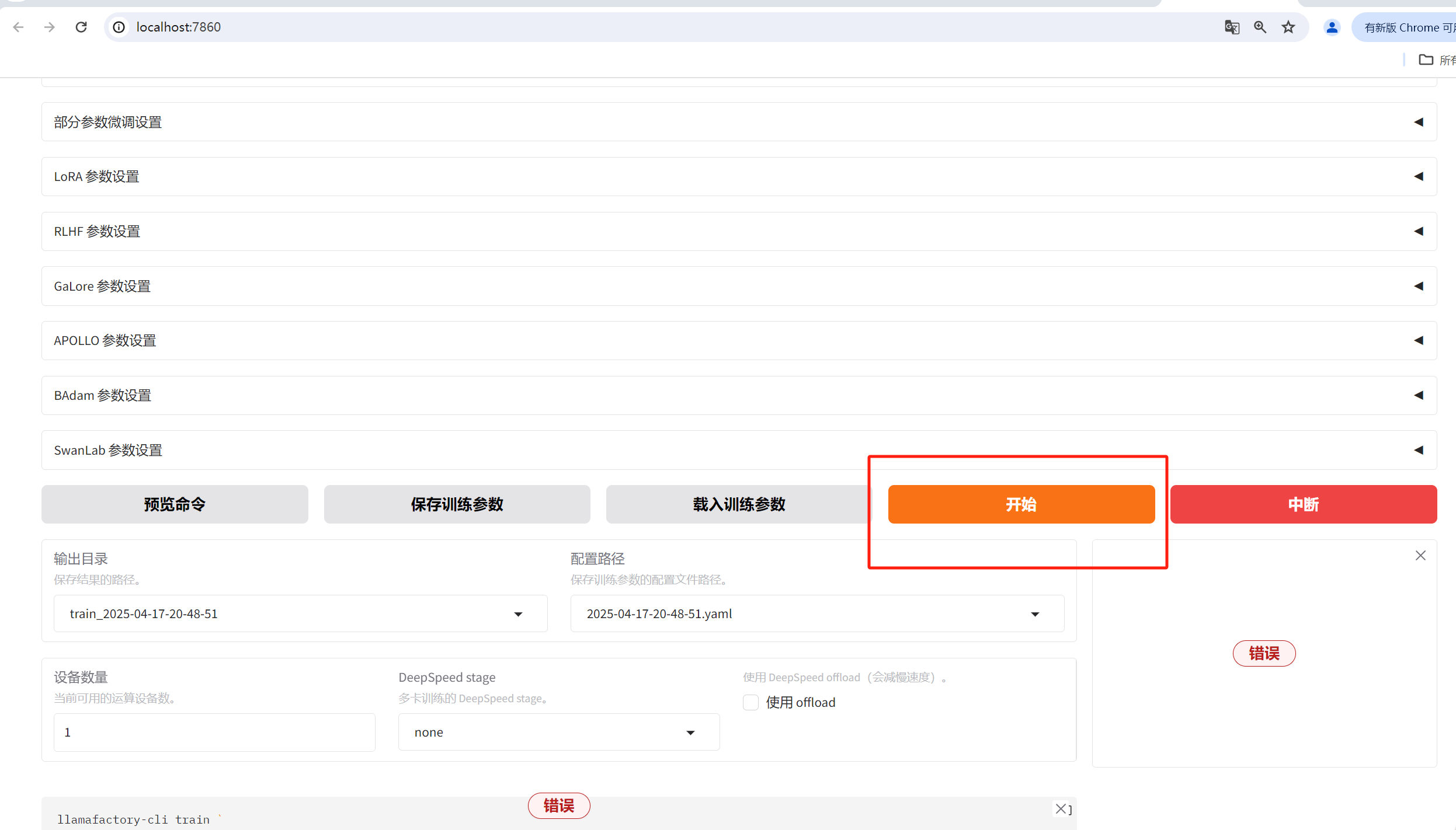

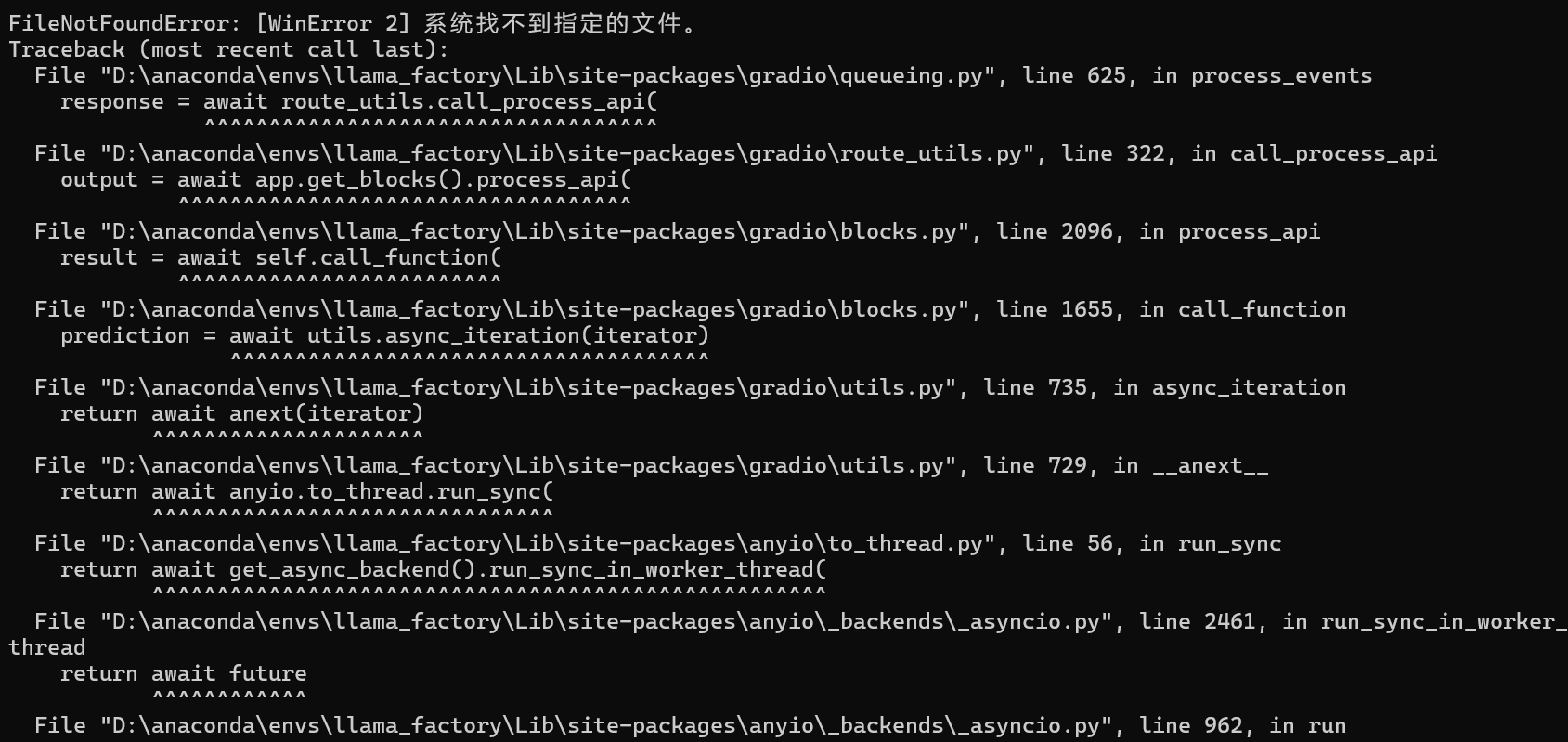

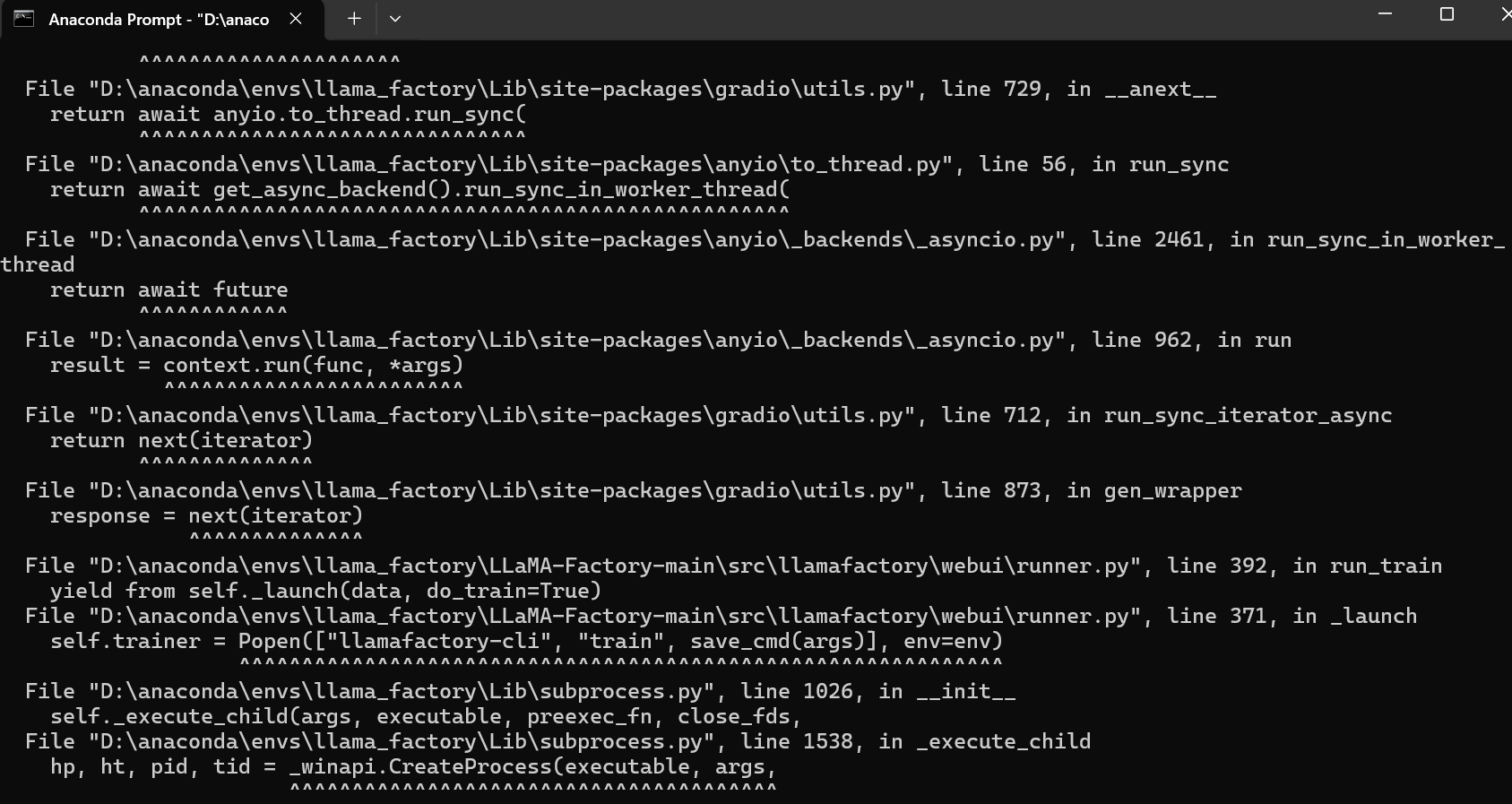

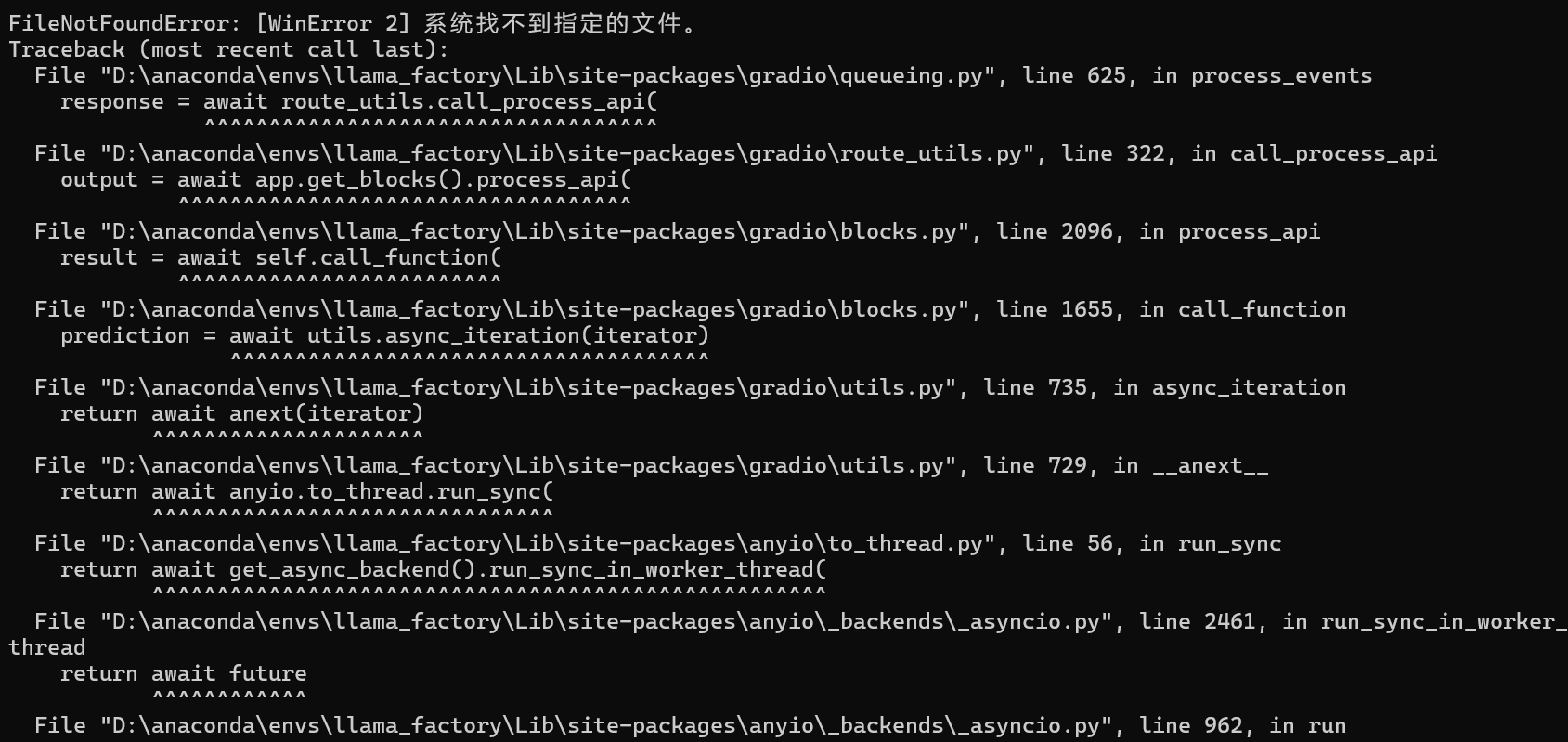

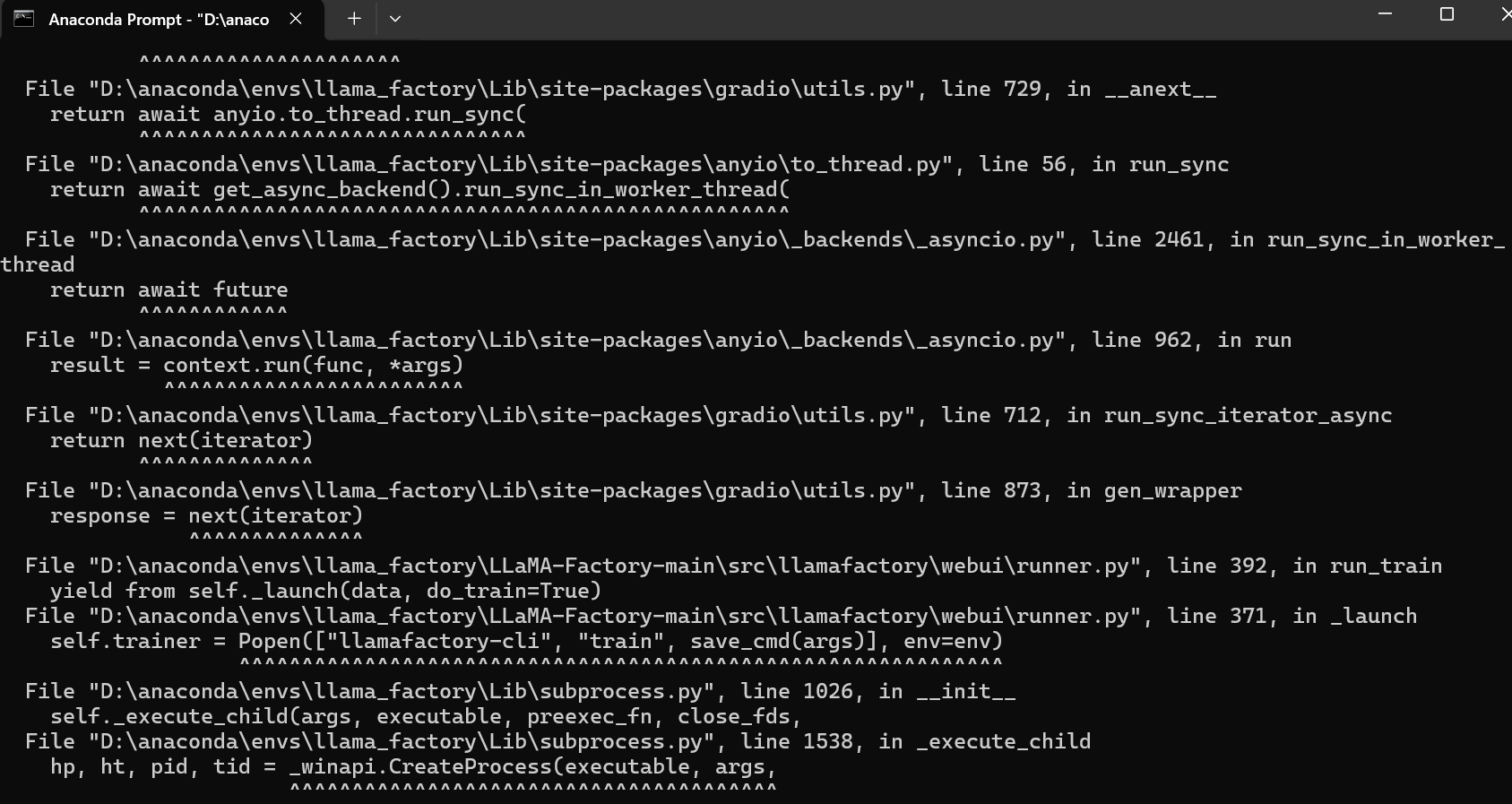

系统为windows11,LLama-Factory依赖正常安装,torch.cuda.is_available()测试结果正常,进入webui中可以与大模型chat,数据集可预览,但点击开始后报错文件无法找到,恳求定位是少安装什么文件或者怎么解决QAQ(有偿):

系统为windows11,LLama-Factory依赖正常安装,torch.cuda.is_available()测试结果正常,进入webui中可以与大模型chat,数据集可预览,但点击开始后报错文件无法找到,恳求定位是少安装什么文件或者怎么解决QAQ(有偿):

关注

关注让【宝码香车】来帮你解答,本回答参考DeepSeek编写,并整理提供。

如果还有疑问可以点击头像关注私信或评论。如果答案让您满意,请采纳、点赞、关注,非常感谢!

根据您提供的错误信息和问题描述,这是一个典型的文件路径或依赖配置问题。以下是系统化的解决方案:

从报错信息看,主要问题是:

# 检查环境变量(在终端执行)

echo $HF_HOME

echo $TRANSFORMERS_CACHE

如果未设置,建议在~/.bashrc中添加:

export HF_HOME=/path/to/your/cache

export TRANSFORMERS_CACHE=$HF_HOME

from datasets import load_dataset

from transformers import AutoModelForCausalLM

# 测试数据集加载

try:

dataset = load_dataset("您的数据集名称")

except Exception as e:

print(f"数据集加载错误: {e}")

# 测试模型加载

try:

model = AutoModelForCausalLM.from_pretrained("您的模型名称")

except Exception as e:

print(f"模型加载错误: {e}")

# 检查缓存目录权限

ls -ld $HF_HOME

# 建议设置(如果权限不足)

chmod -R 755 $HF_HOME

# 清理并重新安装

pip uninstall -y transformers datasets

pip install --upgrade transformers datasets

# 重置缓存(谨慎操作)

rm -rf ~/.cache/huggingface/

数据集验证:

dataset_info.json是否存在模型验证:

from transformers import AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("您的模型名称", trust_remote_code=True)

WebUI特定检查:

config.yaml中的路径配置data/目录存在且包含有效数据集如需进一步协助,可通过以下方式联系:

trainer.log完整日志建议先尝试上述方案,多数情况下通过正确设置缓存路径和文件权限即可解决。如果问题依旧,请提供完整的错误日志(特别是堆栈跟踪部分)。