阿里嘎多学长整理AIGC生成,因移动端显示问题导致当前答案未能完全显示,请使用PC端查看更加详细的解答过程

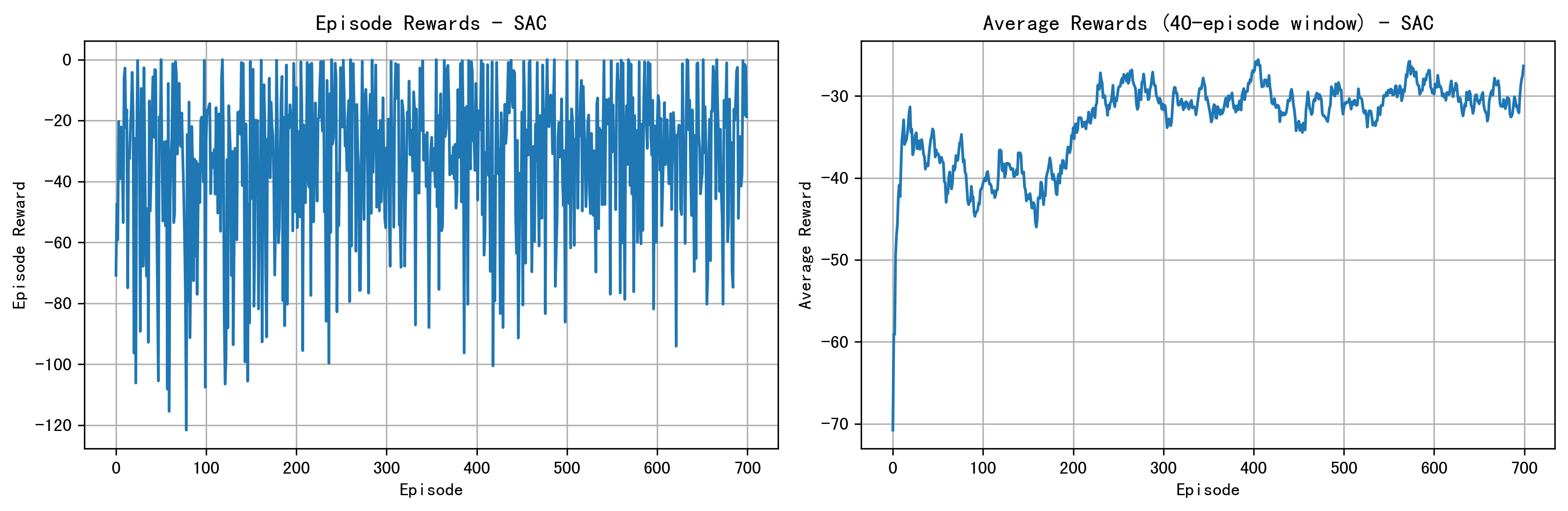

收敛判断问题

你遇到的问题是,使用SAC算法后,收敛到的数值不在目标控制的范围内。这个问题可能有几个原因:

- 目标函数设计不当:SAC算法使用的是最大化累积回报的目标函数。如果你的目标函数设计不当,可能导致算法优化的结果不符合你的期望。

- 奖励函数设计不当:奖励函数是SAC算法的关键组成部分。如果奖励函数设计不当,可能导致算法优化的结果不符合你的期望。

- 算法参数调整不当:SAC算法有很多参数需要调整,例如学习率、批次大小、actor和critic网络的结构等。如果这些参数调整不当,可能导致算法收敛到不符合期望的结果。

解决方案

- 检查目标函数和奖励函数:检查你的目标函数和奖励函数是否设计得合理。如果需要,进行调整。

- 调整算法参数:调整SAC算法的参数,例如学习率、批次大小、actor和critic网络的结构等。

- 使用不同的收敛指标:使用不同的收敛指标,例如平均绝对误差(MAE)、平均平方误差(MSE)等,来评估算法的收敛情况。

- 使用不同的算法:如果上述方法不起作用,可以尝试使用不同的算法,例如DDPG+PI控制算法。

核心代码

import torch

import torch.nn as nn

import torch.optim as optim

# 定义SAC算法

class SAC(nn.Module):

def __init__(self, state_dim, action_dim):

super(SAC, self).__init__()

self.actor = nn.Sequential(

nn.Linear(state_dim, 64),

nn.ReLU(),

nn.Linear(64, action_dim)

)

self.critic = nn.Sequential(

nn.Linear(state_dim + action_dim, 64),

nn.ReLU(),

nn.Linear(64, 1)

)

def forward(self, state):

action = self.actor(state)

value = self.critic(torch.cat((state, action), dim=1))

return action, value

# 定义目标函数

def compute_reward(state, action, next_state, reward):

return reward + 0.99 * torch.max(self.critic(torch.cat((next_state, action), dim=1)))

# 定义奖励函数

def compute_reward(state, action):

return -torch.norm(action)

# 定义训练过程

def train(model, optimizer, batch_size):

# ...

# ...

# ...

# 训练模型

model = SAC(state_dim, action_dim)

optimizer = optim.Adam(model.parameters(), lr=0.001)

train(model, optimizer, batch_size)

注意

上述代码仅供参考,具体实现可能需要根据你的项目需求进行调整。