让【宝码香车】来帮您解答,本回答参考DeepSeek编写,并整理提供。

如果答案让您满意,请采纳、点赞、关注,非常感谢!

.

每日一句正能量,让它带给您好心情:努力不是为了让别人看见,而是为了对得起自己。

.

您好!您提出的问题非常典型,是很多机器学习实践者,尤其是在处理回归问题时都会遇到的困惑。您的思路清晰,观察也很仔细。我们来逐一分析和解答您的问题。

1. 评价指标是否需要在原始尺度上计算?

核心答案:是的,强烈建议在原始尺度上计算最终的评价指标。

您观察到的现象——“归一化尺度上指标很好,反归一化后MSE变大,但R²变化不大”——是完全正常且符合理论的。

- 为什么MSE会剧增?

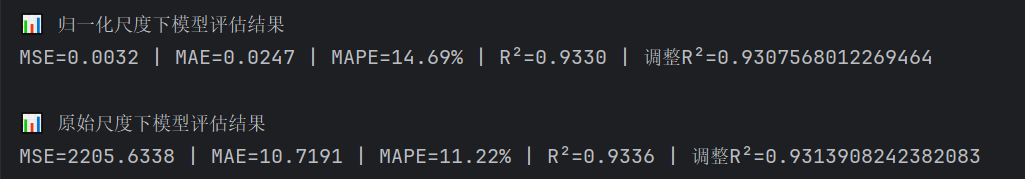

MSE(均方误差)是尺度相关的。当您的数据被归一化到[0,1]或[-1,1]附近时,预测值和真实值之间的差值本身就很小,计算出的MSE自然也很小(比如0.0032)。当您将预测值反归一化回原始尺度(比如房屋价格、人口数量等),这个差值也被同比例放大,所以MSE会急剧增大到原始数据的量级(比如2205.6338)。这并不意味着您的模型突然变差了,只是评价的“标尺”变了。

- 为什么R²变化不大?

R²(决定系数)是一个比例指标,它衡量的是模型对目标变量方差的解释比例。它的计算公式是:

R² = 1 - (SS_residual / SS_total)

其中,SS_residual是残差平方和(与MSE同向变化),SS_total是总平方和(数据本身的方差)。当您进行反归一化时,分子和分母会被同比例放大,所以它们的比值基本保持不变。因此,R²在归一化和原始尺度下应该是非常接近的,这正好验证了您的模型解释方差的能力是稳定的。

结论: 您应该使用反归一化后的数据来计算MSE、MAE等绝对误差指标,因为它们具有实际的物理意义(比如,预测房价平均误差是10万元)。而R²这种相对指标,无论在哪个尺度看,其值都是可靠的。您在原始尺度下评估是完全正确的做法。

2. 数值型和类别型数据混合,能否训练一个BP模型?

核心答案:可以,但您当前的处理方式(仅Label Encoding)可能不是最优的,存在潜在风险。

您将类别型特征进行Label Encoding后与数值型特征一起送入神经网络,理论上是可行的,因为神经网络最终处理的都是数值。

但是,这里有一个关键问题:

Label Encoding会给类别赋予一个无序的数值(比如城市:北京=0,上海=1,广州=2)。这会暗示模型这些类别之间存在一个“顺序”或“大小”关系(比如广州 > 上海 > 北京),而实际上它们是没有这种数学关系的。这可能会误导模型。

更佳实践:对类别型特征使用 One-Hot 编码

One-Hot编码可以避免引入虚假的顺序关系。例如,对于“城市”这个特征:

- 北京: [1, 0, 0]

- 上海: [0, 1, 0]

- 广州: [0, 0, 1]

这样,每个类别都被表示为一个独立的、平等的二进制特征。

您的数据处理流程建议:

# 假设使用 pandas 和 sklearn

import pandas as pd

from sklearn.preprocessing import StandardScaler, OneHotEncoder

from sklearn.compose import ColumnTransformer

from sklearn.pipeline import Pipeline

# 1. 假设您的数据框是 df,前10列是数值特征,后7列是类别特征

numeric_features = ['num1', 'num2', ..., 'num10'] # 数值型特征列名

categorical_features = ['cat1', 'cat2', ..., 'cat7'] # 类别型特征列名

# 2. 创建一个列转换器

preprocessor = ColumnTransformer(

transformers=[

('num', StandardScaler(), numeric_features), # 对数值型特征做标准化

('cat', OneHotEncoder(drop='first'), categorical_features) # 对类别型特征做One-Hot编码,drop='first'为避免多重共线性

])

# 3. 将预处理器和模型组合成管道

# 这样在训练时,preprocessor会自动拟合并转换数据,在预测时也会自动应用相同的转换

model = Pipeline(steps=[

('preprocessor', preprocessor),

('regressor', YourNeuralNetwork()) # 这里替换成您自己的BP神经网络模型

])

# 4. 训练和预测

model.fit(X_train, y_train)

predictions = model.predict(X_test)

# 注意:如果您的输出y也归一化了,这里的predictions也是归一化后的值,需要反归一化

3. 是否需要为20个输出使用多任务学习?

核心答案:不一定,一个多输出模型通常是首选,但值得尝试多任务学习。

您的问题是一个多输出回归问题。有几种处理方式:

- 单一模型,多输出(您当前的做法):

- 在输出层设置20个神经元,每个对应一个目标变量。

- 优点: 简单直接,模型共享底层特征,如果输出变量之间相关性很强,可以相互促进。

- 缺点: 如果这20个参数物理意义和量纲差异巨大,且彼此无关,一个统一的损失函数(如MSE)可能难以同时优化所有目标。

- 多任务学习:

- 为不同的输出组(或者甚至每个输出)设计不同的输出“头”(即不同的网络分支)。

- 优点: 可以为不同任务设计更合适的损失函数和权重,模型可以学习到更通用的特征表示,可能提升泛化能力。

- 缺点: 模型结构更复杂,训练和调参更困难。

建议:

- 首先,坚持使用您现在的多输出单一模型。这是最主流和高效的基准方法。

- 如果您发现模型对某几个输出的预测始终很差,而其他输出很好,可以考虑将它们分组。例如,如果20个参数可以自然地分为“力学性能组”、“热学性能组”等,可以为每组建立一个输出头,这就是多任务学习的思路。

- 在最终决定前,确保您的数据预处理(特别是对类别特征和数值特征的区分处理)已经做到位,因为这往往是影响模型性能的关键。

总结与最终建议

- 评估尺度: 坚持在原始数据尺度上报告MSE、MAE等指标,R²在两个尺度下都是可靠的。

- 数据预处理: 将类别型特征的编码方式从 Label Encoding 改为 One-Hot Encoding。数值型特征继续使用归一化/标准化。

- 模型结构: 目前使用单一BP神经网络处理多输出是合理的。除非有明确证据表明输出变量可分组成不同任务,否则无需引入复杂的多任务学习结构。

- 下一步调试: 在改进了数据预处理后,如果性能仍有提升空间,可以考虑调整网络结构(如层数、神经元数量)、尝试不同的激活函数、使用更先进的优化器或学习率调度策略等。

希望这些详细的解答能帮助您理清思路,继续优化您的模型!祝您成功!