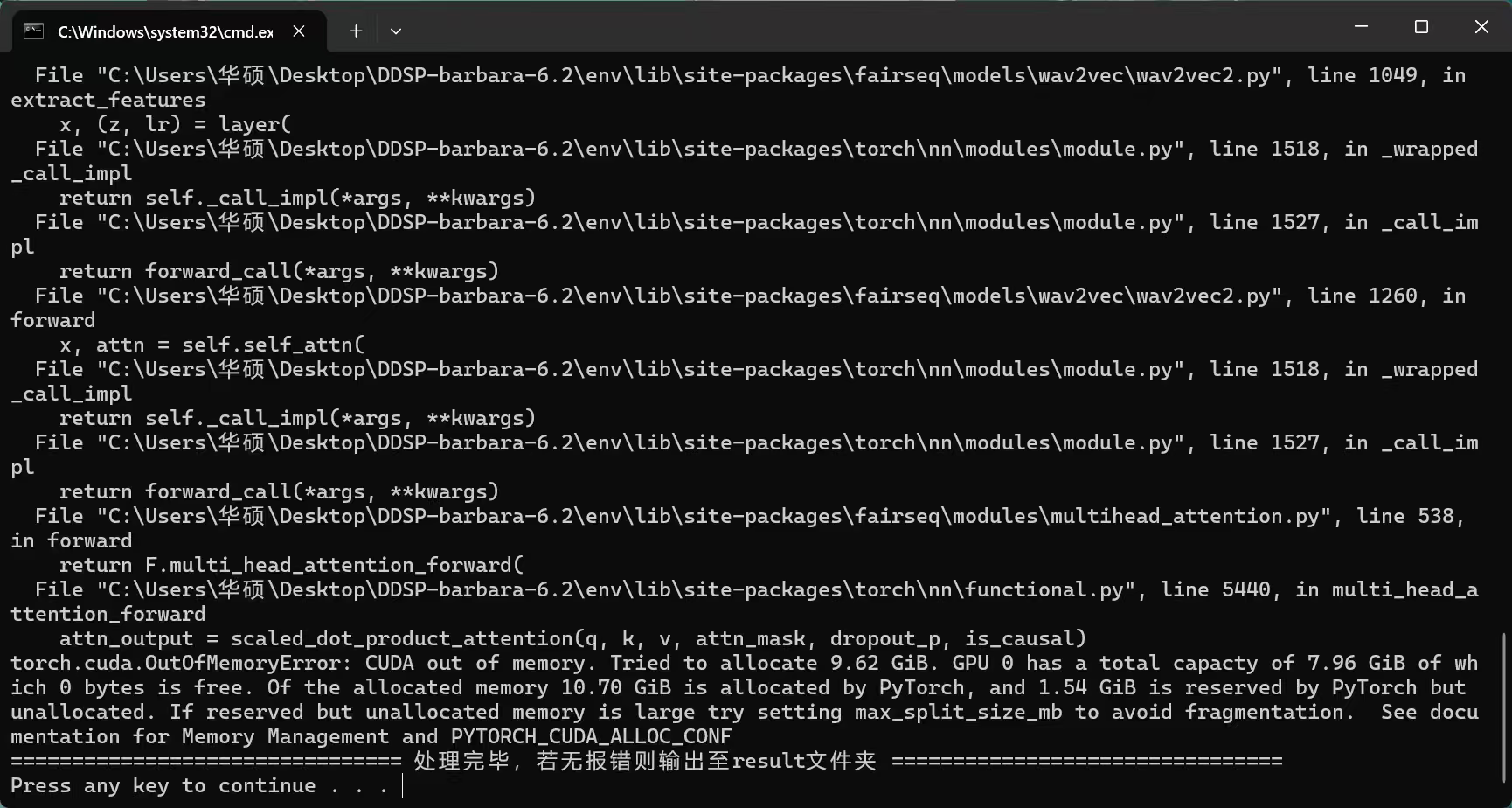

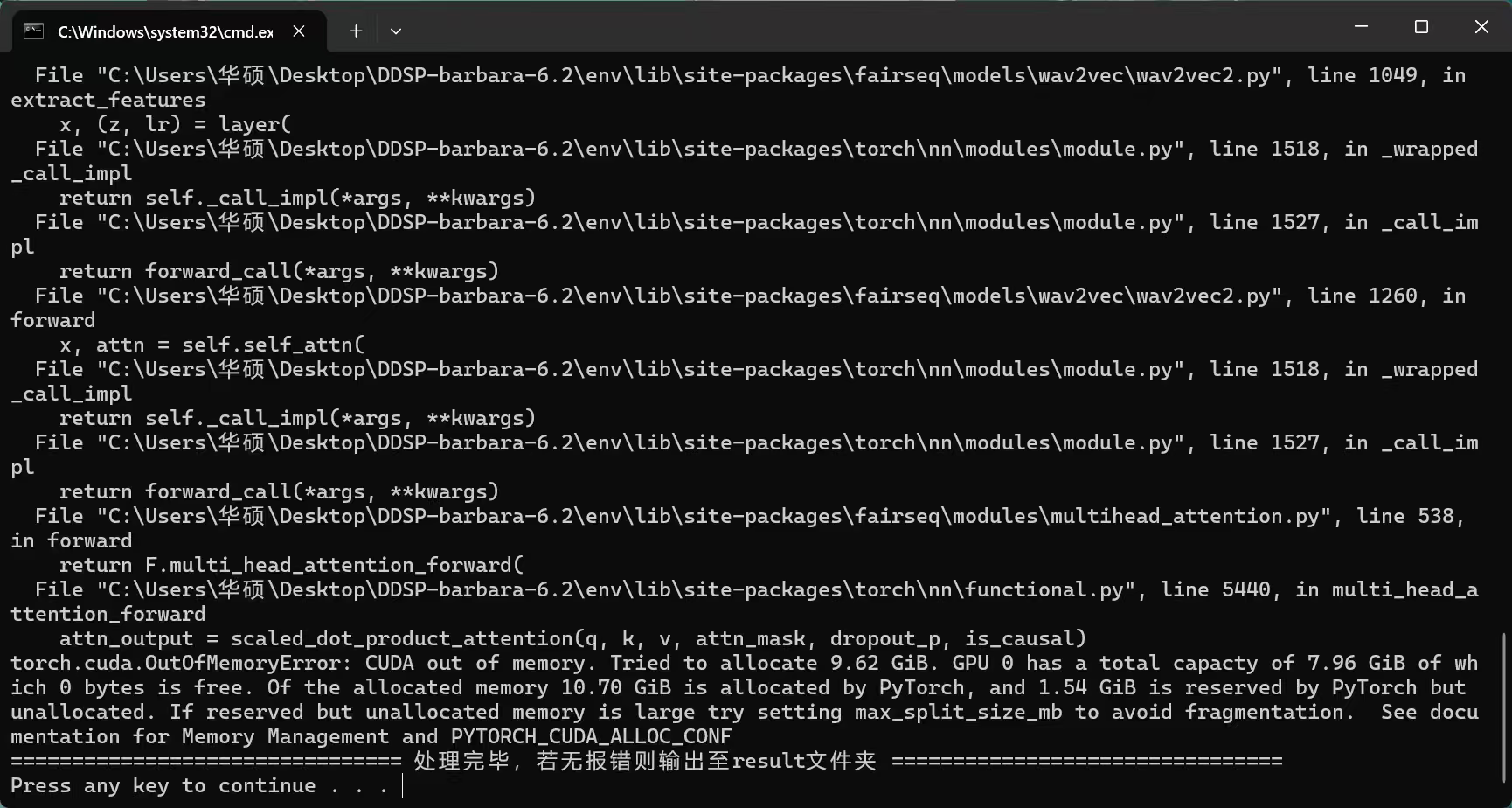

OutOfMemoryError: CUDA out of memory.DDSP运行报错,cuda11.8,求提供解决方案

下午好🌅🌅🌅

本答案参考通义千问

在使用 DDSP(Differentiable Digital Signal Processing) 框架时,如果遇到以下错误:

OutOfMemoryError: CUDA out of memory.

这通常表示你的 GPU 显存不足,无法加载模型或处理数据。以下是详细的解决方案和优化建议。

ddsp 中的 ddsp_core 或 ddsp_spectral_ops 模块可能占用较多显存。这是最直接有效的办法。

# 示例:将 batch_size 从 32 改为 16

train_loader = DataLoader(dataset, batch_size=16, shuffle=True)

重点: 批量大小越小,占用的显存就越少。

如果 DDSP 的模型过大,可以尝试简化模型结构。

# 修改模型配置,例如减少网络层数或通道数

model = DDSPModel(

num_layers=2, # 减少层数

hidden_units=128 # 减少隐藏单元数

)

重点: 简化模型可以显著减少显存占用。

PyTorch 提供了 torch.cuda.amp 模块来实现混合精度训练,可以有效节省显存。

from torch.cuda.amp import autocast, GradScaler

scaler = GradScaler()

for data in train_loader:

inputs, targets = data

with autocast():

outputs = model(inputs)

loss = criterion(outputs, targets)

scaler.scale(loss).backward()

scaler.step(optimizer)

scaler.update()

重点: 使用 FP16 可以将显存需求降低约 50%。

确保每次迭代后释放不必要的张量。

import torch

# 在每次迭代后手动释放缓存

torch.cuda.empty_cache()

重点: 在调试阶段可频繁调用此函数,但注意不要过度使用,影响性能。

确保你使用的 PyTorch 版本与 CUDA 11.8 兼容。

# 查看当前 PyTorch 版本

pip show torch

建议安装与 CUDA 11.8 兼容的 PyTorch 版本:

pip install torch==1.13.1+cu118 torchvision==0.14.1+cu118 --extra-index-url https://download.pytorch.org/whl/cu118

重点: 不兼容的版本可能导致显存异常或崩溃。

如果只是测试或调试,可以暂时将模型移动到 CPU 上运行。

device = torch.device("cpu")

model.to(device)

# 数据也需移动到 CPU

inputs = inputs.to(device)

targets = targets.to(device)

重点: 虽然速度慢,但能避免显存溢出。

通过多次小 batch 计算梯度,再统一更新参数,可以节省显存。

accumulation_steps = 4

optimizer.zero_grad()

for i, data in enumerate(train_loader):

inputs, targets = data

outputs = model(inputs)

loss = criterion(outputs, targets)

loss.backward()

if (i + 1) % accumulation_steps == 0:

optimizer.step()

optimizer.zero_grad()

重点: 梯度累积可以在不增加 batch size 的情况下模拟更大的 batch。

import torch

from torch.utils.data import DataLoader, Dataset

from torch.cuda.amp import autocast, GradScaler

# 自定义数据集

class MyDataset(Dataset):

def __len__(self):

return 1000

def __getitem__(self, idx):

# 返回输入和目标数据

return torch.randn(1, 16000), torch.randn(1, 16000)

# 定义模型(简化版)

class DDSPModel(torch.nn.Module):

def __init__(self):

super().__init__()

self.layers = torch.nn.Sequential(

torch.nn.Linear(16000, 1024),

torch.nn.ReLU(),

torch.nn.Linear(1024, 16000)

)

def forward(self, x):

return self.layers(x)

# 初始化模型

model = DDSPModel().to('cuda')

criterion = torch.nn.MSELoss()

optimizer = torch.optim.Adam(model.parameters(), lr=1e-4)

scaler = GradScaler()

# 数据加载器

dataset = MyDataset()

train_loader = DataLoader(dataset, batch_size=16, shuffle=True)

# 训练循环

for epoch in range(10):

for data in train_loader:

inputs, targets = data

inputs, targets = inputs.to('cuda'), targets.to('cuda')

with autocast():

outputs = model(inputs)

loss = criterion(outputs, targets)

scaler.scale(loss).backward()

scaler.step(optimizer)

scaler.update()

optimizer.zero_grad()

torch.cuda.empty_cache() # 清理缓存

| 项目 | 说明 |

|------|------|

| 使用更小的数据长度 | 如将音频采样率从 44100 降到 16000 |

| 禁用不必要的模块 | 如关闭 spectral_ops 或 rnn 模块 |

| 使用 torch.compile() | 优化模型执行效率 |

| 解决方案 | 作用 | |----------|------| | 降低 batch size | 最直接有效 | | 使用 FP16 混合精度 | 显存节省约 50% | | 检查 PyTorch 和 CUDA 版本 | 避免兼容性问题 | | 使用梯度累积 | 模拟大 batch 大小 | | 清理缓存 | 释放无用显存 |

如果你能提供具体的代码片段或错误日志,我可以进一步帮助你定位问题!