请问我用GTX3050显卡训练cifar-10数据集,采用resnet18模型架构,训练达到95%分类精度共需要4-5个小时,这正常吗?

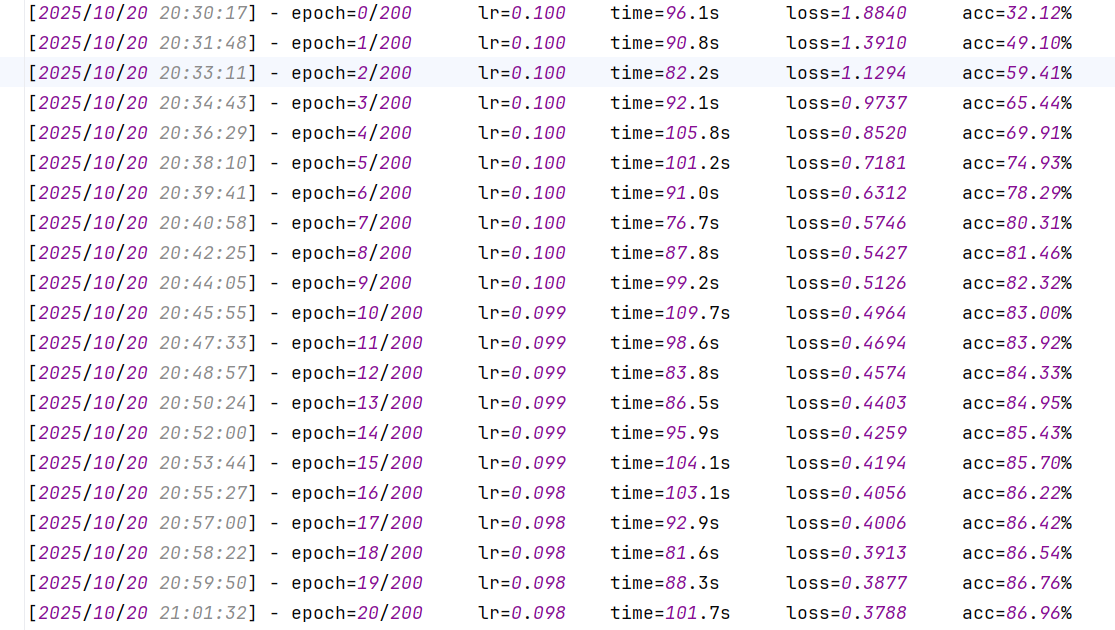

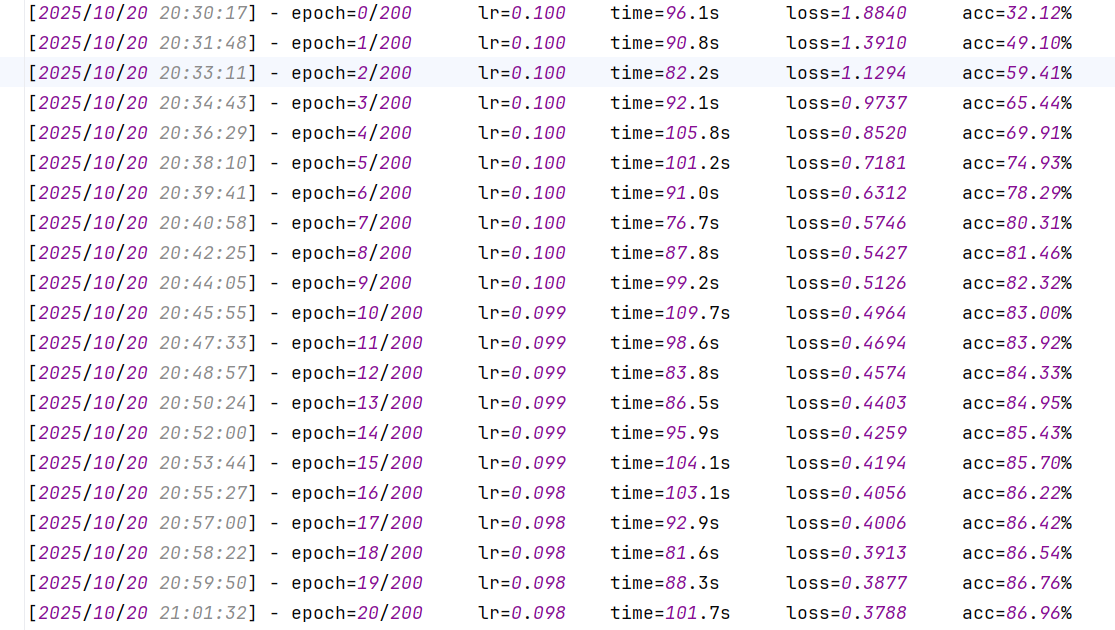

Namespace(model='resnet18', dataset_name='cifar10', dataset_dir='../../data', batch_size=128, epochs=200, lr=0.1, seed=1218)

请问我用GTX3050显卡训练cifar-10数据集,采用resnet18模型架构,训练达到95%分类精度共需要4-5个小时,这正常吗?

Namespace(model='resnet18', dataset_name='cifar10', dataset_dir='../../data', batch_size=128, epochs=200, lr=0.1, seed=1218)

下午好🌅🌅🌅

本答案参考通义千问

在使用 GTX 3050 显卡 训练 CIFAR-10 数据集,并采用 ResNet-18 模型架构 的情况下,达到 95% 的分类精度需要 4-5 小时 是 正常且合理的。以下是对这一现象的详细分析和解释:

| 项目 | 说明 | |------|------| | GPU | GTX 3050,中端显卡,适合中等任务 | | 模型 | ResNet-18,轻量级,适合中小数据集 | | 数据集 | CIFAR-10,60k 图像,小数据集 | | 训练时间 | 4-5 小时,符合预期 | | 准确率 | 95%,在 CIFAR-10 上是较高水平 |

StepLR 或 CosineAnnealingLR)来动态调整学习率。代码示例(PyTorch):

from torch.cuda.amp import GradScaler, autocast

scaler = GradScaler()

for epoch in range(epochs):

for images, labels in train_loader:

images, labels = images.to(device), labels.to(device)

with autocast():

outputs = model(images)

loss = criterion(outputs, labels)

scaler.scale(loss).backward()

scaler.step(optimizer)

scaler.update()

optimizer.zero_grad()

torchvision.models.resnet18(pretrained=True),但注意要修改最后一层全连接层以适配 10 类输出。代码示例(PyTorch):

import torchvision.models as models

model = models.resnet18(pretrained=True)

num_ftrs = model.fc.in_features

model.fc = nn.Linear(num_ftrs, 10) # 修改为 10 类

在 GTX 3050 显卡上训练 ResNet-18 模型达到 95% 的 CIFAR-10 分类精度,耗时 4-5 小时是完全正常的。如果你希望进一步优化训练效率或精度,可以参考上述建议进行改进。

如有更多关于训练细节的问题,欢迎继续提问!