帮忙看看评估一下有没有过拟合啥的问题,感觉收敛非常抖动,不知道啥问题,但是指标出来都很好,包括测试集

晚上好🌙🌙🌙

本答案参考通义千问

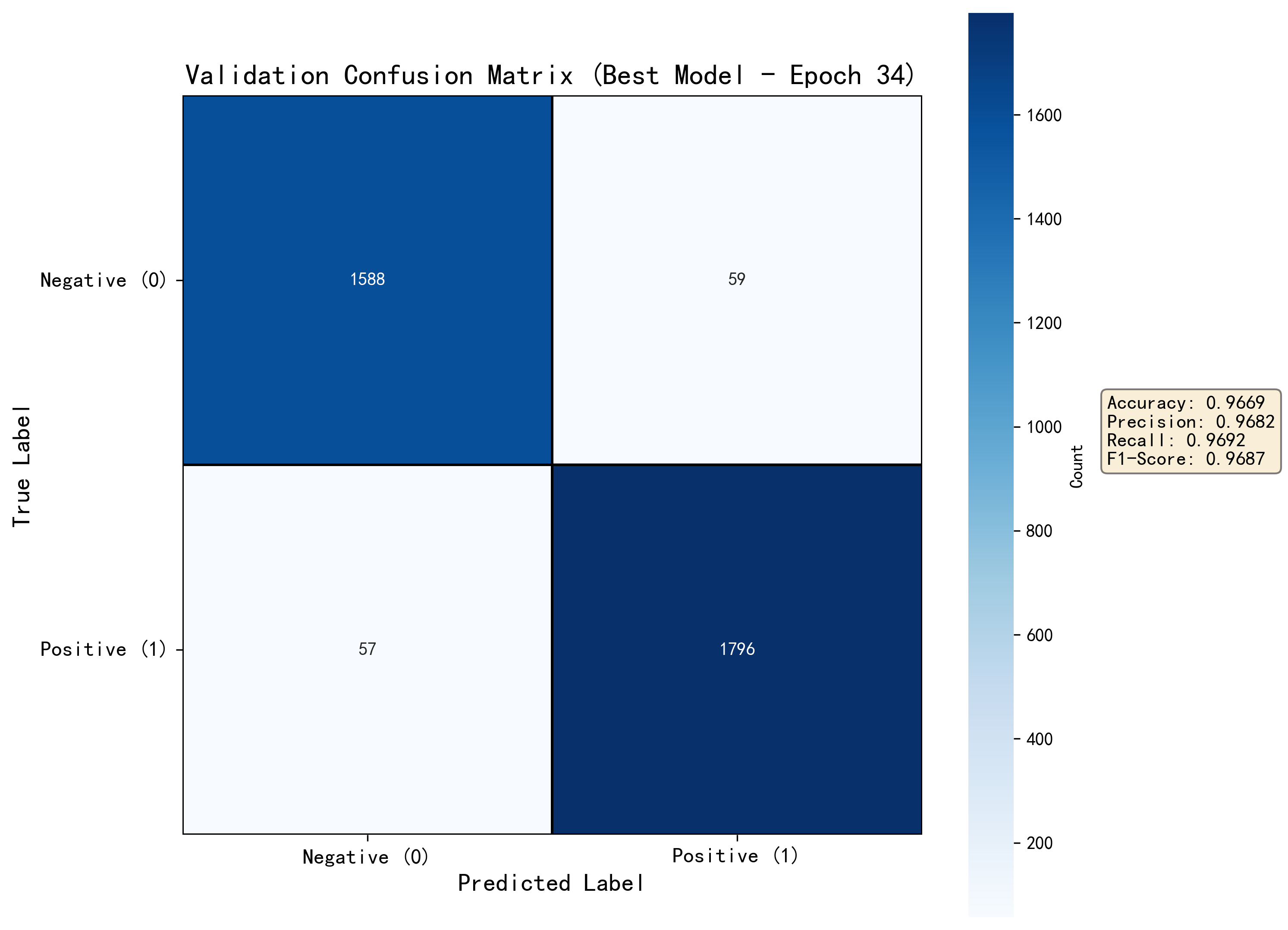

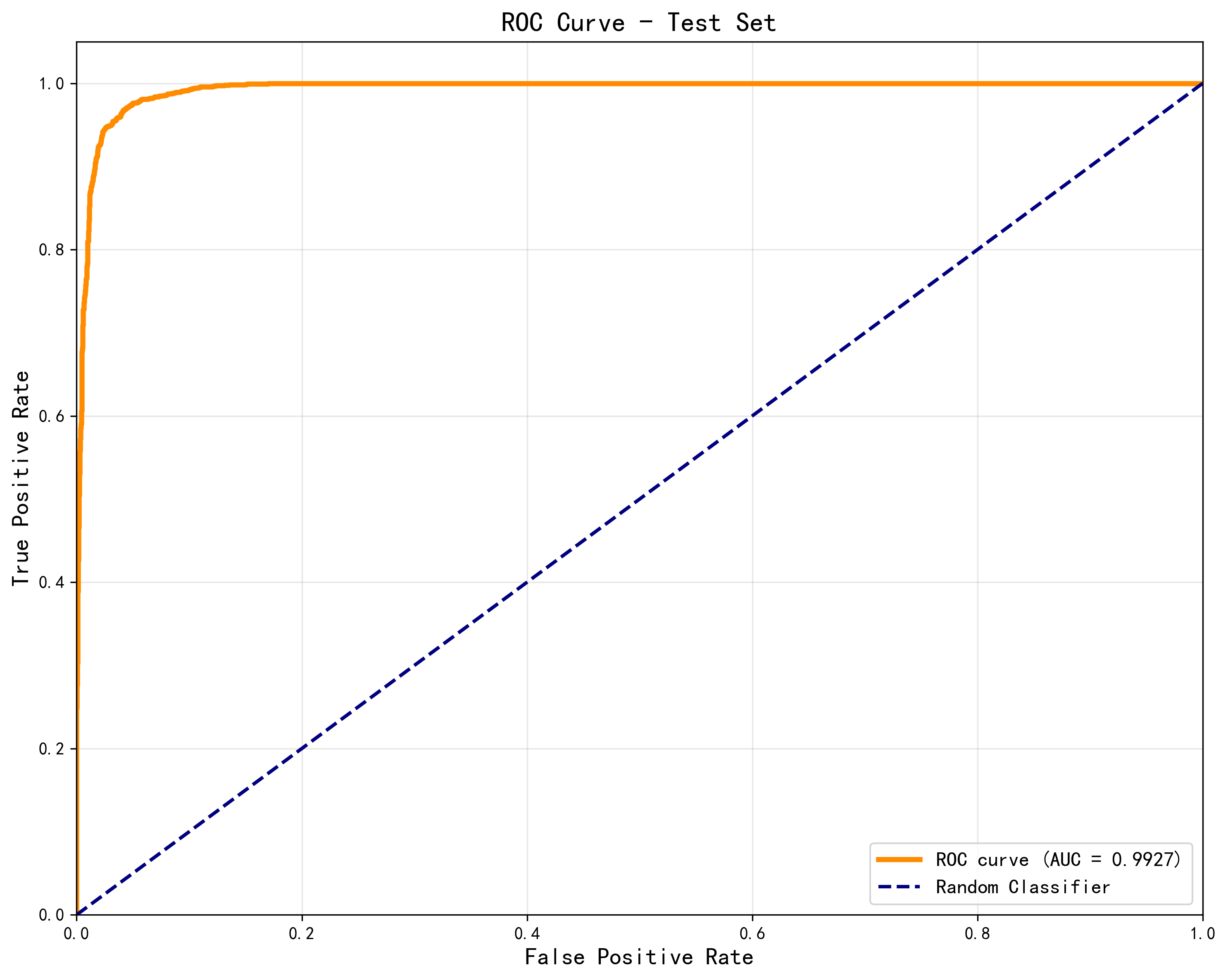

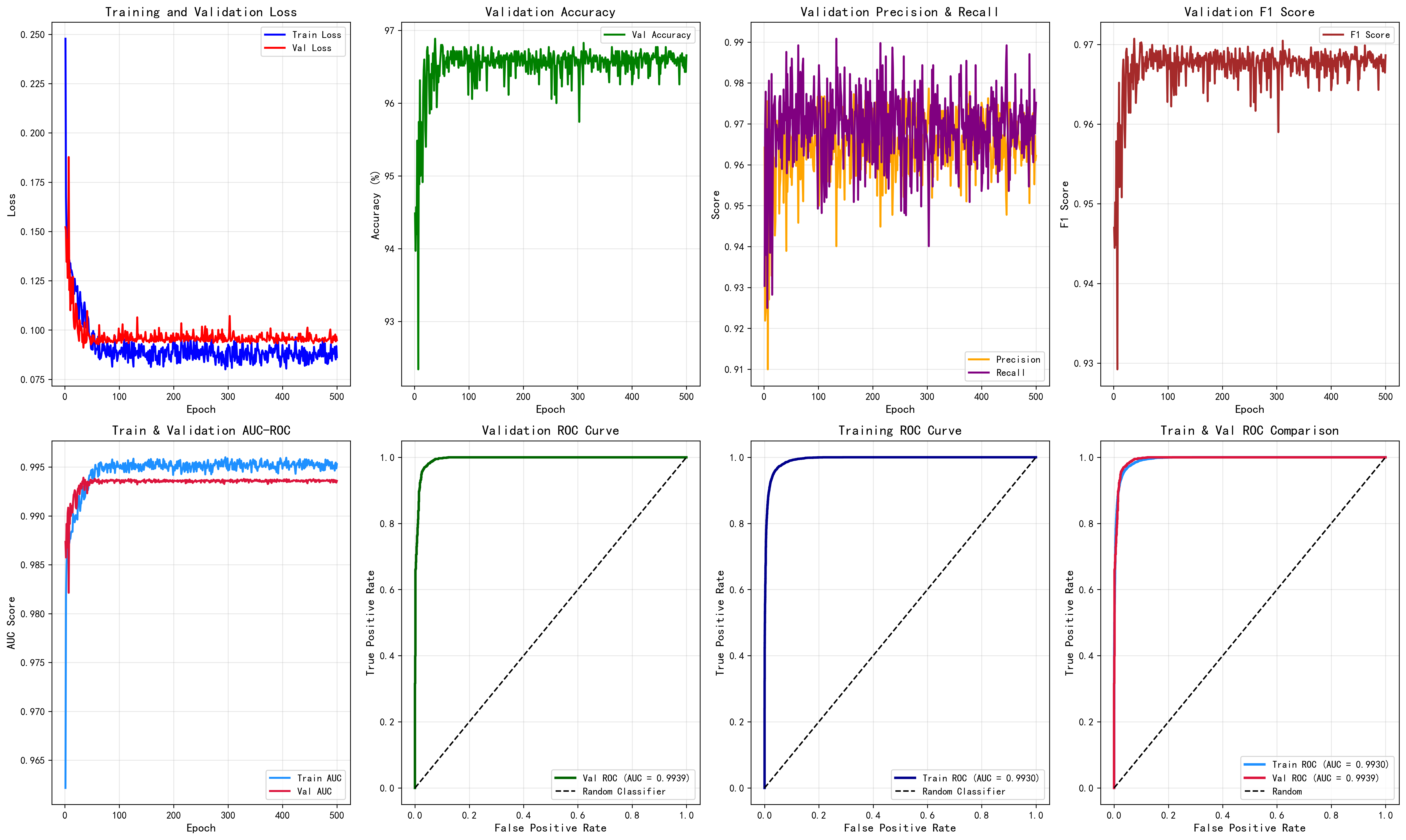

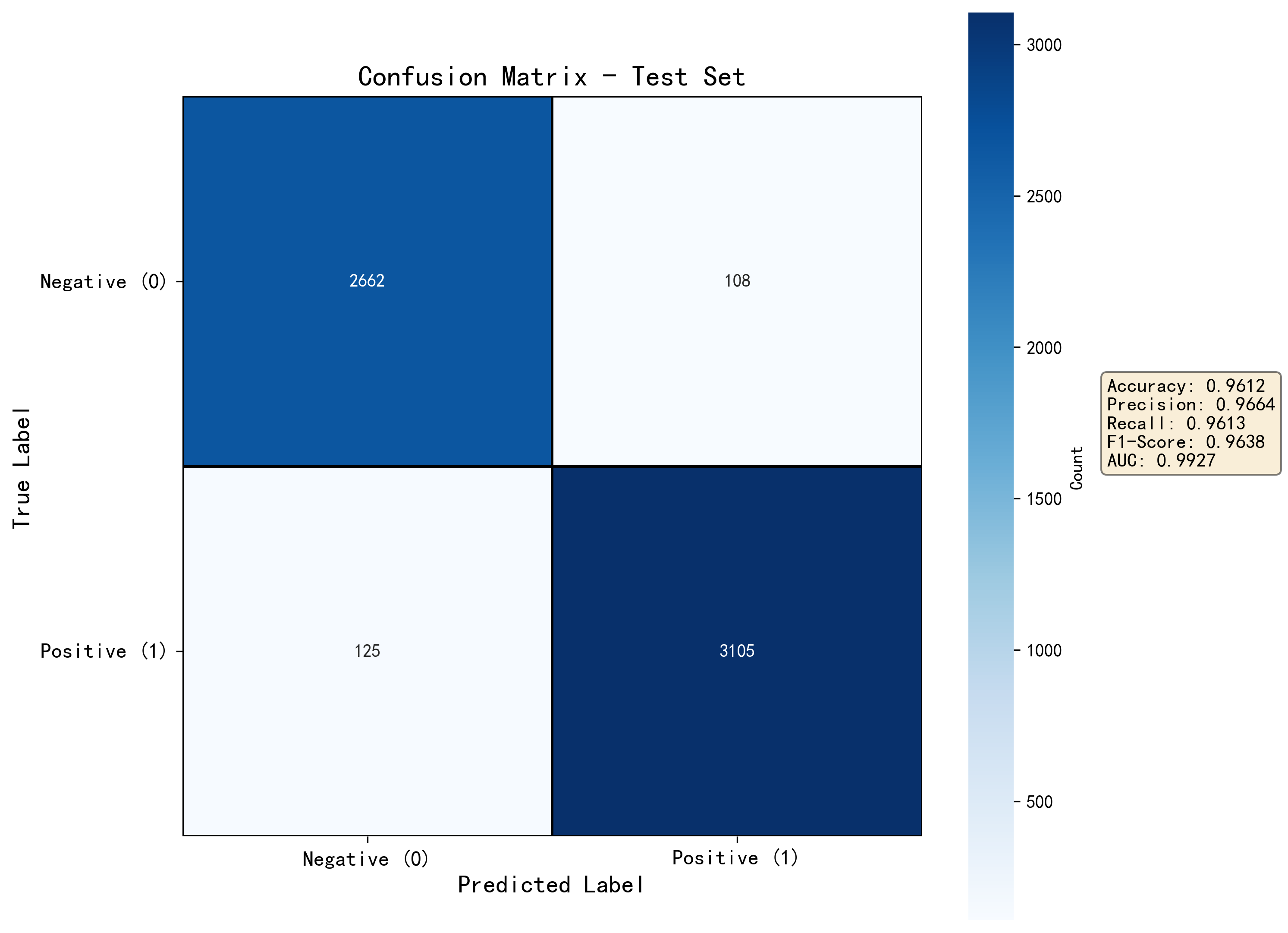

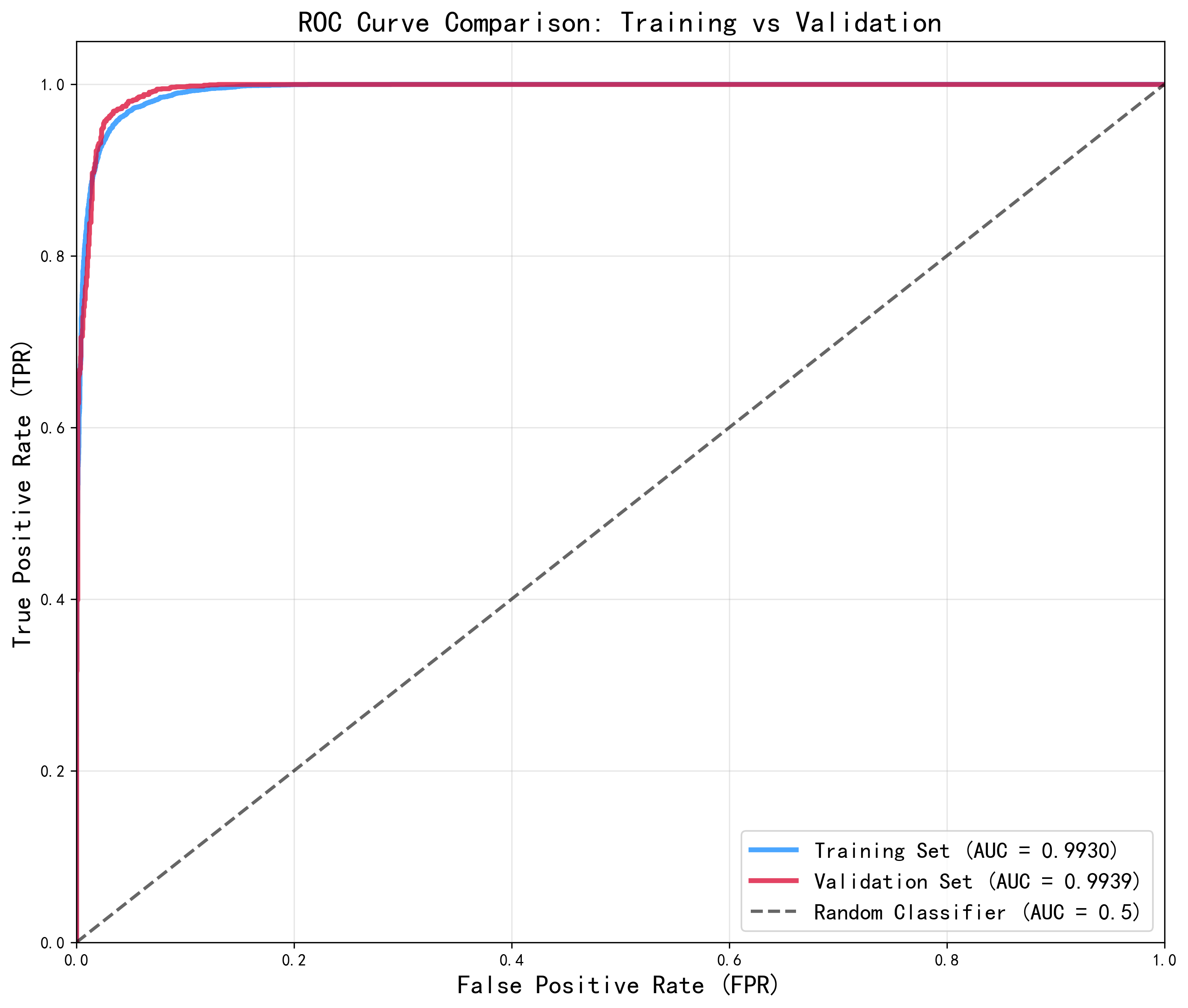

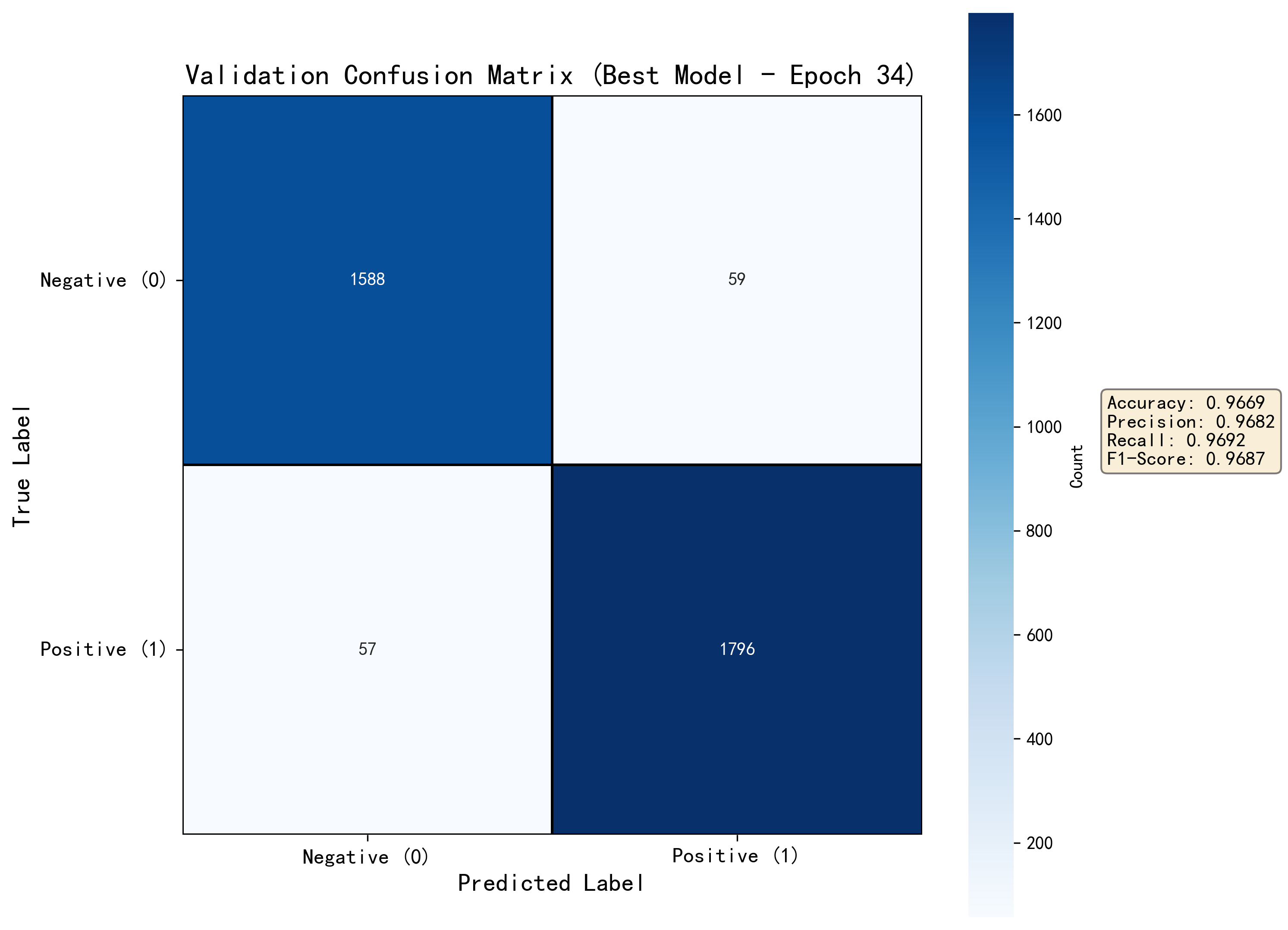

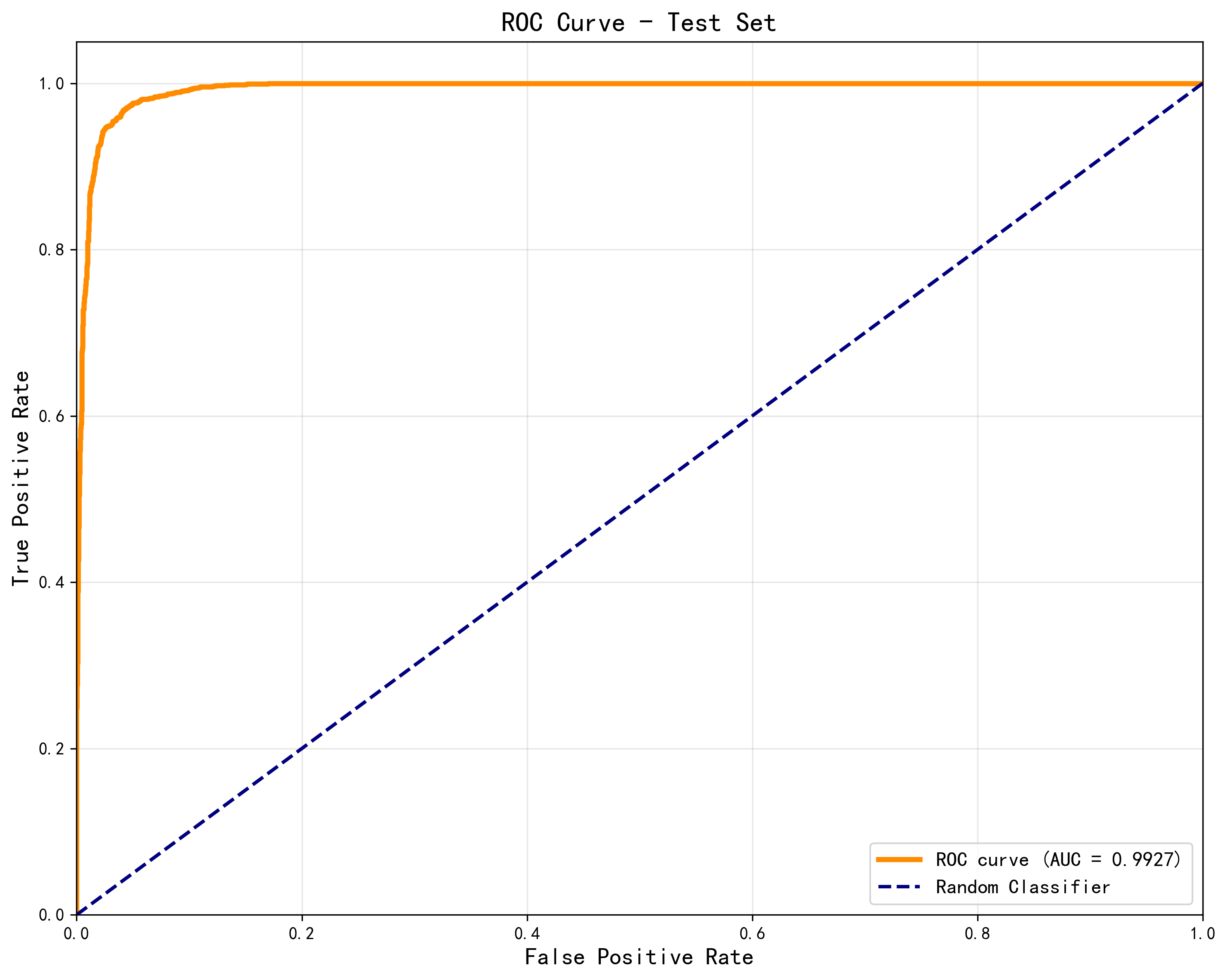

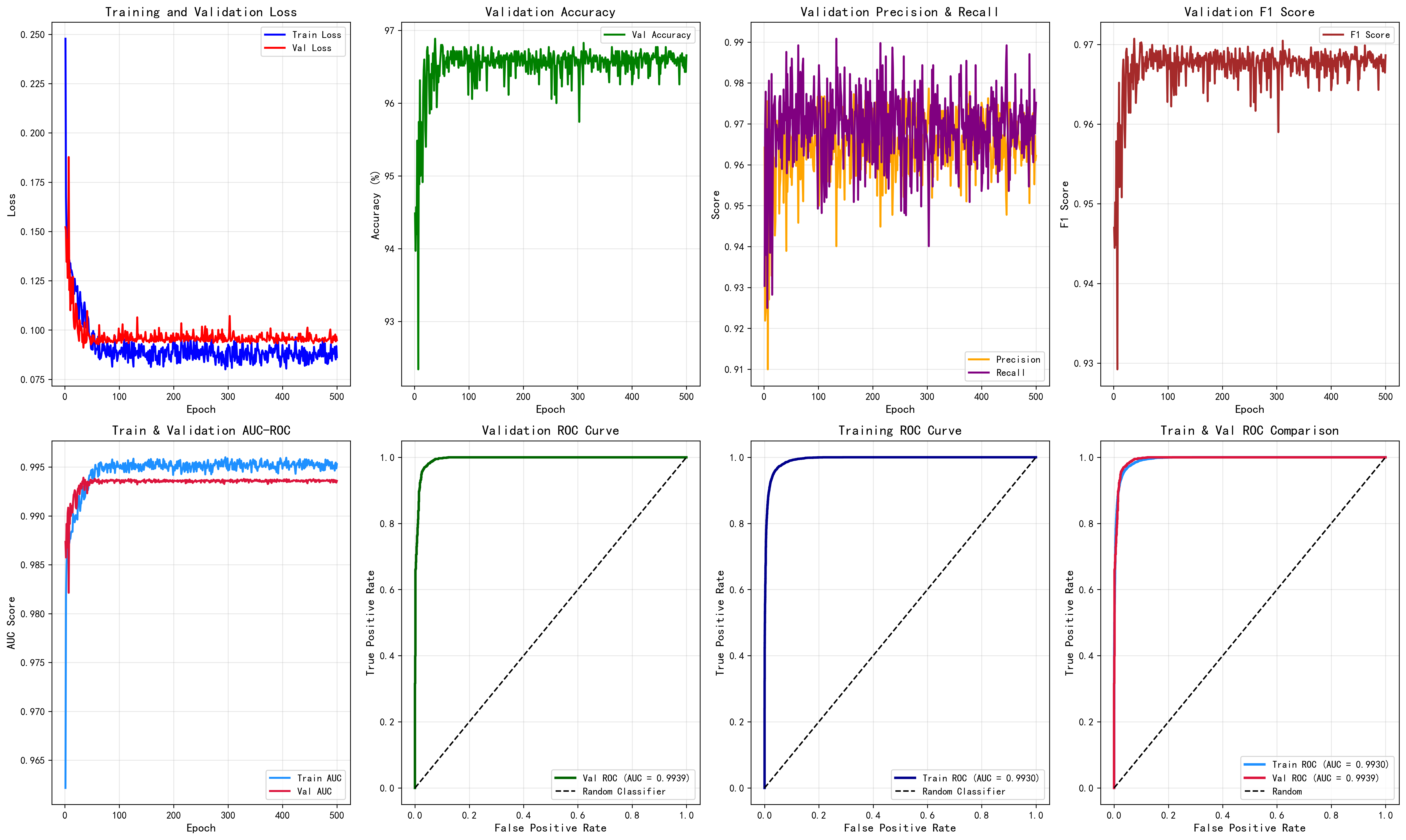

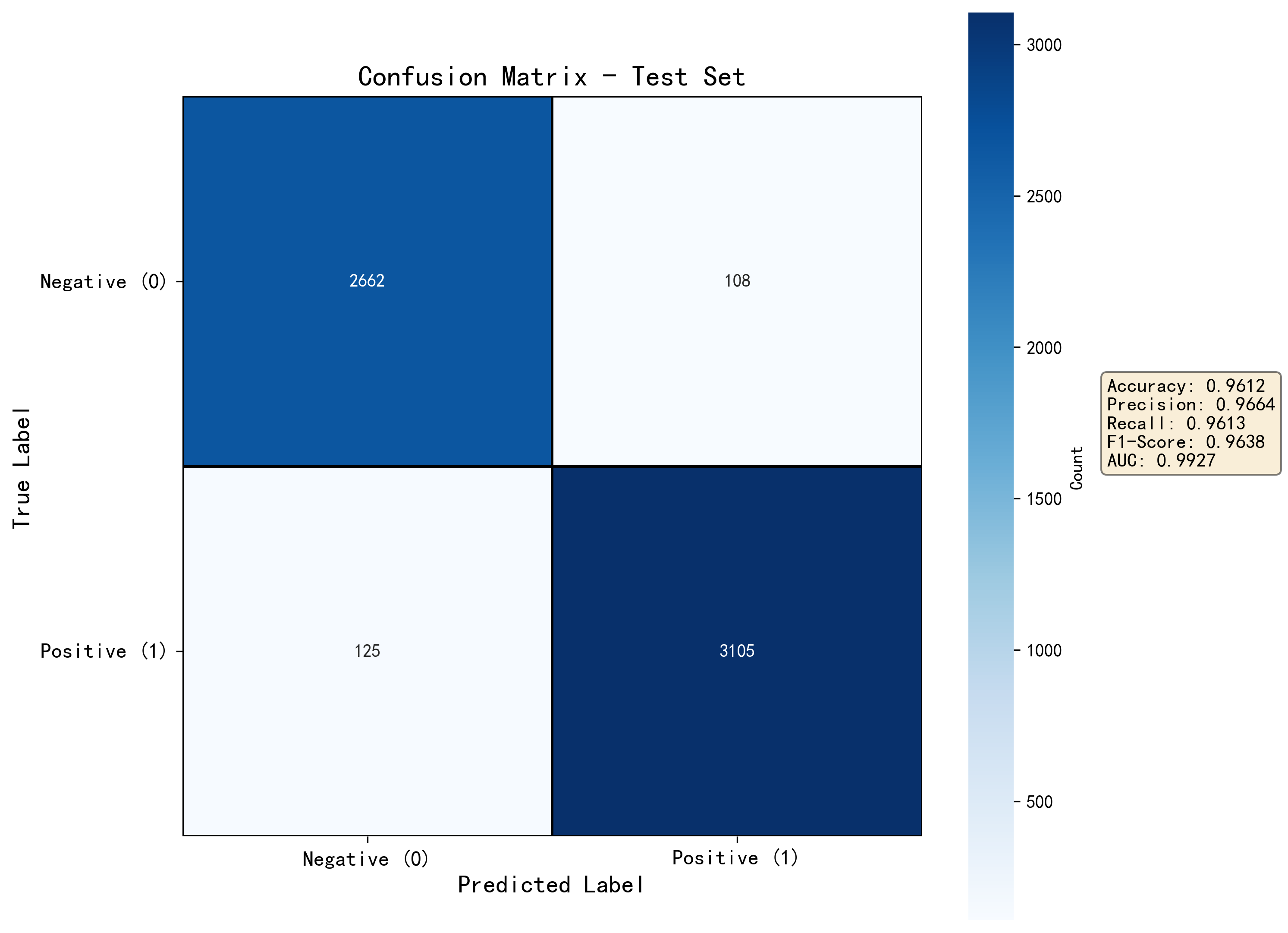

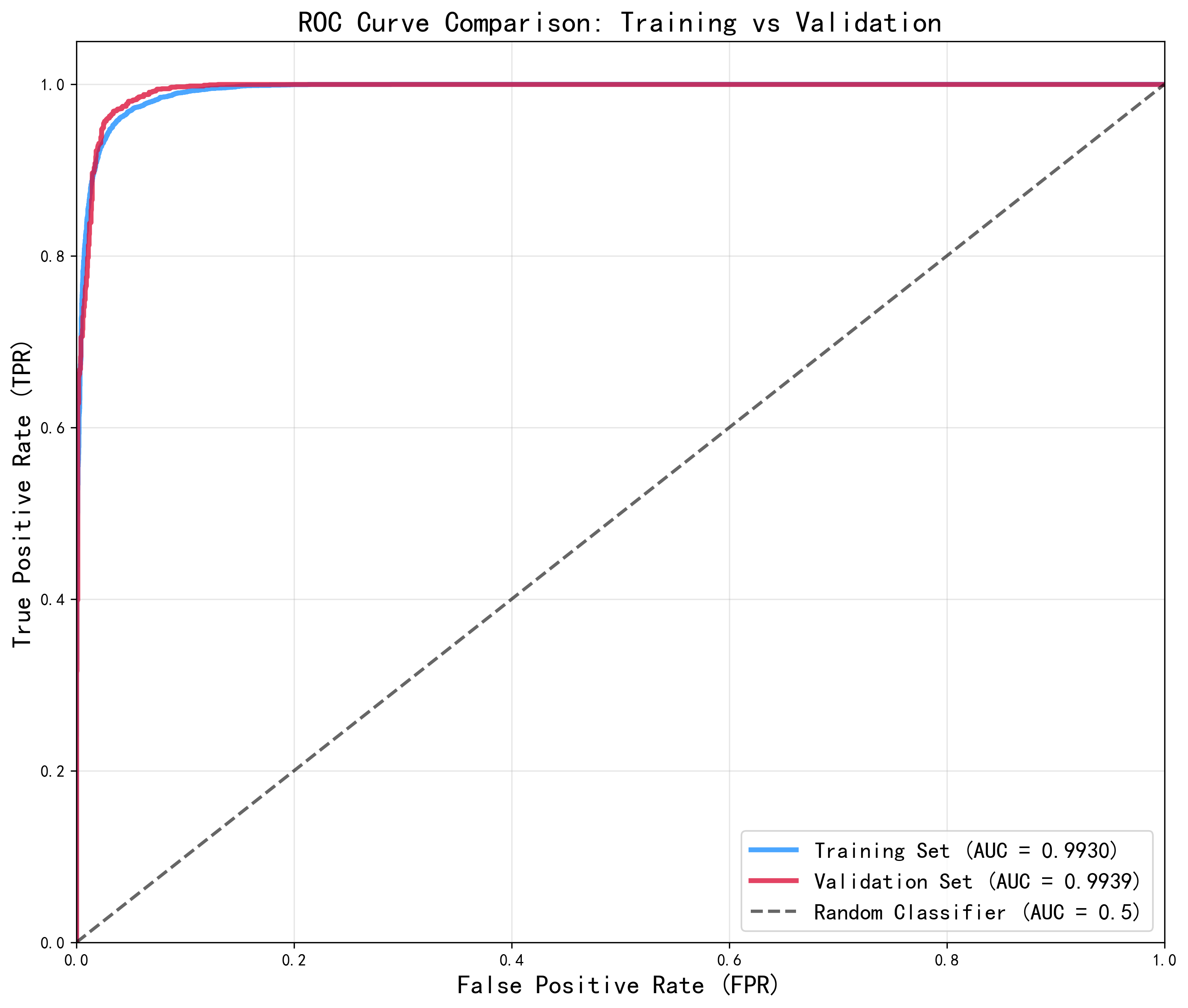

在评估一个二分类任务的性能时,尤其是你提到“收敛非常抖动”但“测试集指标很好”,这可能暗示了一些潜在的问题。以下是我们可以逐步分析和排查的方向:

如果训练集的指标(如准确率、AUC)明显优于验证集,那么可能存在过拟合。

例如:

→ 说明模型可能在训练集上过拟合,但在验证集和测试集上表现稳定。

from sklearn.model_selection import KFold

from sklearn.metrics import accuracy_score, roc_auc_score

# 假设 model 是你的分类器

# X_train, y_train 是训练数据

# X_test, y_test 是测试数据

# 定义 K 折交叉验证

kfold = KFold(n_splits=5, shuffle=True, random_state=42)

# 存储交叉验证结果

cv_scores = []

for train_idx, val_idx in kfold.split(X_train):

X_train_fold, y_train_fold = X_train[train_idx], y_train[train_idx]

X_val_fold, y_val_fold = X_train[val_idx], y_train[val_idx]

# 训练模型

model.fit(X_train_fold, y_train_fold)

# 预测验证集

y_pred_val = model.predict(X_val_fold)

y_proba_val = model.predict_proba(X_val_fold)[:, 1]

# 评估指标

acc = accuracy_score(y_val_fold, y_pred_val)

auc = roc_auc_score(y_val_fold, y_proba_val)

cv_scores.append((acc, auc))

# 输出平均指标

avg_acc = sum([s[0] for s in cv_scores]) / len(cv_scores)

avg_auc = sum([s[1] for s in cv_scores]) / len(cv_scores)

print(f"交叉验证平均准确率: {avg_acc:.4f}")

print(f"交叉验证平均 AUC: {avg_auc:.4f}")

# 最终在测试集上评估

y_pred_test = model.predict(X_test)

y_proba_test = model.predict_proba(X_test)[:, 1]

test_acc = accuracy_score(y_test, y_pred_test)

test_auc = roc_auc_score(y_test, y_proba_test)

print(f"测试集准确率: {test_acc:.4f}")

print(f"测试集 AUC: {test_auc:.4f}")

重点总结:

如果你能提供具体的指标数值、训练损失曲线或代码片段,我可以进一步帮你分析具体问题所在。