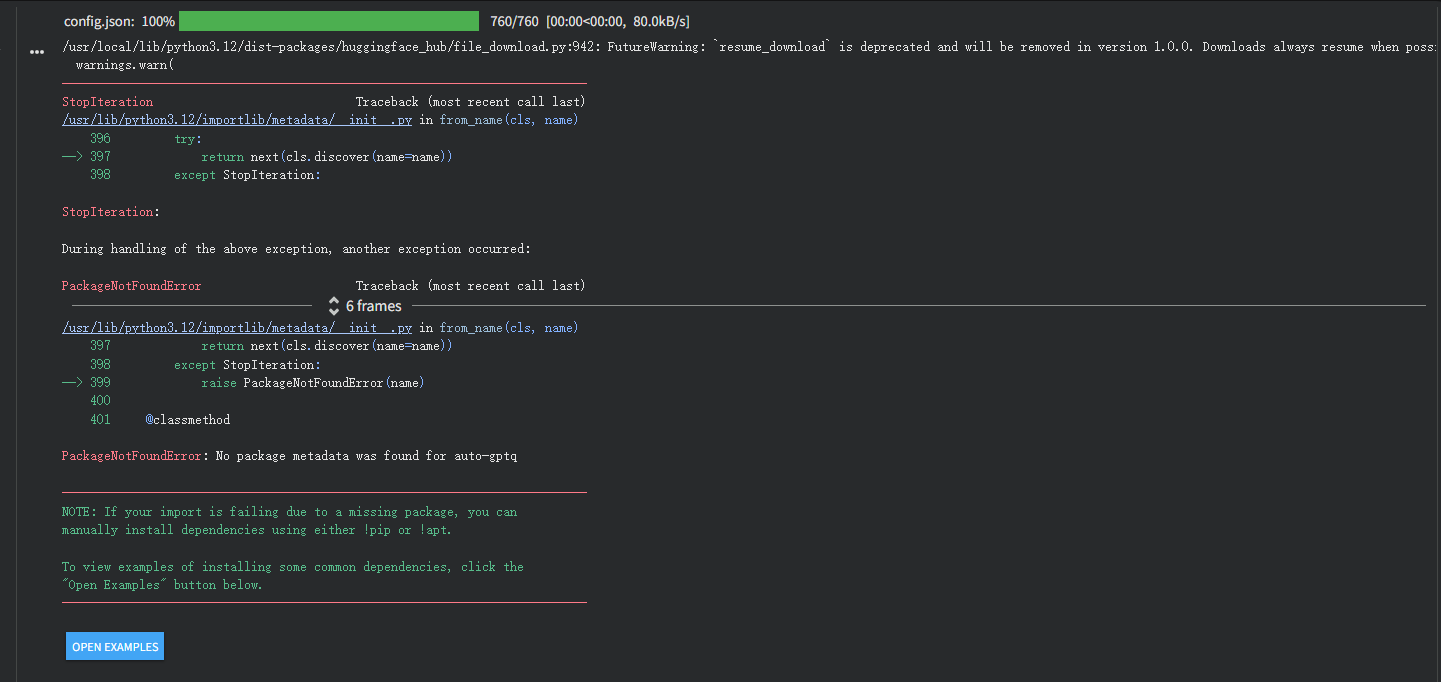

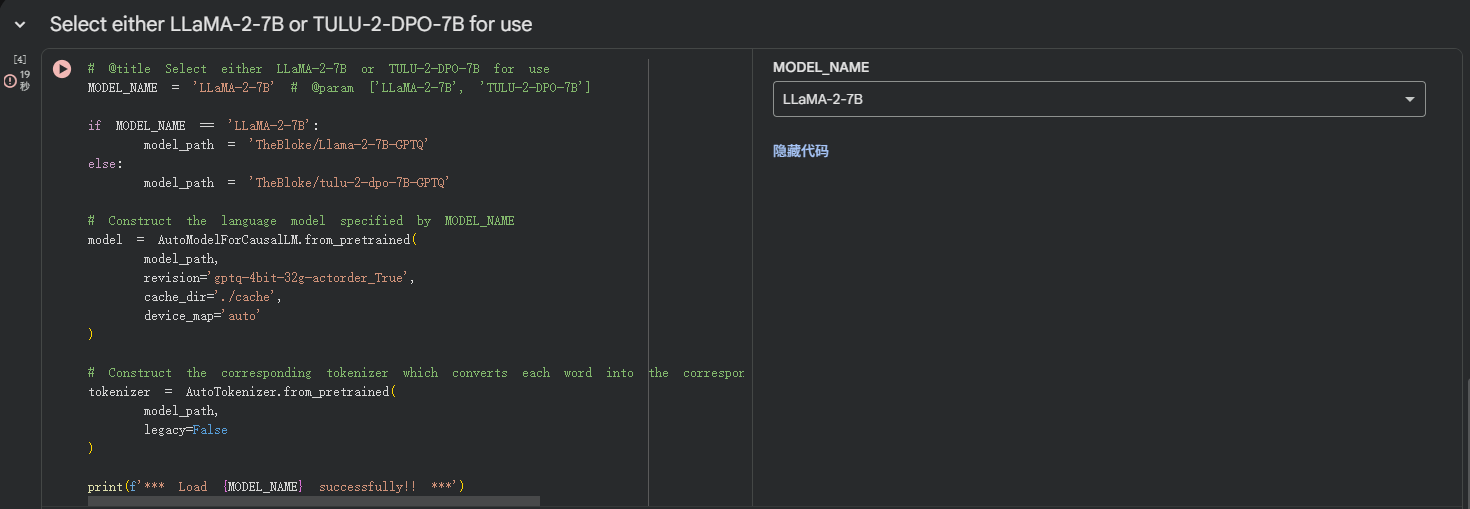

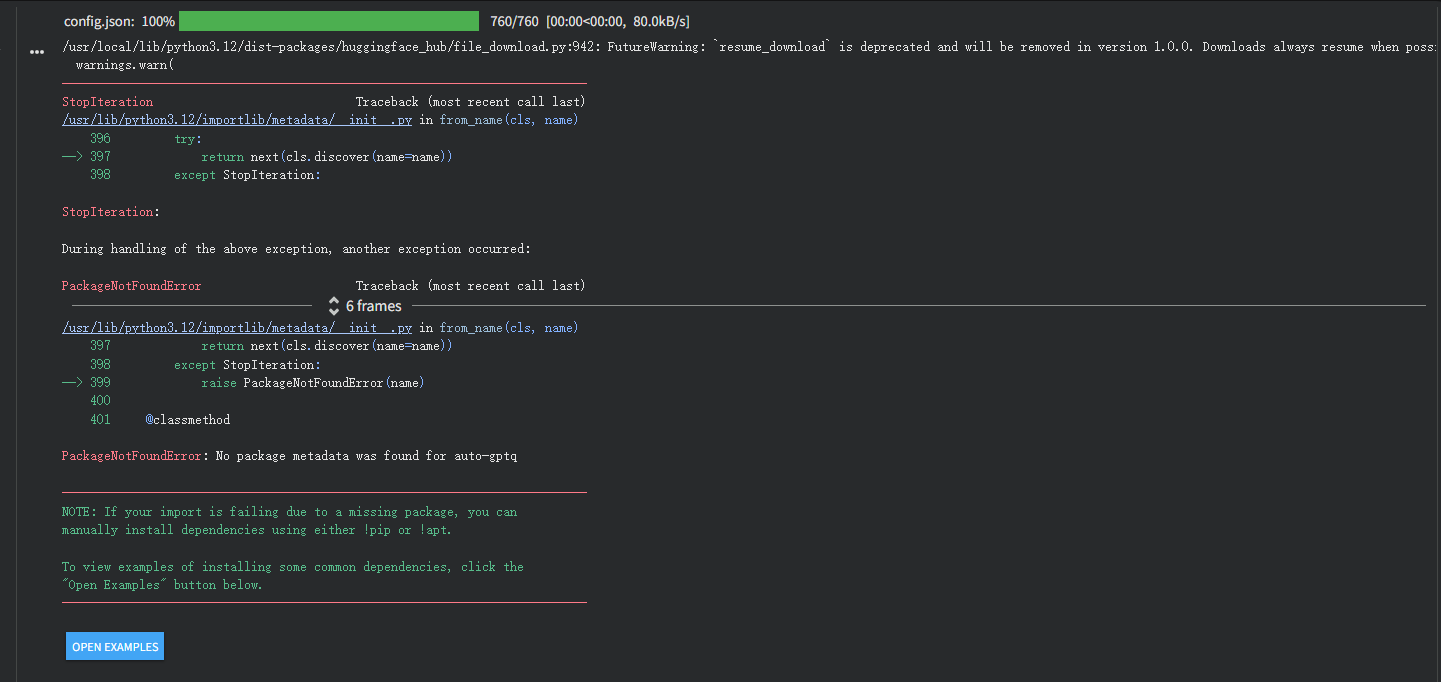

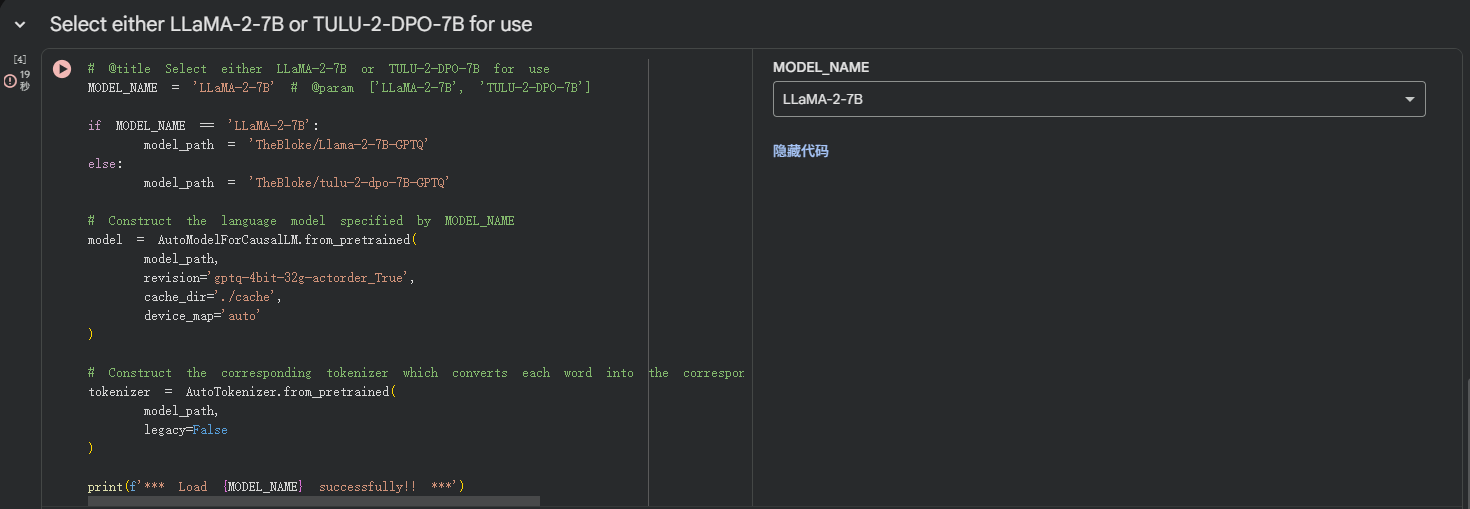

李宏毅教授的《生成式AI导论2024》课程的HW8的导入模型的代码现在一直出现bug

PackageNotFoundError: No package metadata was found for auto-gptq 有人知道怎么解决吗

李宏毅教授的《生成式AI导论2024》课程的HW8的导入模型的代码现在一直出现bug

PackageNotFoundError: No package metadata was found for auto-gptq 有人知道怎么解决吗

下午好🌅🌅🌅

本答案参考通义千问

你提到的错误信息是:

PackageNotFoundError: No package metadata was found for auto-gptq

这个错误通常发生在尝试导入某个Python包(如 auto-gptq)时,但系统找不到该包的元数据。这可能是因为 安装不完整、版本不兼容 或 环境配置问题 所导致。

未正确安装 auto-gptq 包

auto-gptq 是一个用于量化模型的库,需要通过 pip 安装。pip install auto-gptq,可能会因为依赖项或平台不兼容而失败。依赖项缺失或版本冲突

auto-gptq 依赖于 PyTorch 和一些其他库,如果这些库没有正确安装或版本不匹配,也会导致安装失败。使用了错误的 Python 环境

PyTorch 版本不兼容

auto-gptq 对 PyTorch 的版本有特定要求,如果版本过旧或过新,也可能无法正常工作。auto-gptq 是否已正确安装运行以下命令查看是否安装成功:

pip show auto-gptq

如果没有输出,说明没有安装成功。

auto-gptq确保使用正确的 pip 命令安装:

pip install auto-gptq

如果你使用的是 conda 环境,可以尝试:

conda install -c conda-forge auto-gptq

确保 PyTorch 已经安装,并且与 auto-gptq 兼容。你可以使用以下命令安装 PyTorch(根据你的 CUDA 版本选择合适的版本):

pip install torch==1.13.1+cu117 torchvision==0.14.1+cu117 --extra-index-url https://download.pytorch.org/whl/cu117

注意: 根据你的 GPU 驱动和 CUDA 版本,选择合适的 PyTorch 版本。

确保你使用的 Python 环境与安装 auto-gptq 的环境一致。你可以通过以下命令检查当前环境:

python -m site

或者:

which python

确保你是在正确的虚拟环境或全局环境中运行代码。

推荐使用 venv 或 conda 创建独立环境,避免依赖冲突:

python -m venv myenv

source myenv/bin/activate # Linux/Mac

myenv\Scripts\activate # Windows

然后在激活的环境中安装 auto-gptq:

pip install auto-gptq

如果你仍然遇到问题,可以尝试修改代码中导入 auto-gptq 的方式,例如:

try:

from auto_gptq import AutoGPTQForCausalLM

except ImportError:

print("Please install auto-gptq package.")

auto-gptq 的官方 GitHub 页面,确保你使用的是最新版本:

# 导入模块前检查是否安装成功

try:

from auto_gptq import AutoGPTQForCausalLM

except ImportError:

print("Error: 'auto-gptq' package not found.")

print("Please run: pip install auto-gptq")

exit(1)

# 正常导入后继续执行代码

model = AutoGPTQForCausalLM.from_pretrained("your_model_name")

| 步骤 | 内容 |

|------|------|

| 1 | 检查 auto-gptq 是否安装成功 |

| 2 | 重新安装 auto-gptq |

| 3 | 确保 PyTorch 和相关依赖正确安装 |

| 4 | 检查 Python 环境一致性 |

| 5 | 使用虚拟环境隔离依赖 |

| 6 | 修改代码以处理导入异常 |

如果你仍然遇到问题,请提供完整的错误日志,我可以进一步帮你定位原因。