为什么求完偏导1/N消失了?

还有在这之前的一页中,这种表达是什么意思?

以下回答参考 皆我百晓生、券券喵儿 等免费微信小程序相关内容作答,并由本人整理回复。

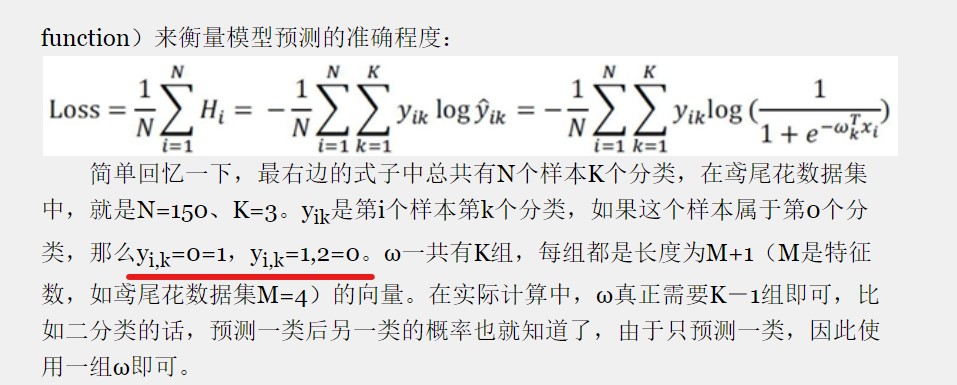

在机器学习和深度学习中,损失函数是用来度量模型预测结果与真实标签之间的差异的一种方法。损失函数的目标是在最小化损失值的同时最大化模型性能。

在你的问题中提到的Loss是一个表示模型预测准确性的指标。它由两个部分组成:

y代表样本所属的类别,w是权重参数,sigmoid函数(通常使用Sigmoid函数)是激活函数。p与真实概率t相比较来计算。为了简化损失函数的表达式,可以对p和t分别进行对数转换,这样可以消去乘积项中的指数部分。这样做是因为log(1+e^x)和(1-e^(-x))都是常数,不影响最终的损失值。这里e大约等于2.71828,是一个自然对数底。

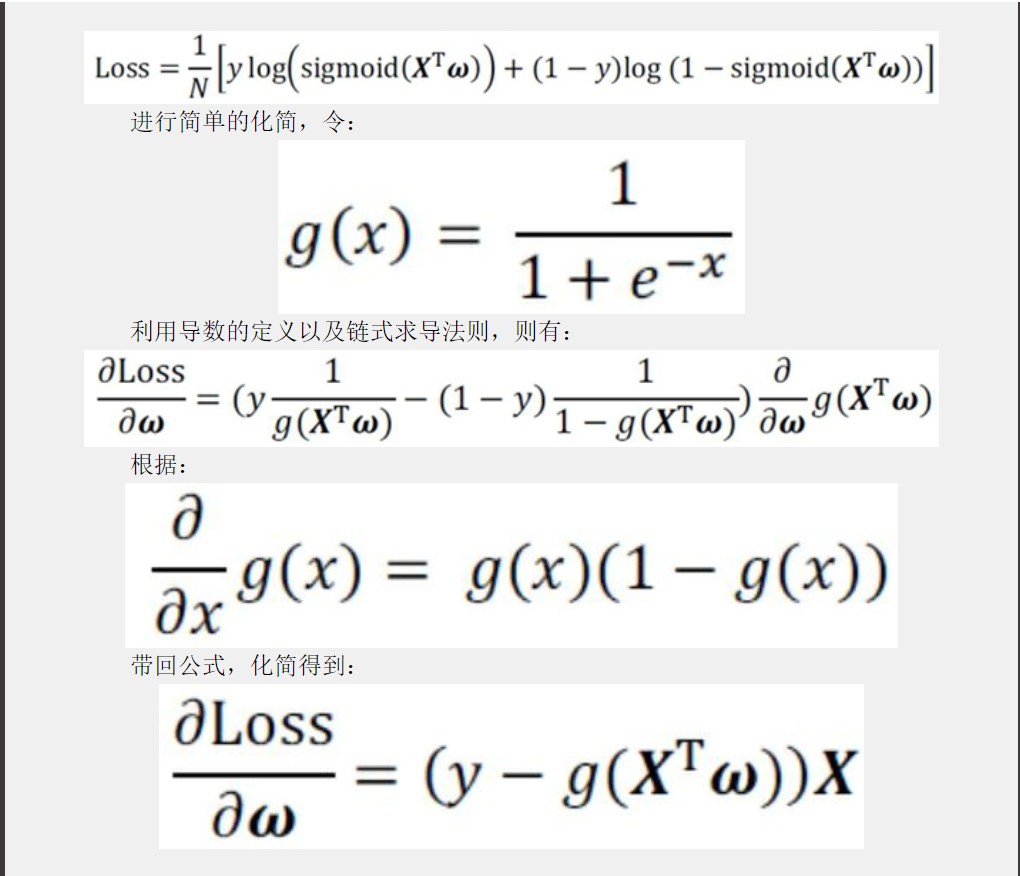

简化后的损失函数变为:

Loss = 1/2 [ y log ( sigmoid ( X T w ) ) + ( 1 - y ) log ( 1 - sigmoid ( X T w ) ) ]

这里的y和1-y分别对应于样本的实际标签y_i和非标签1-y_i。sigmoid(XTw)是预测概率,其输出范围在0到1之间。然后,我们将所有这些项加在一起,并将其除以2,因为损失函数通常是负的,所以我们需要先除以2再取负。

接下来,我们可以看到在你提供的代码示例中,Loss的简化形式实际上已经包含了所有必要的操作。在你的例子中,我们首先对损失函数进行了化简,并且没有额外的操作或步骤。因此,你不需要进一步的解释或者代码来解决这个问题。

如果你有任何疑问或者需要进一步的帮助,请随时告诉我。