这个问题之前也遇到过,都是spark逻辑无误,执行的结果表可以查看df.dtypes,df.columns等信息,但是无法df.count(),df.show()以及导出到外部文件。之前听前辈说是spark不支持循环连接,也没有搞明白怎么回事。最近又碰到了类似的情况,怎么调也调不好,阴差阳错把左连接反过来写成右连接就可以跑通了,有人碰到过这种情况吗?

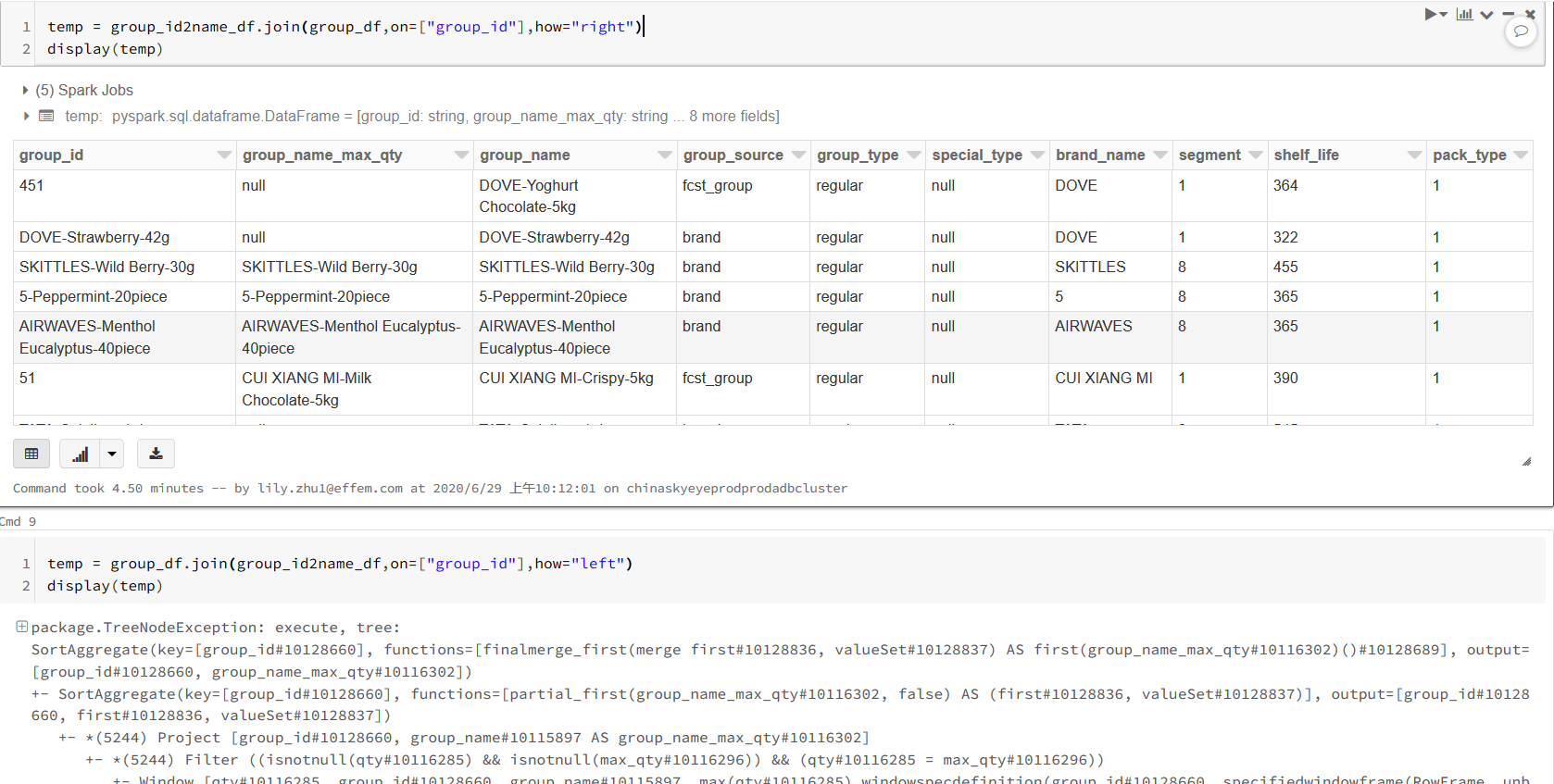

如图所示,笔者三天前写的group_df与group_id2name_df左连接是可以正常跑通的,但是今天就报错了,后来改成右连接又可以跑通,现在真的是丈二和尚摸不着头脑了。