1条回答 默认 最新

oyljerry 2018-09-20 08:19关注

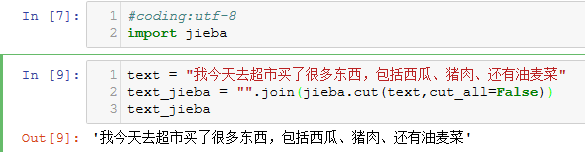

oyljerry 2018-09-20 08:19关注你自己用join又把所有的分词连接起来了,cut返回的生成器中就有所有的词

In [4]: res = jieba.cut(text, cut_all=False) In [5]: res Out[5]: <generator object Tokenizer.cut at 0x0000003FB9F9E888> In [6]: for x in res: ...: print(x) ...: Building prefix dict from the default dictionary ... Dumping model to file cache C:\Users\jerry_ou\AppData\Local\Temp\jieba.cache Loading model cost 0.867 seconds. Prefix dict has been built succesfully. 今天 我 去 超市 买 了 很多 东西 , 包括 西瓜 , 猪肉 还有 油麦 菜解决 无用评论 打赏 举报

悬赏问题

- ¥15 素材场景中光线烘焙后灯光失效

- ¥15 请教一下各位,为什么我这个没有实现模拟点击

- ¥15 执行 virtuoso 命令后,界面没有,cadence 启动不起来

- ¥50 comfyui下连接animatediff节点生成视频质量非常差的原因

- ¥20 有关区间dp的问题求解

- ¥15 多电路系统共用电源的串扰问题

- ¥15 slam rangenet++配置

- ¥15 有没有研究水声通信方面的帮我改俩matlab代码

- ¥15 ubuntu子系统密码忘记

- ¥15 保护模式-系统加载-段寄存器