用tf跑一个卷积神经网络时报错!

我查看了很多关于报该类型的错误文档,大多都说是因为tensorflow是一个很贪心的框架,总是试图为自己分配全部的GPU资源,但实际上GPU资源不可能完全一点不被其他程序占用,导致初始化失败。解决的办法都是再创建session时加上配置参数:

gpu_options = tf.GPUOptions(per_process_gpu_memory_fraction=0.333)

sess = Session(config=tf.ConfigProto(gpu_options=gpu_options))

还有许多其他的参数,我都试了,但还是报了相同的错误,心里苦,跪求各位dalao!

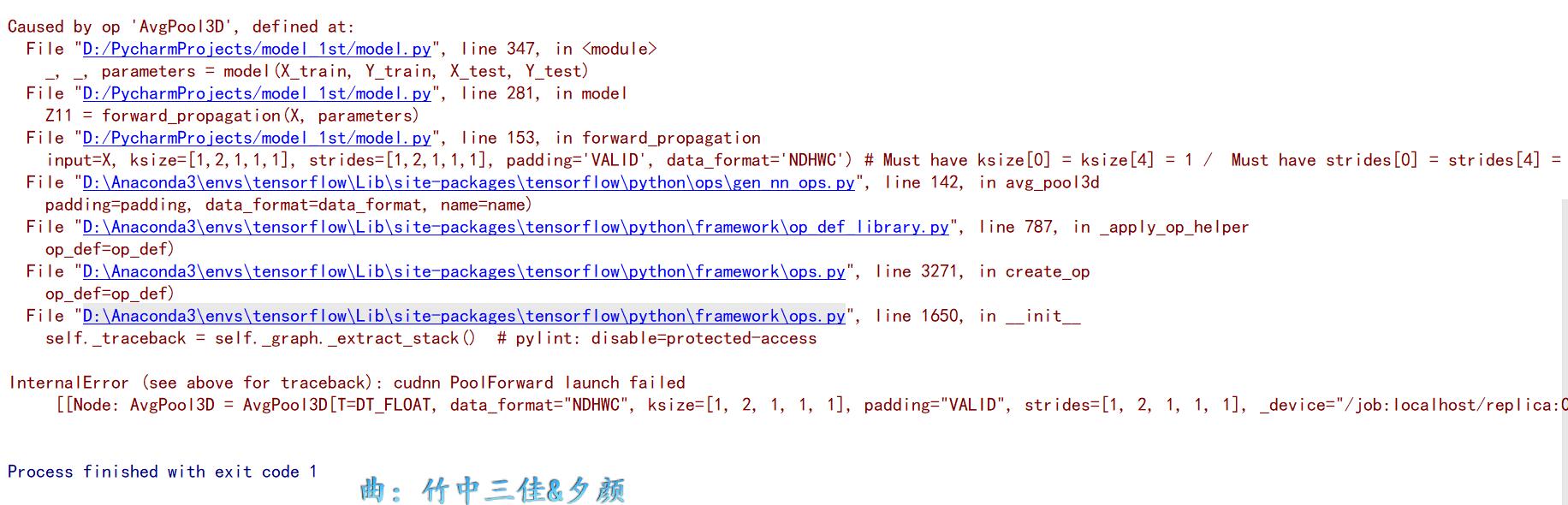

用tensorflow跑卷积网络报错:InternalError (see above for traceback): cudnn PoolForward launch failed

- 写回答

- 好问题 0 提建议

- 关注问题

- 邀请回答

-