我在尝试将两个网络连起来用,现在确认单独使用其中一个,屏蔽另一个是能够反向传播,即正常运行,但是两个一起用就报错

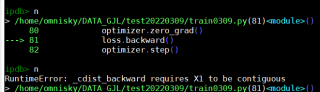

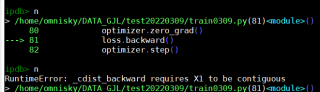

loss.backward()这一行报错

RuntimeError: _cdist_backward requires X1 to be contiguous

搜遍了网络找不到原因,请教各位是否有过了解。我是在pytorch框架下运行的python, 使用的loss函数是MSELoss()

这个报错指你的tensor经过拼接或者维度变换之后没有加上.contiguous(),导致内存不连续,你可以在有view(),或者transpose() 之类的地方后面加上.contiguous()看看行不行