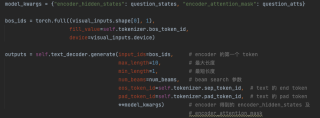

在 xbert 提供的代码中,有一个 BertLMHeadModel 类,我将其作为模型的 text_decoder,希望它能通过 generate() 方法,根据 text_encoder 中得到 encoder_hidden_states 和 encoder_attention_mask 来解码出对应的 text token,输入参数具体如图所示,但是为什么 outputs 输出的每一项都相同?而且在我去除 **model_kwargs 参数的情况下,模型仍能跑出一样的结果(但是在别的模型中,这一参数是必须的)?其中 self.text_decoder 就是 BertLMHeadModel。