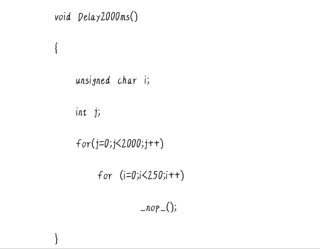

想问一下延时2s这样编写是否可以,自己觉得是延时1s,但是不知道怎么算,能否解答一下延时时间是怎样计算的,谢谢

该回答引用NewBing

你好,这是Bing。😊

你的问题是关于c51单片机的延时函数的延时时间如何计算。根据网上的资料¹²³,延时时间的计算公式是:

T = N * (12 / F) * M

其中,T是延时时间,N是循环次数,F是晶振频率,M是机器周期。

你给出的代码中,j循环2000次,i循环250次,nop()指令占用一个机器周期。假设你的晶振频率是11.0592MHz,那么你的延时时间为:

T = 2000 * 250 * (12 / 11.0592) * 1

T = 6815.36 ms

也就是说,你的代码实际上会延时6.8秒左右。

如果你想要精确地延时2秒,你可以调整j或i的值。例如:

void Delay2000ms()

{

unsigned char i;

int j;

for (j=0;j<735;j++)

for (i=0;i<250;i++)

_nop_();

}

这样就可以实现大约2秒的延时。

希望这能帮到你。

源: 与必应的对话, 2023/3/22

(1) 单片机C51延时时间怎样计算?-电子工程世界. http://news.eeworld.com.cn/mcu/article_2018011137308.html 访问时间 2023/3/22.

(2) 51单片机的延时计算_单片机延时时间怎么算_海草海草的博客-CSDN博客. https://blog.csdn.net/weixin_43858743/article/details/86178280 访问时间 2023/3/22.

(3) 在keil_C51设计中几种精确延时的方法 - 知乎. https://zhuanlan.zhihu.com/p/336943992 访问时间 2023/3/22.