让 “紫雾凌寒” 来帮你回答,本回答结合 DeepSeek

如果还有问题,请评论或点击头像私信,如果有帮助到您, 请关注、采纳、点赞

- 关键点分析:

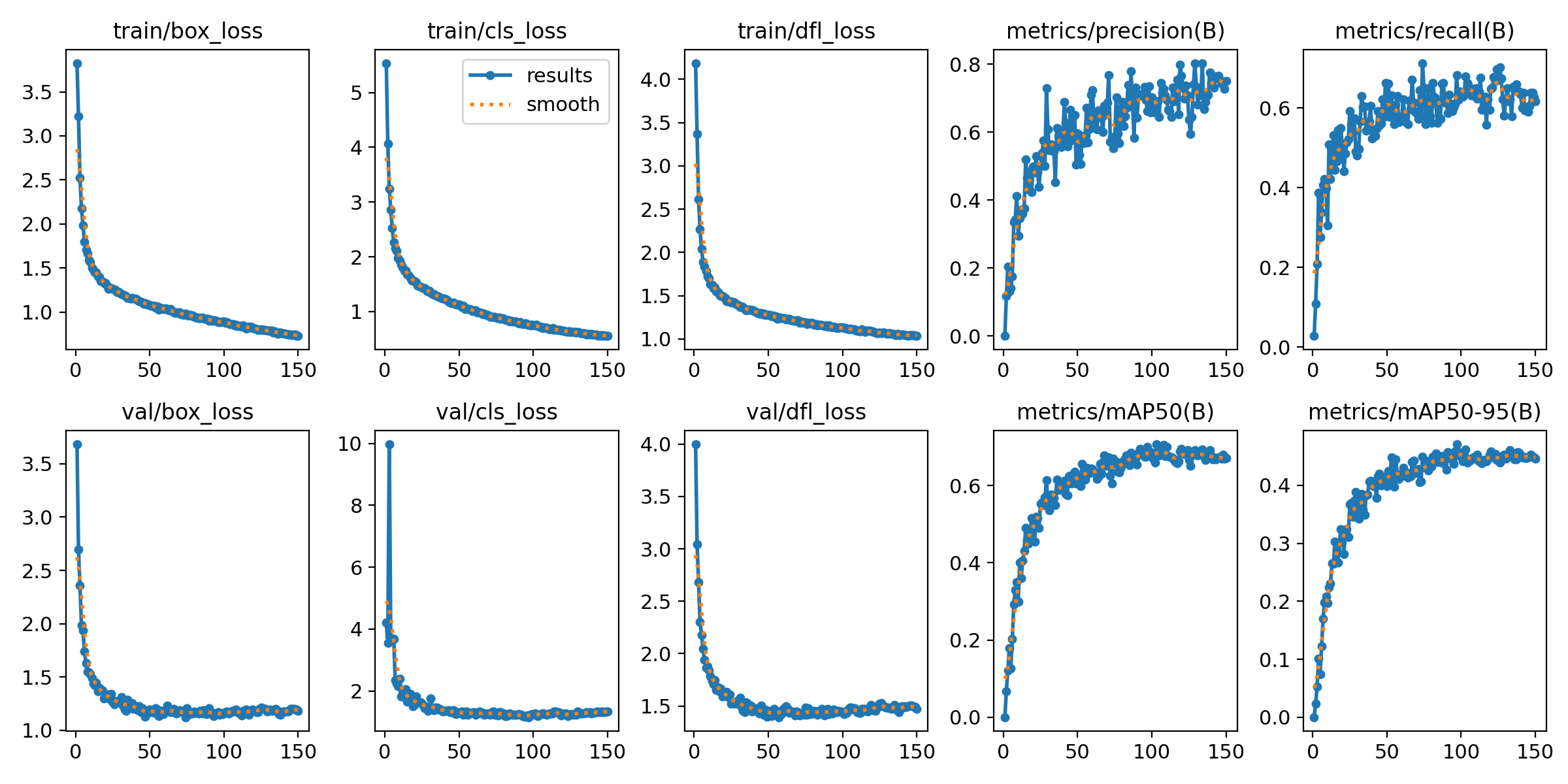

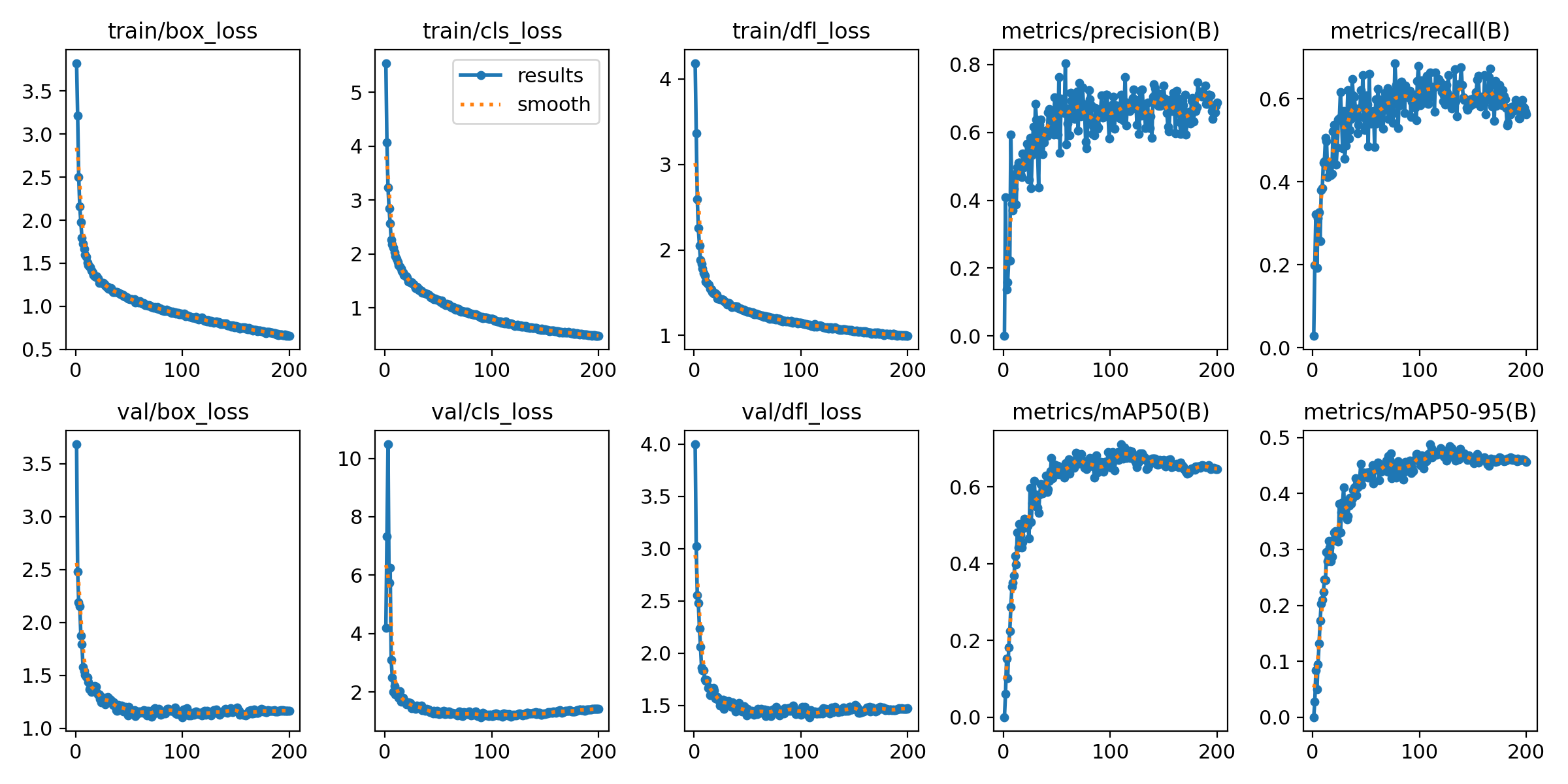

- 核心在于通过观察loss曲线来判断150轮和200轮训练哪个更合适。这需要理解loss曲线的走势与模型训练效果之间的关系。 - 解决方案:

- 一般来说,理想的loss曲线是随着训练轮数增加而不断下降的。

- 首先看曲线的下降趋势:- 如果在150轮时,loss已经下降到一个较低且趋于稳定的值,比如loss值接近0.1且在后续几轮波动很小,那么150轮可能就足够了。这意味着模型在150轮时已经较好地拟合了数据,再增加轮数可能不会带来显著的性能提升,反而可能导致过拟合等问题。

- 例如,在150轮时loss为0.12,151轮为0.118,152轮为0.119,曲线波动不大且接近某个预期的较低值,此时150轮左右可能是合适的。

- 若在150轮时loss仍有明显下降空间,且在200轮时下降到更低且稳定的值,比如loss值下降到0.05且波动较小,那么200轮可能更合适。这说明模型在更多轮的训练中进一步优化了参数,更好地拟合了数据。

- 比如,150轮时loss为0.2,到200轮时loss下降到0.06,且后续几轮波动在0.06附近,表明模型在150 - 200轮之间继续学习并取得了更好的效果。

- 还可以看曲线的下降速度:

- 如果在150轮之前loss下降速度很快,之后变得缓慢,可能150轮就是一个拐点,再往后训练收益不大。

- 例如,前50轮loss从1下降到0.5,50 - 150轮从0.5下降到0.2,150 - 200轮从0.2下降到0.18,下降速度明显减缓,此时150轮可能就比较合适。

- 多种方案优缺点:

- 方案一:选择150轮- 优点:训练时间短,能较快得到一个相对不错的模型,适合对时间要求较高的场景;避免了过拟合风险,因为没有过度训练。

- 缺点:可能没有充分挖掘模型潜力,若后续还有下降空间,可能导致模型性能不如多训练几轮的情况。

- 方案二:选择200轮

- 优点:模型可能达到更好的性能,能更充分地拟合数据,在测试集等场景下可能有更好的表现。

- 缺点:训练时间长;增加了过拟合的风险,可能导致模型在新数据上的泛化能力下降。

- 总结:

- 要判断150轮还是200轮合适,需综合考虑loss曲线的下降趋势、下降速度以及对训练时间和过拟合风险的接受程度。如果曲线在150轮已趋于稳定且性能满足需求,150轮即可;若150轮后仍有明显下降空间且性能提升明显,200轮可能更优。

例如,以下是一个简单的Python代码示例来模拟loss曲线数据并辅助分析(这里只是简单生成数据示意,实际情况更复杂):

import numpy as np

import matplotlib.pyplot as plt

# 假设150轮和200轮的loss数据

loss_150 = np.array([0.5, 0.4, 0.3, 0.25, 0.22, 0.2, 0.18, 0.16, 0.15, 0.14, 0.13, 0.12, 0.118, 0.119, 0.117])

loss_200 = np.array([0.5, 0.4, 0.3, 0.25, 0.22, 0.2, 0.18, 0.16, 0.15, 0.14, 0.13, 0.12, 0.118, 0.119, 0.117, 0.11, 0.1, 0.09, 0.08, 0.07, 0.06])

plt.plot(range(1, len(loss_150)+1), loss_150, label='150 rounds')

plt.plot(range(1, len(loss_200)+1), loss_200, label='200 rounds')

plt.xlabel('Rounds')

plt.ylabel('Loss')

plt.legend()

plt.show()

通过观察这个简单生成的loss曲线,就可以更直观地判断在不同轮数下模型的表现,从而辅助决定合适的训练轮数。

希望以上解答对您有所帮助。如果您有任何疑问,欢迎在评论区提出。

关注

关注